Вот уже несколько лет LSI-копирайтинг (использование в SEO-текстах “слов, задающих тематику”) остается крайне модной тенденцией. За это время здравая в основе идея успела обрасти мифами и чересчур смелыми трактовками.

Выжимка: что оптимизаторы и копирайтеры думают о LSI

Если читать подряд все, что написано по теме, то вырисовываются следующие тезисы.

- Аббревиатура расшифровывается как latent semantic indexing – скрытое семантическое индексирование.

- Текст для продвижения должен включать тематичные слова, а не только ключевые.

- К LSI-словам относятся а) синонимы основного ключевика б) слова, которые характеризуют и дополняют основной ключевик в) другие слова, имеющие отношение к теме статьи.

- LSI – это специальный новый алгоритм поисковиков против плохих SEO-текстов, “новая эра в копирайтинге”.

- Также алгоритм нужен чтобы отличать тексты по смыслу. Например, чтобы разделить описание фильма “Тачки” от характеристик садового инвентаря.

- А еще LSI-текст должен иметь структуру, быть написанным простым языком, иметь приятный ритм, правильно распределять ключевые слова и тематичные расширения. Информация должна быть подана на уровне эксперта без грамматических и орфографических ошибок.

- Чтобы найти LSI, можно использовать подсказки поисковой системы, подсветки на выдаче, анализ текстов конкурентов (и сервисы, которые все это автоматизируют).

- Кое-где даже проскакивают заголовки “LSI убило SEO!” (ссылка, которую я автоматически вставляю после очередных похорон моей профессии).

Я только что сэкономил вам несколько часов на перелопачивание десятков статей по теме. Теперь попробуем разобраться, что тут правда, а что миф. А главное – как можно использовать это знание на практике.

Что такое LSI на самом деле?

Вот краткий и академически точный ответ:

Это видео стало сеошным мемом – нагромождение терминологии вызывает смех. На мой взгляд, довольно странно бояться незнакомых терминов, если под рукой есть Google. Чтобы разобраться в матчасти на бытовом уровне, не надо быть профессором.

Например, можете почитать статью “Тематическое моделирование текстов на естественном языке” (авторы Антон Коршунов, Андрей Гомзин), она раскрывает эту и несколько смежных тем на весьма доступном уровне. Приведу несколько ключевых цитат.

Сначала о важности метода:

Зачастую документы, релевантные запросу с точки зрения пользователя, не содержали терминов из запроса и поэтому не отображались в результатах поиска (проблема синонимии). С другой стороны, большое количество документов, слабо или вовсе не соответствующих запросу, показывались пользователю только потому, что содержали термины из запроса (проблема полисемии).

В 1988 г. Dumais et al предложили метод латентно-семантического индексирования (latent semantic indexing, LSI), призванный повысить эффективность работы информационно-поисковых систем путём проецирования документов и терминов в пространство более низкой размерности, которое содержит семантические концепции исходного набора документов.

А теперь о том, как он реализуется.

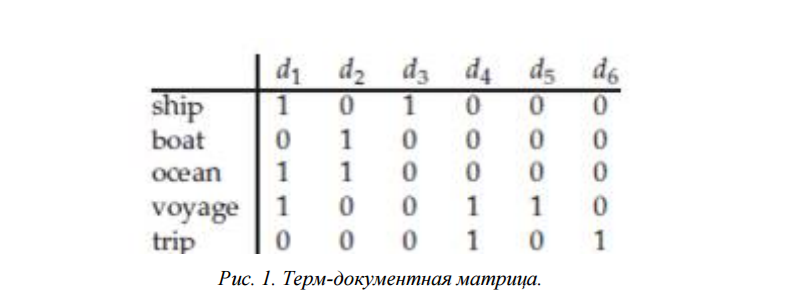

Исходная точка – это терм-документная матрица:

Элементы этой матрицы содержат веса терминов в документах, назначенные с помощью выбранной весовой функции. В качестве примера можно рассмотреть самый простой вариант такой матрицы, в которой вес термина равен 1, если он встретился в документе (независимо от количества появлений),и 0 если не встретился.

d1-d6 – документы, в первом столбце – термины.

Легко видеть, что некоторые термины встречаются вместе в одном документе а другие – нет. Поисковые системы обладают базой текстов, которая в полной мере отражает особенности естественного языка. Это позволяет создавать огромные терм-документные матрицы и на их основе делать достоверные выводы о взаимосвязях между словами и принадлежности текстов к той или иной тематике.

Однако огромный размер хорош только в плане статистической достоверности. Напрямую работать с матрицей, которая получена из миллиардов текстов, невозможно, так как требует слишком больших машинных ресурсов. Вот тут и нужно сингулярное разложение – математическая операция, которая позволяет упростить терм-документную матрицу, выделив из нее только самые значимые тенденции. Это и есть “проекция в пространство более низкой размерности, которое содержит семантические концепции исходного набора документов”.

(С матчастью практически закончили, дальше пойдет ближе к практике. Если интересуют детали – обратитесь к статье на habrahabr, где разобран простой рабочий пример и показаны этапы разложения).

Для нас больше всего важна последняя цитата, которая поясняет конечную цель всех этих процедур с точки зрения поисковой системы:

Для задач информационного поиска запрос пользователя рассматривается как набор терминов, который проецируется в семантическое пространство, после чего полученное представление сравнивается с представлениями документов в коллекции.

Именно так и можно найти документ, который релевантен по смыслу, хотя и не содержит ключевых слов запроса, то есть не обладает текстовой релевантностью в классическом понимании.

А еще поисковик может сравнить представление текста конкретной страницы с эталонными документами конкретной тематики. Если они будут сильно различаться – это серьезный сигнал о том, что с текстом что-то не так.

Например, типичный SEO-текст образца 2008 года состоит из “воды” и специально вставленных ключевых слов. “Вода” в нашем семантическом пространстве будет толкать текст к документам общей тематики, а ключевые слова – наоборот к конкретной теме. Это несоответствие не так сложно выявить.

Недостатки LSI как метода оценки смысла текста

Даже после поверхностного знакомства с методом, вы обязательно заметите, что LSI – это не магия, а всего лишь методика анализа текстов. Более того, она имеет ряд недостатков и упрощений:

- Текст в этом методе рассматривается просто как “мешок слов”. Игнорируется их порядок и взаимосвязи в предложении.

- Считается, что слово имеет единственное значение.

- Смысл естественного текста не обязательно совпадает со значением набора слов. Иносказание, ирония, подтекст таким образом не распознаются.

- Сингулярное разложение позволяет работать только с самыми значимыми составляющими исходной матрицы. Часть данных при этом все равно теряется.

Почему я заостряю на этом внимание? Потому что теперь мы видим полную картину и наконец можем сделать несколько важных промежуточных выводов. Вернемся к началу статьи и трезво посмотрим на распространенные убеждения. Итак.

Что нужно понимать, приступая к LSI-копирайтингу

Во-первых, не стоит думать, что LSI – это волшебная таблетка.

Совершенно очевидно, что поисковые системы используют множество методик для определения “спамности” или “полезности” текста. Скрытое семантическое индексирование не универсально, у него есть недостатки. Поисковики безусловно знают о них. Если они и применяют LSI (что не доказано) то наверняка в комплексе с другими факторами. Например, огромное количество данных о качестве текста дают поведенческие метрики.

Так что просто натыкать в водянистый текст тематичных слов – не лучшая стратегия в долгосрочной перспективе.

Во-вторых, нет смысла приравнивать написание хороших текстов в LSI-копирайтингу.

А именно это и происходит. Вот скриншот из Википедии о LSI-копирайтинге:

Зачем присобачивать принципы, известные со времен этак Гомера, к одной узкой методике?

В-третьих, LSI в чистом виде – история в первую очередь про “угадывание” смысла запроса, классификацию документов по темам и фильтрацию спама, и только во вторую – про ранжирование.

Недавно делал конспект докладов об устройстве Яндекса. Там есть очень показательный момент. Александр Сафронов рассказывает о направлениях по лингвистике для улучшения качества поиска. В том числе о синонимах и о связанных расширениях, уточнениях, похожих запросах. То и другое принято объединять под ярлыком “LSI”. Но!

Распознавание синонимов – это в большей степени “боль” самой поисковой системы. Там понимают, что текст может быть качественным и релевантным, даже не включая все варианты. Например страница с вхождением “купить” может прилично ранжироваться по ключам “покупка”, “приобрести” и так далее.

А вот про расширения запроса Александр Сафронов четко говорит:

Скорее всего, релевантный документ, помимо слов запроса, будет содержать эти дополнительные слова (если он действительно хорошо отвечает на запрос пользователя).

Пример дополнительных слов:

Заметьте, кстати, что здесь мы видим связи не только между отдельными словами. Поэтому очевидно, что для выделения расширений используется другая методика, а не LSI.

Второй нюанс в том, что базой для их получения является не только коллекция текстов, но и поисковые запросы. Их использование – это возможность для поисковика искать связи не по формальным критериям (встречаются ли в одном тексте или нет). Вариант: анализ связей между группой запросов, которую задал один пользователь в короткий промежуток времени (разумеется, с объединением данных по миллионам пользователей).

В-четвертых, для нахождения LSI требуются алгоритмы, работающие с довольно большим объемом текста.

Самый простой и часто предлагаемый путь – парсить подсветки Яндекса – и всегда работал не очень хорошо, давая очень скудный спектр слов, сейчас вообще малоактуален.

В-пятых, слова, которые предлагают сервисы, не являются результатом “настоящего” LSI или его аналога, с которым работают поисковые системы (дальше эта оговорка упускается для краткости и как дань сложившимся понятиям).

Пункт прямо следует из предыдущего. Очевидно, что сервисы не имеют всех возможностей поисковика. Или, по крайней мере, не знают, на какой коллекции документов он определяет закономерности для себя. Тем не менее, связанную лексику сервисы могут генерировать неплохо. Для получения адекватного списка нужно как минимум работать с текстами из ТОПа по запросу (и лучше ТОП-50, а не ТОП-10). При этом, разумеется, тексты в ТОПе должны быть достаточно высокого качества. По низкочастотным запросам не всегда удается набрать достаточную базу.

Как правильно готовить LSI-тексты?

Ну вот мы и добрались до главного.

Если вы внимательно читали предыдущую часть, то могли задаться вопросом – а надо ли вообще этим заморачиваться? Ведь:

- Метод не идеален, имеет множество ограничений.

- Поисковики явно используют куда более сложные алгоритмы.

- Для получения адекватного списка нужна хорошая выборка данных, которую не всегда просто получить.

- Сами слова, задающие тематику, важны в первую очередь для защиты от фильтров. Конкретно в ранжировании помогают скорее не классические LSI-слова, а расширения из поисковых запросов.

- Писать тексты с LSI – значит дополнительно напрягать копирайтера. Иначе говоря – отвлекать его внимание от других важных элементов текста и оплачивать труд по более дорогой ставке. А еще – подсказывать путь, как можно написать статью внешне качественно.

- При этом все равно есть риск получить водянистый текст с кое-как вставленными терминами.

Я считаю, что мода на LSI (как и в случае большинства трендов) в значительной мере подогрета искусственно. Это в первую очередь способ позиционировать свои услуги по написанию текстов как более качественные либо продвинуть сервис по поиску тематичных слов. По крайней мере, у меня сложилось именно такое впечатление после чтения англоязычных материалов.

При этом зарубежные SEO-шники не особо утруждают себя поиском доказательств. Скриншот типичной статьи с советами по SEO:

(Привет всем, кто любит повторять мантру, что, дескать, интернет-маркетинг в России отстает на 3 года. В русскоязычных материалах я в целом видел более критичное отношение к теме, а сервисы в Рунете позиционируют свои услуги куда более аккуратно, не выдавая за волшебную кнопку. Впрочем, это субъективное наблюдение, чисто личные впечатления. Возможно, мне попались не те статьи. На Западе их очень много.)

Однако! Несмотря на все минусы, использовать LSI можно и нужно. Требуется только делать это эффективно и учитывать приведенный выше перечень проблем.

Мой вариант использования LSI

Схема очень простая.

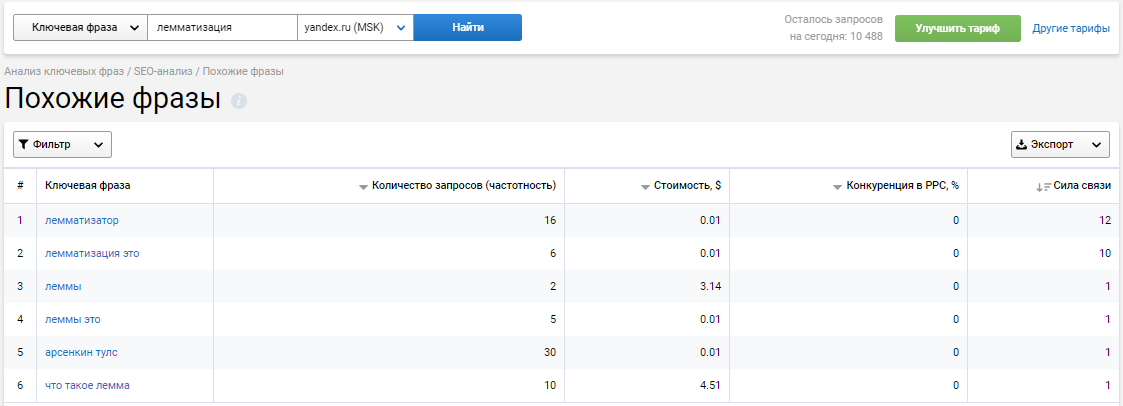

1. Получаем список тематичных слов для каждой темы, которую планируем отдать копирайтеру. Сохраняем их леммы. Можно использовать бесплатный сервис Александра Арсёнкина: https://arsenkin.ru/tools/sp/ или платные текстовые анализаторы (убедитесь только, что они не ограничиваются парсингом подстветок). Так, у Serpstat есть интересный отчет “похожие фразы”, который создается на основе статистики, по каким запросам наблюдается выдача со сходным составом. Там порой можно накопать неожиданные термины.

Например:

Видим, что в отчет попали “арсенкин тулс”, которые относятся к лемматизации именно по смыслу, а не формальному сходству слов.

2. Однако в ТЗ копирайтеру слова НЕ указываем. Главная задача – получить от него адекватный, решающий задачи пользователя текст. Именно на это и должен быть акцент.

3. Полученные на проверку тексты прогоняем через лемматизатор (тоже есть у Арсёнкина: https://arsenkin.ru/tools/lemma/ и у меня в сервисе: https://bez-bubna.com/free/lemma.php); результат сравниваем со списком LSI-лемм из первого этапа. Для быстрого сравнения списков можно использовать, например: https://bez-bubna.com/free/compare.php

4. Если значительной части LSI-лемм в тексте нет – смотрим его внимательнее. Возможно, с качеством текста что-то не в порядке. Если все хорошо и статья дает нормальный ответ на запрос – вставляем слова и публикуем. Если же есть проблемы – отправляем на доработку. Снова требуем сделать хорошо, а не просто добавить терминов.

В чем соль?

Во-первых, мы не смущаем копирайтера лишними требованиями.

Во-вторых, получаем полу-автоматический критерий для отбраковки плохих статей. Нормальный, человеческий текст будет содержать много LSI без всяких напоминаний. Если, конечно, тематичные слова были собраны корректно.

В-третьих, экономим собственное время на разбор LSI. Просто так выгрузить из сервиса слова и отдать на внедрение не получится. В них все равно будет попадать термины из смежных тематик (и не только: ошибок может быть много). Если давать LSI в ТЗ – придется чистить все результаты. Если использовать по моей схеме – только некоторые.

Завершающий этап: усиливаем текст новыми расширениями

После публикации текста нужно подождать пару месяцев, пока накопится статистика по переходам на него, а затем переработать контент, учитывая реальные запросы пользователей.

Выше я цитировал доклад сотрудника Яндекса, из которого следует, что наиболее эффективный путь получения дополнительных тематичных слов – работа с поисковыми запросами. Именно на основе этой идеи реализован инструмент по дополнительной оптимизации страниц в моем сервисе https://bez-bubna.com/ (точнее, его часть).

Общий принцип очень прост: смотрим состав поисковых запросов, сравниваем с текстом на странице и находим леммы, которые отсутствуют в тексте, но часто встречаются в запросах. Почему это работает?

Забудем о докладе Яндекса. Допустим, слова из запросов не имеют влияния на продвижение основного ключа (главная функция LSI). Тогда они способствуют продвижению по множеству низкочастотных запросов, которые немыслимо предусмотреть на этапе написания. Особая прелесть здесь в том, что можно исправить недостаточно эффективное семантическое ядро, быстро расширить семантику страницы.

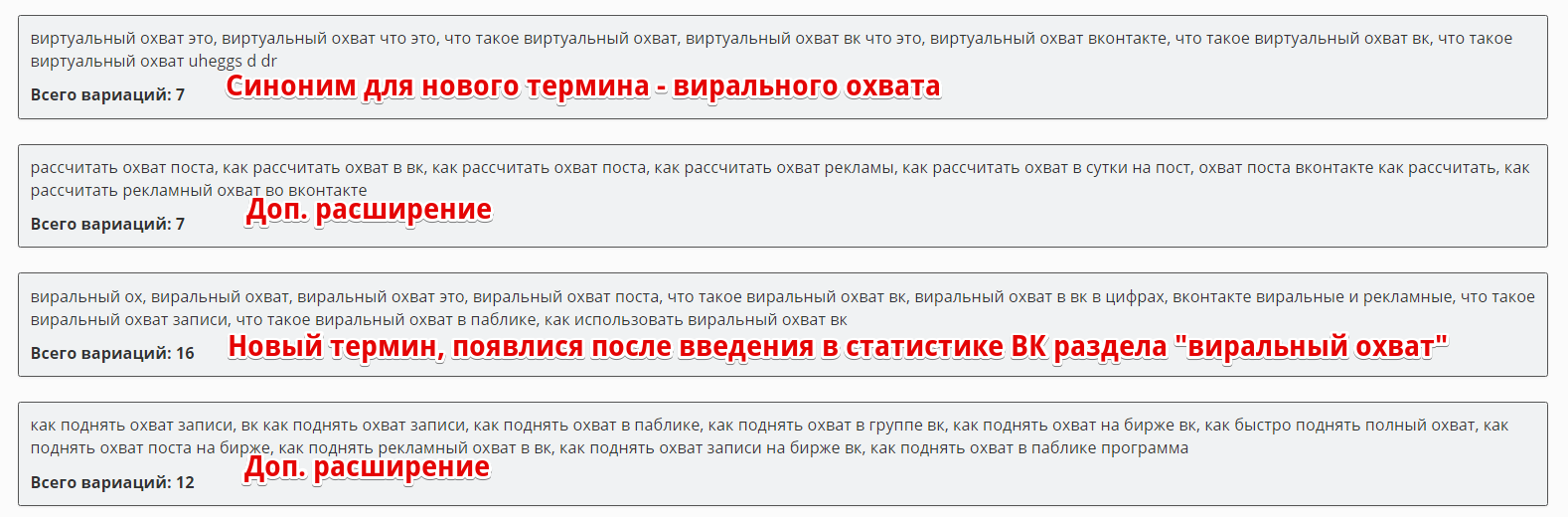

Кроме того, поисковый спрос нестабилен. Появляются новые запросы, под которые еще очень мало контента в Интернете. Используя сервис, вы имеете шанс поймать эти перспективные ключи с малой конкуренцией и сделать контент более актуальным.

Вот пример – скриншот анализа моего поста об охвате записи ВК:

Метод эффективен даже в самом топорном исполнении – см. эксперимент по автоматической вставке ключей. На практике же требуется не просто впихивать новые расширения, но и добавлять контент (или по-новому расставлять акценты), чтобы страница давала адекватный ответ на эти новые запросы.

То есть: проработка страницы с помощью инструмента выходит за рамки простой текстовой оптимизации. Это работа сразу по нескольким фронтам, настоящее повышение качества контента. Это окупается (см. кейс с расчетом рентабельности: в нем не только вырос трафик, но и снизился процент отказов).

Короткие выводы для тех, кто пролистал, не читая

- LSI – один из современных подходов к анализу текстов. Имеет ряд ограничений и недостатков, это не единственный метод, который используют поисковые системы.

- Анализ связанной лексики наиболее эффективен в определении малоценных “водянистых” текстов и нахождении документов, которые могут соответствовать потребностям пользователя, хотя и не содержат ключевых слов, которые он ввел. Важность LSI как такового для ранжирования страниц с ненулевой текстовой релевантностью сомнительна.

- Использовать списки LSI-слов, которые генерируют разные сервисы, лучше всего на этапе приема работ для быстрой оценки и дополнительной оптимизации. В ТЗ же стоить включать более близкие к реальности критерии качества текста.

- Завершающий этап работы со страницей – усиление контента с помощью расширения семантики и проработки в плане интересов пользователя, которые не были приняты в расчет в начале (исходная точка – реальная статистика по запросам, которые давали трафик на страницу). На данный момент единственный публичный инструмент для автоматизации этого этапа есть в сервисе https://bez-bubna.com/.

Удачной работы!

На практике нужно писать нормальный экспертный контент под свою ЦА, а не заниматься технической дрочью с копирайтерами “по писят за тысячу”.

Bingo!

Про экспертный контент согласен, но поисковые машины пока не идеальны. Поэтому за семантикой тоже нужно следить. В моей практике есть примеры, когда без глобальных изменений на странице, после добавления нескольких ключевых слов увеличивался поисковый трафик. При этом экспертность и качество контента никак не менялись, только несколько нужных слов в нужной форме.

Именно это хотел написать. Надо читать про SEO, но инфы столько, что уже не усваивается – в мозгу нет свободного чипа памяти. Зато ВСЯ инфа укладывается и не опровергает этих несколько слов: “будьте естественны и сами собой, сайт зеркало вашей души и деятельности, ведите себя открыто, дайте что-то новое и полезное, раскрывайте темы и вопросы качественно, пишите, что хотите сказать и донести, дополняйте тем, что хотят услышать — и будет Вам SEO”

Прочитал! Одобряю

Я всегда воспринимал LSI-текст как продукт вычисления всех запросов и ключей конкретной темы и раскрытия их в тексте, чтобы спрогнозировать все НЧ-запросы в будущем.

Да методика Яндекса не сложная в этом плане. Берем все дополнительные запросы из поиска (уточняющие) + ищем общие вхождения ключевых слов не свойственных ключам.

А далее тоже самое проворачиваем на большой выборке для несвойственных ключей в отношении к главному ключу.

Вопрос в другом: данным методом можно практически выжечь весь копирайтинг и рерайтинг написанный людьми которые ничего не понимают в том что пишут. Значить что то не так – или не хватает мощностей или методика не совершенная.

За видео спасибо-)

А тебе спасибо за горсть отсыпанных букв, Миша!

Алексей привет! Правильно ли я понял, что в целом, если рассуждать по лайту, нужно наполнять документ словами входящими в спектр тематики и уменьшать кол-во воды текста, чтобы не размазывать семантические границы?

Михаил, более-менее верно.

Только в принципе достаточно и просто уменьшать воду, писать по делу – тогда слова из тематического корпуса естественным образом окажутся в тексте. А главное – он будет соответствовать другим критериям качества (которых у поиска немало). Другой вопрос, как масштабировать написание таких текстов (и не платить за них бешеные деньги). Вот тут и пригождаются тематичные слова (на этапе проверки).

Ну вопрос масштабирования можно как вариант перенести на подчиненных контент-менеджеров. Я согласен полностью – главная задача авторов писать грамотные текста. Задача веб-мастера (владельца бизнеса, называйте как хотите) – вписать ключи в статью, тем самым помочь ПС “понять о чем текст”.

Этим и будут заниматься КМы, + им поручить работу не только по вписыванию ключей, но и по вписыванию lsi ключей/леммов.

Есть еще один вопрос, скорее на подумать. При применении инструмента https://arsenkin.ru/tools/sp/ мы получаем список лемм задающих тематику, но они берутся все таки из топа или статистики ПС в целом. Но важно понимать, что ТОП – не всегда показатель (даже первые 50 страниц) – большим плюсом было бы использование дополнительных слов, входящих в данный тематический спектр, но не фигурирующих ни в тексте, ни в словах задающих тему (из инструмента выше). Но эти слова нужно откуда-то брать и где-то хранить. А объемы, к примеру, нашего производства достаточно большие и проекты разнотематичные – простого словарика будет не достаточно (исключая условие его активного пополнения). Вопрос в том, откуда брать такие слова (использование синонимов, к примеру, не думаю что даст серьезных результатов).

У меня уже ночь, прощу прощения если описал не ясно)

Ну, например just-magic.org обещает полноту данных. Но я не думаю, что стоит сильно упираться в этом моменте. Полнота, конечно, хорошее дело, но может сделать процесс более медленным и дорогим, а также увеличить число ложных срабатываний – когда приличный текст отправляется на проверку.

не могу ответить на ваш коммент, проблема в верстке, нет кнопочки “ответить” 🙂

Спасибо за ресурс, гляну.

Тема очень интересна, пишите еще)

Хорошо 🙂

Алексей, взорвал мне мозг 🙂

Чем именно? 🙂

p.s. Заглянул на блог. Добро пожаловать в клуб!

Поймал себя на мысли, что в первый раз прочитал статью на этом блоге не как человек, а как машина. Причина обнаружилась в середине текста: “Зачем присобачивать принципы, известные со времен этак Гомера, к одной узкой методике? ” Заголовки, ключевые слова, словарные подмножества для различных тематик, соответствие возможным подсказкам поисковиков (я же не робот, в конце концов, точно не проверить). Одним словом хорошее место статье в пантеоне запросов “LSI копирайтинг” рунета обеспечено. Да еще комментарии тематические.

А если серьезно, то возникает два вопроса: использование всего этого “счастья” для взаимодействия с копирайтерами или для адаптации собственного творчества – с одной стороны, и возможность для машинной генерации текстов – с другой. Вопросы обозначены и наверняка кто-то в частном порядке найдет для себя решения, но как поиск священного грааля работать по теме можно бесконечно.

Сергей, плохо понял первую часть коммента 🙂

Мне кажется тут закралась ошибка “Во-третьих”. В целом материал объемный и чувствуется что за ним стоит большой труд по анализу.

А по поводу сервисов, есть еще seo-title.ru, как вариант можно выгрузить слова и сниппета и подсветки.

Спасибо за замечание! Поправил.

Спасибо, дождалась, Алексей! Сейчас я задам пару “женских” вопросов, можно?

Поскольку я всё таки не сеошник, то многое не поняла, хотя читала три раза.

Мой вопрос:

если в сервисе bez-bubna на мою топовую статью выданы LSI-слова, на которые, скорее всего, пользователь не найдет полноценный ответ в тексте, то их желательно вставить в текст? Статья в Топ-1 и таких немало (по ВЧ-запросу). Это не приведёт к их выпадению из Топ-1? Боюсь я…

Заранее благодарю. И сильно не смейтесь, плиз! Ведь не владея многими знаниями, я их, всё таки, вывожу в топ…

Галина, пожалуйста! Вопросы совершенно уместные.

Правильно, я за то, чтобы не трогать то, что работает. Если статья собриает трафик по высокочастотнику, лучше не рисковать им ради мелочи по микро-НЧ. Соберите предлагаемые темы на другую страницу и перелинкуйте со старой.

Исключение – если видите, что по каким-то ключам прямо огромный показатель отказов, хотя по запросу предплагается вдумчивое чтение. Лучше поработать на перспективу и обеспечить пользователей адекватным контентом. Пояснение на картинке: http://alexeytrudov.com/wp-content/uploads/2017/03/2017-03-1518.58.10.png

Благодарю! Вот теперь я поняла! Нет, процент отказов не 50, он НИЖЕ 10%. Но отдельную статью можно на эти крохи написать – корона не упадёт.

🙂

Да, в таком случае отдельная статья должна быть хорошим решением.

Я думаю, что LSI это шляпа и лежит она на одной полке с понятием кластеризация =)

Смешно парсить подсветки в выдаче! При чем тут они? Нужно смотреть на саму страницу, ее элементы и включать голову, а не искать волшебные кнопки и сервисы. Это бред: arsenkin.ru/tools/sp/ – попробовал.

4 пункт в выводах толковый, этим и нужно заниматься. Надо бы добраться до твоего сервиса, потестить.

Это в идеале) А если стоит задача масштабировать процесс – нужны костыли.

Про подсветки я так и пишу. А сервис Александра не только их собирает, там еще и обработка текстов в топе идет.

Welcome! Надеюсь скоро сделать релиз, там будет традиционная скидка 🙂

“Это бред: arsenkin.ru/tools/sp/ — попробовал.”

Согласен, тоже попробовал, на выходе получил бред, а не LSI.

Хотя сама задумка с LSI – хороша, хоть один шаг к качественному контенту, а не УГ с ключами.

Доброй ночи! А приведите примера – бреда!

Ну и сервис не говорит про получение LSI. Он всего лишь предлагает слова, которые задают тематику запросу, только всего.

Ну нужно путать одно с другим.

И опять радуешь крутым материалом о том, о чем слышал только звон и давным-давно хотел узнать подробности, но недосуг было копать, ибо все таки не профиль пока. В целом как-то так смутно и представлял себе понятие, но думал что наверняка упускаю что-то при работе над контентом. Оказалось нет, интуитивно делалось практически в соответствии:) В общем, одним пробелом в моем дилетантском познании SEO стало меньше, спасибо. Буду отправлять сюда км-ов, просвещаться при случае 🙂

Спасибо 🙂

Хорошая статья.

Согласен с пунктом третьим заключения.

Пожалуй, это – основная мысль статьи.

Спасибо! Третий пункт, да, очень важен.

Алексей, а как подобные сервисы находят вобще подобные слова расширения? я к тому, что может они лишние слова туда вставляют или наоборот не все.

Есть разные методики.

Например, технологии машинного обучения (погуглите word2vec). Но в большинстве случаев – просто парсинг и анализ выдачи (сниппетов) или текстов из сайтов в ТОП. Точность везде действительно под сомнением, поэтому я и не рекомендую использовать напрямую.

Здравствуйте. Можно пояснить для “особо одаренных” этот момент – “а затем переработать контент, учитывая реальные запросы пользователей.” Что означает перерабатываем? Берем словоформы и пишем их в текст, как люди ищут (условимся, что текст все таки отвечает на вопросы пользователя как нужно, а не является просто текстом со словами)? Или все же пытаемся найти дополнительные смыслы, которые каким-то образом были упущены и расширяем текст (то есть не так со словами работаем как со смыслами)?

Андрей, разумеется в приоритете найти дополнительные смыслы. Поисковики уходят от простой опоры на ключи. Нужно, чтобы текст решал проблемы (даже те, которые пользователь не до конца осознал)

Я так и подумал, но спросил потому что, как я понимаю, мы тут больше разговор ведем вокруг информационных текстов. И где грань между тем, чтобы дополнить статью или уже накатать следующую? Например, вот мы читаем про установку окон, но тут речь пошла поменять или сделать ремонт и человеку уже интересно, а правда, может ремонт провести. И тут как бы одна только оценка состояния окна может на статью затянуть, не говоря уже про сам ремонт. А возвращаясь к ключам, если выносить в отдельные страницы, то слова уже там будут использованы, а не тут.

Да, инструмент актуален для контентных сайтов и описания услуг.

Грани действительно нет.

На мой взгляд, нужно ориентироваться на: а) насколько тема раскрыта в исходной статье (если по теме уже есть какой-то контент, то проще его дополнить; если затронуто совсем по касательной – нужна новая статья.) б) насколько “страшно” трогать текущую страницу (чтобы не поломать текущую оптимизацию). в) сколько новых ключей найдено и как они соотносятся между собой (иногда как раз набирается на новый материал).

Да важная информация. Экономия сил. У Арсенкина два вида лемм:

1. Лемматизированные подсветки.

2. Лемматизированные слова из запросов.

И еще считаю важные слова:

3. Слова задающие тематику.

Скажите пожалуйста какие пунты важнее или все вписать в тест лучше будет?

Для задач контроля (как описано в конце), видимо, подойдут сразу все. Надо понимать, что это не жесткое требование к автору, а просто способ поймать подозрительные тексты до публикации.

осмысленно написано. спасибо

Это моя 17-ая статья за сегодня по LSI. Очень неплохо написано.

Допустим даже влияния на продвижение основного ключа (главная функция LSI) слова из запросов не имеют. – нужно поменять предложение, очень сложно понять. Допустим, что слова из запросов не имеют влияния на…

Спасибо, поправил 🙂

Алексей, здравствуйте

Я в нужный момент получил Вашу статью. Небо прояснилось. Вышел из тупика.

Возможно это временное явление, однако просвет и я готов к дальнейшим действиям. Спасибо

Супер! Удачи!

Спасибо, очень интересная и полезная статья. Сингулярное разложение терм-документной матрицы порадовало)))

Раньше искал только СЯ, нет ключевого слова в запросе — нет этого слова на странице. Хотя я никогда не понимал, как можно писать об автомобилях, но ни разу не упомянуть слова типа двигатель, кузов, скорость, колёса и т. д. Попробовал собрать LSI через Серпстат и инструмент Арсенкина, в принципе, почти все слова и так у меня есть, просто потому что их невозможно не упомянуть. Но кое-что новое всё равно находится. Буду работать дальше в этом направлении, спасибо!