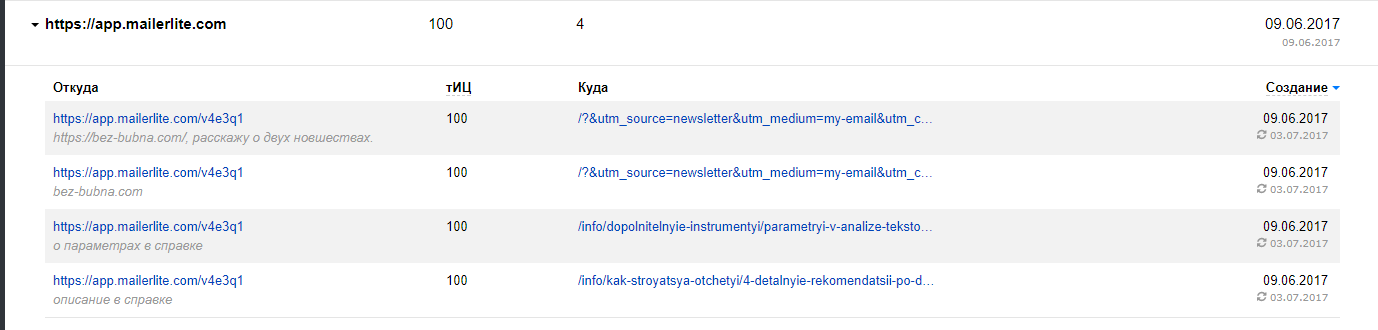

Пару месяцев назад заметил в Вебмастере ссылки на https://bez-bubna.com/ со страницы, которая содержала мета-тег robots с директивами noindex,nofollow.

Донор – это страница просмотра письма из рассылки: https://app.mailerlite.com/v4e3q1

Ход эксперимента

Разумеется, я сразу захотел проверить, учитываются ли такие ссылки в ранжировании. Оценивать ссылочные тексты со скриншота не было смысла. Страница – это копия нормального поста с блога, идентичные анкоры стоят со страницы в индексе.

Поэтому пришлось создать несколько новых страниц, индексация которых была запрещена мета-тегом и поставить с них ссылки с уникальными анкорами. Вот три примера:

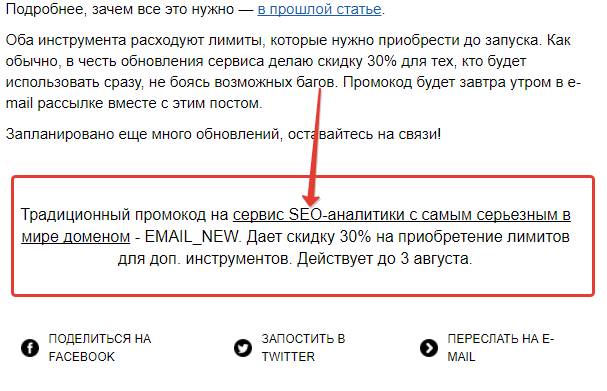

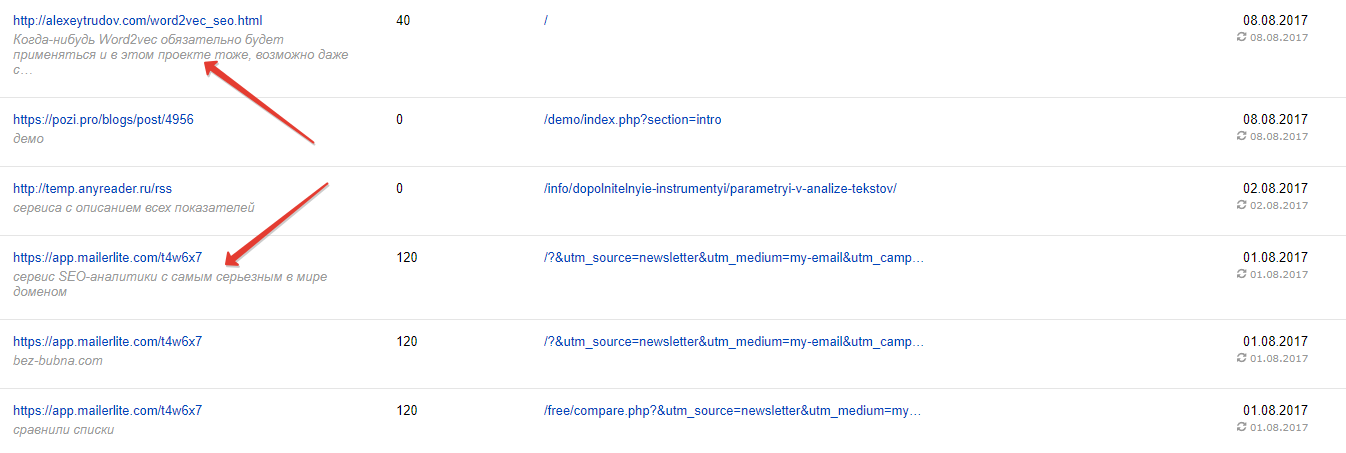

https://app.mailerlite.com/t4w6x7

Еще один пост из рассылки. Внизу я разместил блок с промокодом для сервиса и ссылкой на него:

В самом посте этого текста не было.

Ссылку я закинул в биржу prospero и купил 5 твиттов с ней (см. инструкцию по этому способу ускорения индексации). За прошедшее с момента написания поста время ситуация довольно сильно изменилась, на задание откликнулись в основном типичные аккаунты-боты.

https://preview.mailerlite.com/t4w6x7

То же самое, но на другом поддомене сервиса рассылок. Для завлечения поисковых ботов я попросил френдов в Twitter перепостить ссылку:

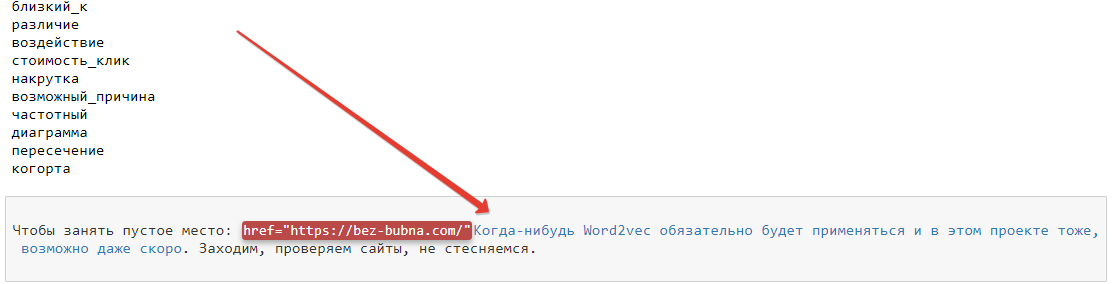

http://alexeytrudov.com/word2vec_seo.html

Это html-представление рабочего файла, где я тестировал word2vec. На него сослался прямо из поста про машинное обучение.

Внизу вы можете видеть длинный уникальный анкор:

Я создал еще несколько тестовых объектов для увеличения объема выборки, но они располагаются на непубличных (и не только моих) проектах, поэтому не демонстрирую их. Результаты аналогичны и не меняют выводов.

Показываются ли “закрытые” ссылки в Яндекс.Вебмастере?

Результат на сегодня:

Как видим, 1 и 3 ссылка отображаются в Вебмастере. Немного удивило, что не показывается вторая. Ведь на страницу, которая ее содержит, ссылались исключительно “живые” активные аккаунты в Twitter. Зато твитты с бот-ферм явно привлекли внимание робота. Впрочем, причины могут быть самые разные, начиная с разницы хостовых факторов между поддоменами “app” и “preview”. В любом случае, единичный пример – это только информация к размышлению.

Теперь самое главное.

Учитываются ли анкоры ссылок со страниц, запрещенных от индексации?

Любой желающий легко может убедиться что не учитываются.

Поиск по отображаемому в Вебмастере тексту (с кавычками и без) не приводит к нахождению https://bez-bubna.com/. Поиск по анкорам с нормальных страниц, попавших в индекс позже, дает ожидаемый результат в виде ТОП-1 для страницы-акцептора.

К слову, анализ ссылок с атрибутом rel nofollow дает обратный результат – они передают анкорный вес (подробно тут).

Выводы

- Не все ссылки, отображаемые Вебмастером, учитываются Яндексом в ранжировании. Неоднократно слышал мнения о том, что появление в разделе “Внешние ссылки” – критерий “рабочести”. Теперь очевидно, что это не так. Минус еще один SEO-миф.

- Несоответствие вполне логично: задача панели не в том, чтобы обеспечить оптимизатора данными о механизмах учета ссылок. Она нужна, чтобы предоставлять самую разнообразную информацию владельцу сайта; сфера ее применения не ограничивается SEO. Например, вебмастеру полезно знать, что его проект ругают или хвалят где-то на стороннем ресурсе – и неважно, что там написано в meta robots.

- Вопрос о передаче статического веса бэклинками с закрытых url остается открытым.

- Для практики: анализировать ссылки только через Вебмастер недостаточно. Донор может намеренно или случайно закрыть ссылающийся url от индексации. Картина в панели не поменяется, но анкорный вес вы потеряете.

- Закрытая от индексации часть сайта может анализироваться поисковыми системами и учитываться ими при ранжировании остальных страниц. В этом отношении пока нет достоверных исследований. Но чтобы подстелить соломку, стоит и на таких url избегать особых шалостей (например, переоптимизированного текста, индексировать который разрешено только Google).

Спасибо за эксперимент!

Есть некие размышления по первой ссылке. Написал подробности в ВК.

Стиль изложения довольно тяжел для восприятия, особенно первая половина. Хотя сам по себе предмет поста элементарный. Впрочем, может быть это особенности моего восприятия.

Любой эксперимент ценен, так что спасибо за работу!

Закрытая от индексации часть сайта может анализироваться поисковыми системами и учитываться ими при ранжировании остальных страниц. В этом отношении пока нет достоверных исследований.

Например, при выводе сайта из-под Бадена Платоны явно указывали, что закрытые от индексации в robots.txt страницы тоже нужно чистить от спамного текста. Так что вполне достоверно, что они учитывают все.

Спасибо за дополнение!

Алексей, добрый день! Вопрос не совсем в тему. Ранее пользовался плагином Ya share от Яндекса для кнопок соцсетей. После блокировок сервисов Яндекса в Украине, сайт очень долго стал подгружаться. Сделал правки в коде метрики, но долгие подгрузки были в основном из-за кнопок соцсетей этого плагина.

Пришлось отключить. Долго искал замену, пробовал с десяток самых популярных, но или множество внешних ссылок, или много лишнего кода. И вот заметил у вас плагин Likely. Заблокированне соцсети грузятся нормально, не тормозит загрузку страниц, код страницы не сильно расширяет. Только статистики по кликам нету. Как вам этот плагин, стоит ставить?

Заметил поставили блок подписки на комментарии (не subscribe to comment), чем этот понравился?

Илья, добрый день!

Да, Likely нравится, статистику можно собирать с помощью целей в Метрике https://yandex.ru/support/metrika/reports/add-goals.html#create_goal__javascript_event (у меня, впрочем, руки не дошли).

Пробовал несколько, subscribe to comment плохо вписался в шаблон, нужно было бы переверстывать. Этот (Lightweight Subscribe To Comments) вроде неплохо работает.

Добрый вечер! Спасибо за идею и вектор.

Посмотрел как настраивать через событие – javascript в Метрике и получается на каждую кнопку социальной сети нужно добавлять в код страницы свой код (кнопок соцсетей у меня сейчас 6). И получается хороший кусок кода будет дополнительно выводится с контентом.

Стараюсь на блоге использовать как можно меньше кода, чтобы поисковым системам было проще работать со страницами и соотношения кода к тексту было лучше.

Подумал, может есть смысл подключить коды Google аналитики, Яндекс метрики, коды консолей поисковых систем с помощью Google Tag manager. И заодно подключить в Tag manager шесть javascript событий (для шести кнопок) для отслеживания кликов по кнопкам шеринга соцсетей. Чтобы меньше кода было на страницах с контентом и выводилось все с помощью одного кода Tag manager.

Хотя не совсем понятно как будут относиться поисковые системы, есть ли для них разница, что вывод множества кодов через один код Tag manager или все коды размещать на страницах с контентом. Возможно роботы которые анализирую страницы, индексируют для ранжирования, не имеют доступ для анализа содержимого кодов в Tag manager. Как думаете?

Еще интересно, при подтверждении прав в Search консоли Google было подтверждение через Google analytics, а после добавления кода в Tag manager кода Google analytics уже не будет на страницах блога, то вероятно собьется право владения. Как бы это сразу отметить что права в Search консоли Google подтверждаются через Tag manager? Или не нужно будет менять способ подтверждения прав и Google так и будет использовать подтверждение через Google analytics, но уже с передачей данных с Tag manager? С Яндекс вебмастером при подтверждении через метрику видно тоже подобное

Пробовал ваш плагин Lightweight Subscribe To Comments – довольно легкий и удобный. В плагине Subscribe to Comments Reloaded чтобы внешний вид был похожим как у Lightweight Subscribe можно в настройках “Форма комментария” отметить эти два чекбокса: imger.ru/jpg/r3aor8eElMnOd9c2/

Пожалуйста, рад, что помог.

Насчет таг менеджера – думаю хорошая идея, чисто даже для удобства. В плане поисковых систем не думаю что будет большая разница.

С подтверждением не знаю, я всегда через файл делаю, по-моему так даже удобнее.