Недавно я описал “сеть для ботов” – подход к повышению полноты индекса на больших сайтах. Способ основан на эффективной внутренней перелинковке, которая одновременно работает на:

а) улучшение структуры проекта для пользователя;

б) увеличение доступности документов для роботов поисковых систем.

Это становится возможным благодаря анализу логов доступа и накоплению статистики активности ботов-индексаторов.

Пост, который вы сейчас читаете – прямое продолжение описанной статьи. Здесь пойдет речь о применении метода в других аспектах оптимизации. Они актуальны даже для сайтов, которые не испытывают серьезных проблем с полнотой индекса. Рекомендую ознакомиться с первой частью, если вы этого еще не сделали – так будет проще разобраться.

Как работает “сеть для ботов”

Если рассматривать только “сеть для ботов” саму по себе, то становится очевидным ее важный недостаток. Это относительно высокая сложность разработки и интеграции с сайтом. Вообще-то для нормального программиста работы здесь немного. Есть огромное количество готовых решений для ряда этапов процесса, просто требуется грамотно их скомпоновать. Главное же в том, что

Система нужна не только и не столько для “подсовывания” роботу непроиндексированных страниц.

Это лишь одна из задач. А конечная цель – создать систему сбора важной информации и инструменты для ее использования в структуре сайта.

Фундамент такой системы – база данных со сведениями о каждой странице сайта. Специальный скрипт регулярно делает анализ acess.log и обновляет базу. Оперативность здесь не слишком важна, можно запускать скрипт пару раз в час. Для расширения доступных сведений неплохо будет подключить и другие источники информации (консоли веб-мастеров, SEO-сервисы и т.д).

Но даже работая просто с acess.log можно соорудить что-то вроде этого (скрин из PhpMyAdmin – интерфейса для управления базами данных; кликабельно):

Это фрагмент структуры реальной таблицы с данными. Как видите, для каждой страницы сайта собирается информация о:

- количестве визитов роботов Google и Яндекса;

- датах первого и последнего захода роботов;

- датах и количестве посещений живыми пользователями каждой из поисковых систем.

К первой статье были вопросы о том, как именно работает система. Теперь должно быть более понятно.

Мы просто отдаем в перелинковке высший приоритет тем страницам, где и yandexbot_visit_first = 0 и googlebot_visit_first = 0. Приоритет чуть меньше – тем, где yandexbot_visit_first = 0 и googlebot_visit_first больше 0 то есть было посещение только Googlebot-ом. Уловили принцип? Уверяю вас, для программиста, который хотя бы отдаленно знает, что такое базы данных, реализовать подобный алгоритм не составит никакого труда.

Но вернемся к таблице. В ней не так уж и много информации, правда? Скриншот может выглядеть устрашающе, но ничего особенного в нем нет. Эти сведения запросто соберет любой владелец сайта.

Прелесть в том, что нехитрые записи о визитах, помноженные на огромное количество страниц (мы ведь говорим о больших сайтах!) дают внушительный массив информации, которую можно и нужно использовать как для SEO-исследований (простейший пример), так и для принятия рутинных решений по продвижению конкретного проекта.

Примеры использования

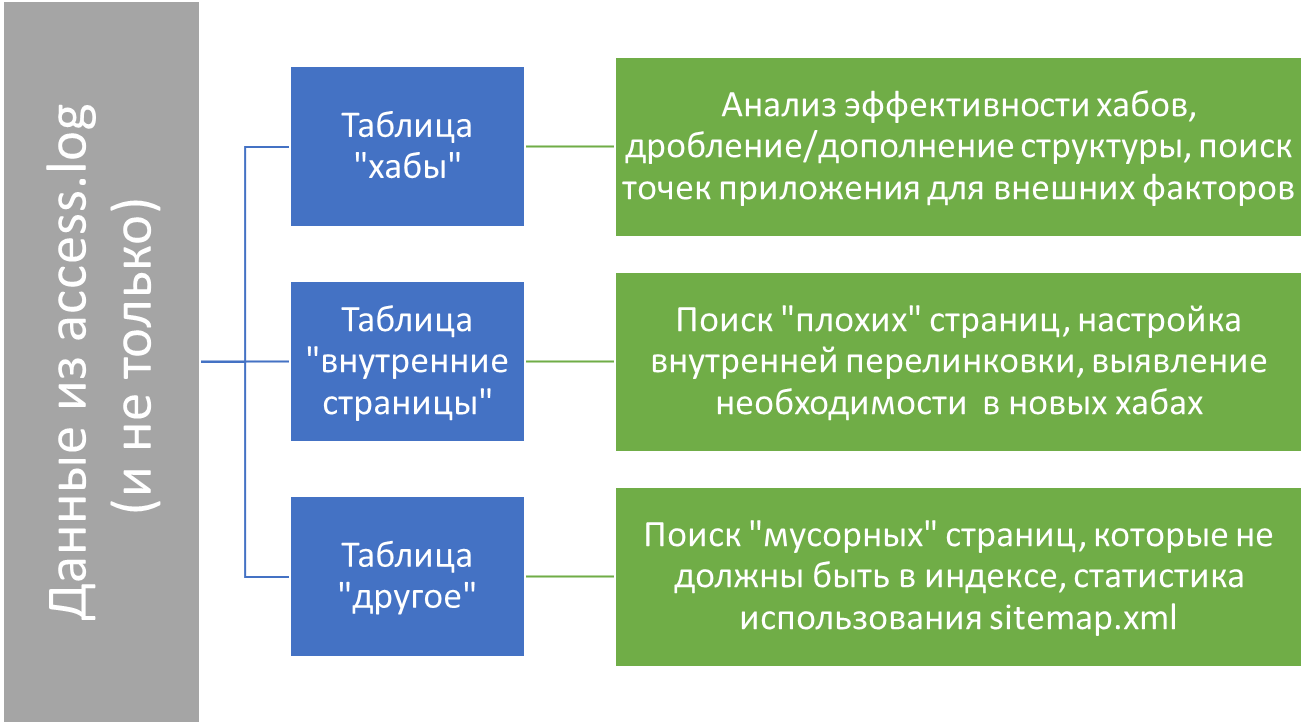

Я делаю 3 разные таблицы для данных, где собраны соответственно сведения о хабах (на больших проектах их могут быть десятки тысяч, вместе с подстраницами – сотни тысяч), рядовых страницах и наконец, url, которых нет в структуре сайта, но которые появляются в логах. См. схему о направлениях использования информации (кликабельно):

Делая выгрузку из каждой таблицы по необходимым параметрам можно получить ответы на огромное количество вопросов. Например:

- Какие хабы не посещались роботом уже месяц?

- Какие страницы активно посещаются Google, но плохо – Яндексом и наоборот?

- Какие страницы раньше приносили трафик, а сейчас перестали?

- На каких хабах максимальная активность ботов? Куда можно добавить ссылок?

Все параметры запросов (время, количество посещений, маска url…) можно гибко настраивать.

Понимаете, зачем это надо?

Наличие системы постраничной аналитики, даже в самом зачаточном виде, помогает принимать обоснованные решения по SEO. Огромное количество шагов можно делать с полной уверенностью, опираясь на факты, актуальные для конкретного проекта. Забудьте про смутные намеки техподдержки поисковика или советы в духе “мамой клянусь” от коллег!

Неплохо, правда? Лично мне нравится.

В заключение

После выхода первой статьи получил несколько предложений настроить “сеть для ботов”. Пожалуйста, имейте в виду – сам я только консультирую. Для реализации системы вам потребуется веб-программист. Кроме того, прежде чем что-то внедрять, мне нужно познакомиться с сайтом (вдруг в этом случае такой подход вообще неактуален?) и с вами лично (потому что создание постраничной аналитики предполагает длительное сотрудничество). Так что первый этап работы независимо от проекта – это мой стандартный аудит сайта.

p.s. Хоть в верху этой статьи и стоит пафосная приборная панель Мерседеса, описанный подход скорее напоминает трактор. Это рабочая универсальная техника, к которой можно прицеплять разные инструменты. Хочешь – ставь сеть для ботов. Хочешь – цапку для выдергивания url, которым нечего делать в индексе. А можно и лейку приделать, чтобы полить внутренним ссылочным важные страницы.

Как тут не вспомнить бессмертное “Видите, Балаганов, что можно сделать из простой швейной машины Зингера? Небольшое приспособление — и получилась прелестная колхозная сноповязалка.”

Успехов!

Даже никогда не слышал о подобном. Спасибо за пост

Казалось бы, есть site map -там есть все страницы, которые мы хотим, чтобы попали в индекс. Зачем дополнительно устраивать такую перелинковку ссылок на сайте? Для скорости?

Александр, наличие в sitemap отнюдь не гарантия попадания в выдачу. Это только дополнительная точка входа роботов на сайт. Для больших сайтов (с парой миллионов страниц) просто так полноты индекса не достичь. См. http://alexeytrudov.com/web-marketing/seo/seo-dlya-bolshih-saytov-davim-konkurentov-massoy.html, там есть показательный пример.

Алексей, а что думаете насчет того, что все хабы включая пагинацию и рубрики были закрыты от индексирования тегом noindex, follow.

Могли ли это сказаться негативно для Яндекса?

Зависит от задач. Обычно так не делают, потому что хаб часто сам по себе связан с поисковым спросом. Подобного опыта нет, но думаю да, могло эффект хаба.

Вот сейчас открыл хабы, подожду результат. Реально надо каждый сайт проверять, случайно галочка стояла в одном из плагинов ВП.

Если это WP то, вероятно, сайт не очень большой. Там хабы не так чтобы очень нужны, они требуются когда страниц десятки тысяч и больше. А вот наделать пагинацией и метками некачественных страниц можно запросто. Если еще не видели – стоит ознакомиться: http://alexeytrudov.com/google-fred/

На том сайте 3 тыс страниц, что вроде не мало.

оставлю только к индексации пагинацию и категории. в категориях нет текста, только ссылки.

Добрый день, у вас тут с изображением проблемки https://prnt.sc/1nxeydi

Действительно. Спасибо!