На прошлой неделе я запустил сервис анализа сайта SEO-прорыв. Все это время работал над его улучшением, а также старался оперативно реагировать на возникающие проблемы.

В этом посте – список наиболее важных изменений и пара полезных советов для пользователей.

Изменения по сравнению с версией 0.1

Учет морфологии в анализе страниц

Крайне важная доработка. Напомню, что в 4 отчете сервис ищет слова, которые есть в запросах, по которым люди уже попадают на страницу, но которых нет в тексте страницы. Запросы с такими словами могут свидетельствовать о:

- неполном раскрытии темы на странице, недостаточном количестве и качестве контента

- пользовательских интересах, которые появились позже написания статьи

- недостаточной оптимизации под наиболее характерные для тематики ключевые слова, несоответствии реальному поисковому спросу.

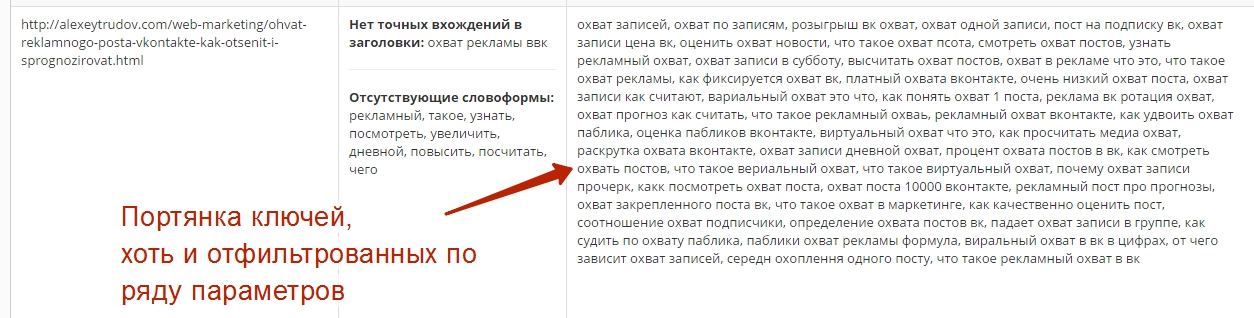

Раньше SEO-прорыв сравнивал набор слов в запросах и набор слов в тексте напрямую, без глубокой обработки. Теперь сравниваются леммы (начальные формы слов). Поэтому, если на странице присутствует слово “кошке”, сервис не будет сигнализировать о том, что в запросах часто используется словоформа “кошку”. Точность вхождения вплоть до словоформы обычно не слишком влияет на ранжирование. Наличия леммы, как правило, достаточно. В любом случае, следуя принципу Парето, нужно обращать внимание в первую очередь на слова из запросов, которые имеют уникальные для страницы леммы.

На практике это означает, что в 4 отчете стало гораздо меньше мусорных слов и освободилось место для полезных.

Улучшение отображения в 4 отчете

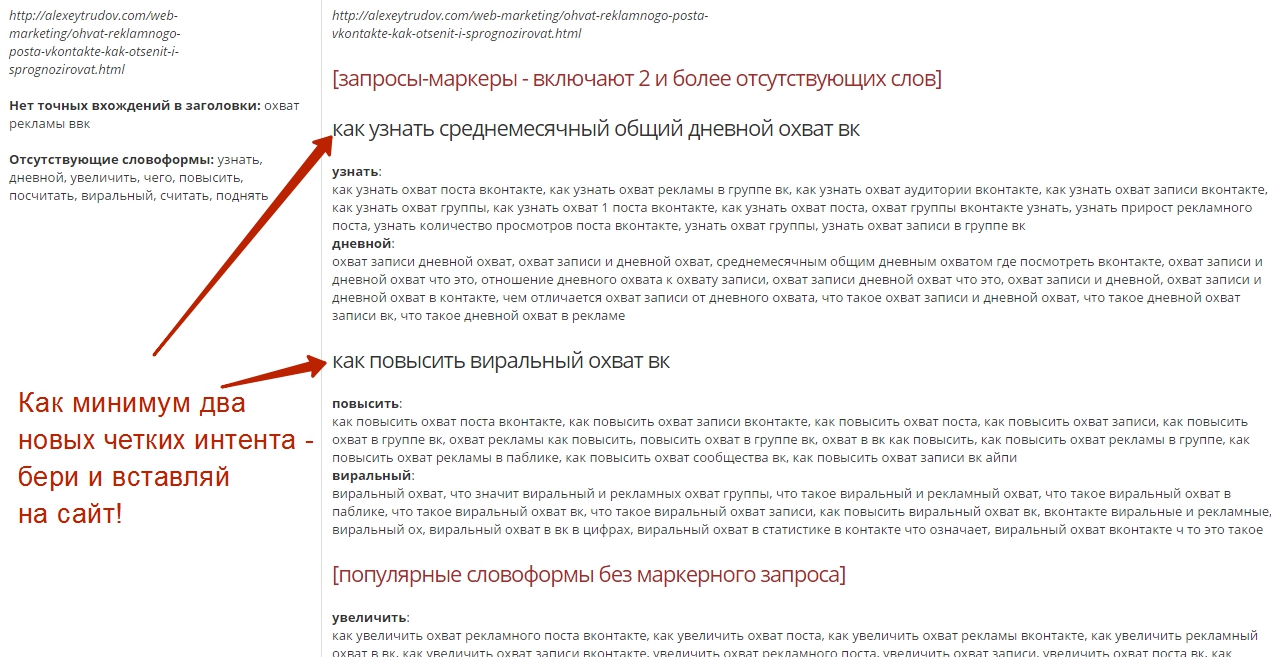

Благодаря использованию морфологического анализа, удалось сделать 4 отчет более структурированным и понятным. Теперь для страниц, содержащих достаточно много добавочной семантики, выделяются маркерные запросы. С точки зрения кондовой технической оптимизации, такие запросы содержат сразу 2-3 важных словоформы, их использование в тексте позволит улучшить релевантность сразу по большому спектру ключей.

Но более важно, что эти запросы зачастую (хотя и не всегда: принимайте в расчет и другие запросы) точно отображают важный интент (пользовательский интерес), который не учтен на странице. Если вы добавите подходящий под запрос контент, то не только улучшите соответствие сайта поисковому спросу. Ресурс станет реально полезнее, так как даст ответ на вопрос, часто интересующий целевую аудиторию.

Сравните два скриншота анализа моего блога, который используется в качестве демо (оба кликабельны).

Старый:

Новый:

Замечу также, что владельцам сайтов разных типов стоит ориентироваться на разные части этого отчета. Для контентных проектов маркерные запросы могут стать настоящей находкой – это готовые темы для дополнительных блоков в статье либо для новых публикаций. По этим темам поисковики уже считают сайт достаточно релевантным и он уже получает некоторый трафик – даже без всякой оптимизации. Для проектов, где контент в значительной мере генерируется (каталоги, агрегаторы, маркетплейсы, отчасти – интернет-магазины), особое внимание стоит обратить на списки отсутствующих словоформ. Их можно использовать для составления действенных шаблонов мета-тегов и вообще блоков контента.

Всеядный парсер

Раньше парсер, собирающий материал для анализа, давал сбои – примерно на 5% страниц. В основном это происходило из-за “кривой” верстки. Сейчас парсер значительно улучшен, он умеет справляться даже с кодом, который вызывает нервный тик у опытного верстальщика.

Заградительные отчеты об ошибках

В случае, если парсер по какой-то причине не смог получить данные, на этапе перед оплатой аудита выводится предупреждение:

Собственно, подобное предупреждение выводится уже давно. Однако теперь я также убрал возможность оплатить аудит, в котором парсер столкнулся с проблемами. Кнопка оплаты больше не выводится, чтобы пользователь не мог нажать ее по привычке.

(Важно: если у вас стоит защита от парсинга, которая подсовывает роботам какую-нибудь “левую” страницу, то сервис может и не посчитать это ошибкой, а проанализировать контент такой страницы. Поэтому отключайте защиту, прежде чем отправлять сайт на анализ!).

Напоминаю, что инструмент по-прежнему находится в статусе бета-версии. С одной стороны, это означает, что довольно высока вероятность неполадок (пишите мне, если столкнулись с ними!). С другой – пользоваться сервисом можно со скидкой 50%.

Замечания и советы

1. Еще раз: в чем “фишка” сервиса?

Большая часть пользователей сразу хорошо уловила суть инструмента, видимо, мне удалось четко донести свою концепцию. Но продолжают и поступать вопросы в духе “а почему ваш сервис не проверяет микроразметку/ссылочную массу/влияние фаз луны”.

Ответ: улучшать и развивать сайт в плане SEO можно бесконечно. Сервис не пытается дать вам программу на 3 года вперед и не заменяет живого специалиста (иначе проверки стоили бы гораздо дороже). Он ищет несложные пути увеличить целевой трафик в короткие сроки, с минимальными затратами ресурсов. Все просто и банально:

- вот страницы, которые потеряли трафик – проверили на ошибки, вернули в индекс – PROFIT

- вот запросы, по которым больше не приходят – разобрались что не так с посадочными страницами, улучшили – PROFIT

- вот страницы с хорошей конверсией, а вот советы как их оптимизировать и какие дополнительные ключи использовать – несколько часов работы контент-менеджера – PROFIT!

- (и так далее – без бубнов, больших расходов и “серых” методов)

С другой стороны, уже сейчас инструмент дает ряд нетривиальных возможностей для специалистов, например, поиск дублей title среди страниц, недоступных обычному краулеру, поиск малоинформативных шаблонных title и т.д.

2.Почему такая скудная справка?

Увы, написать всеобъемлющую справку пока не получается. Пока я планирую сосредоточиться на улучшении основного функционала и добавлении нового. Писать под каждую новую версию собственную справку просто некогда. Вот когда выйдет версия 1.0 – тогда все будет разжевано до мелочей. А пока справляйтесь. Уверен, что для читателей моего блога это не составит труда.

3. Почему в отчете “Дубли тайтлов” встречаются несуществующие страницы?

Потому что это один из способов на раннем этапе отловить технические проблемы. У несуществующих страниц обычно заголовки стандартные вроде “страница удалена”, разумеется, они попадают в отчет по дублям. Вам важно удостовериться, что удаление этих страниц было сделано осознанно. В противном случае – вы теряете трафик (ведь анализируются только страницы, приносившие посетителей из поисковых систем).

4. Когда нужно платить?

Заметил, что некоторые пользователи, зарегистрировавшись, сразу идут на страницу покупки проверок. Это необязательно! Оплачивать аудит можно уже после выполнения анализа, когда вам будет показан его краткий итог. Принимайте решение осознанно.

Удачи в работе с сервисом! Присоединяйтесь, если еще этого не сделали: https://bez-bubna.com/

Крутое название домена)))

Самому нравится)