Анализ и поисковая оптимизация сайта, содержащего больше пары десятков страниц, немыслимы без автоматизации. Для моих собственных интернет-проектов и сайтов клиентов по SEO-аудиту требуется инструмент, который:

- во-первых, помогает оперативно находить технические ошибки (дубли страниц, битые ссылки) и устранять недочеты оптимизации;

- во-вторых, дает общую картину в плане структуры сайта как она есть и как воспринимается поисковыми системами;

- в-третьих, позволяет экспортировать результаты анализа в удобном виде для обсуждения их с клиентом или разработчиком.

Сейчас для этих задач использую платную программу ComparseR (см. официальный сайт продукта). Она обладает более широким функционалом, чем Netpeak Spider, которым я успел обработать не одну сотню сайтов. Netpeak Spider – тоже хороший софт, но его функционал куда уже, так что он заменял ручную работу далеко не везде.

Расскажу о ComparseR более подробно.

Первые впечатления

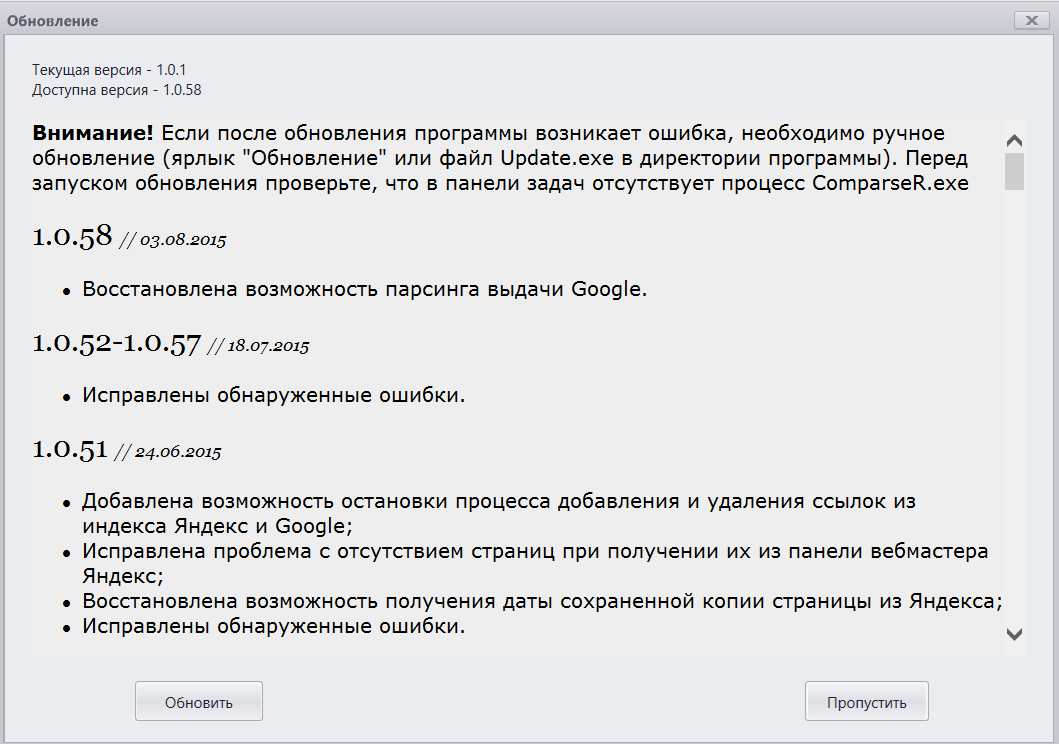

При установке сразу радует, что продукт живет и развивается, регулярно выходят обновления:

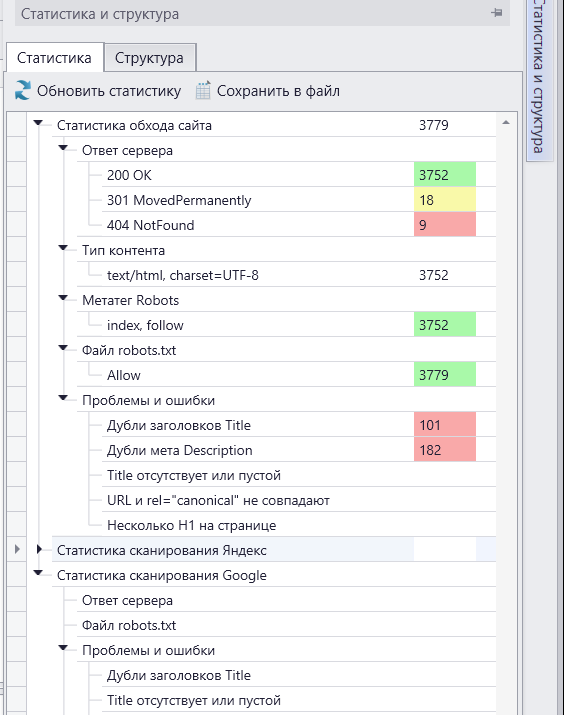

Устанавливаем обновления (у меня получилось довольно шустро), переходим к изучению интерфейса. С первого взгляда – одновременно пугает и радует обилие кнопок, функций, настроек. Чтобы полноценно использовать программу, требуется как следует в ней разобраться. С другой стороны, в этом помогает очень удачное интерфейсное решение – выезжающая панель “Статистика и структура”, которая концентрирует внимание пользователя на самых важных параметрах. При нажатии на элемент списка показываются соответствующие проблеме ссылки, не приходиться возиться с сортировками огромного списка url:

Функционал ComparseR-а

Исходных функций три:

- краулер – получение списка страниц сайта и их значимых характеристик

- получение сведений об индексации в Google

- получение сведений об индексации в Яндексе

Краулер позволяет не только спарсить мета-теги, ответ сервера и число заголовков h1, но и:

- высчитывает длину url, title, meta description

- показывает заголовки h2-h3 (можно бегло оценить уровень оптимизации и “спамности” страницы)

- высчитывает длину текста на странице (легко находить бедные информацией тексты)

Едва ли не самое важное – опция сравнительного анализа кластеров url, полученных соответственно из выдачи и с сайта. Имею в виду инструменты “есть на сайте, нет в индексе Яндекса” и наоборот. Эти данные очень ценны для достижения полной индексации и борьбы с техническими ошибками на сайте.

После того, как поработаешь с программой пару дней, обилие функций перестает пугать и продолжает радовать. Предусмотрено много важных мелочей, например:

- Задание user-agent для краулера. Скажем, вы отдаете роботам поисковиков иной контент, чем остальным (ай-ай-ай, клоакинг! ладно, с кем не бывает) и вам нужно посмотреть структуру сайта глазами робота. Или у вас на сайте защита от ddos, а парсить хочется много и интенсивно: можно установить свои настройки для определенного user-agent.

- Несколько сервисов антикапчи.

- Парсинга сайта, закрытого через .htpasswd. Отличная вещь: ведь сайт в разработке оптимально закрывать от поисковых роботов именно так, наглухо.

Немало и доп. функций, например, построение карты сайта (sitemap.xml) или запросы на удаление страниц из поиска.

Общая оценка

В начале статьи я говорил о трех своих актуальных задачах: оптимизации на уровне отдельных страниц, возможности взглянуть на сайт в целом, экспорт результатов для того, чтобы с ними могли работать третьи лица.

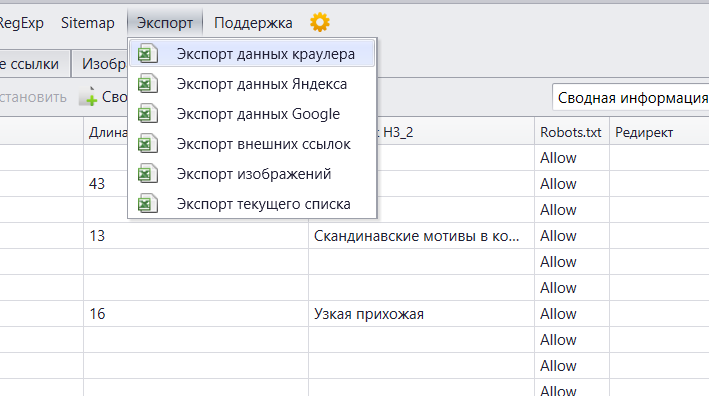

О том, что с первыми двумя пунтами все хорошо, должно быть понятно из написанного выше. С отчетами тоже все отлично, поддерживается множество вариантов экспорта:

Кроме того, всегда можно перетащить нужные колонки близко друг к другу, выделить их мышкой и просто скопировать в excel. Я так делаю, например, чтобы создать отчет по битым ссылкам, когда требуется только два поля: url и его источник. Пара кликов – и отчет готов, можно отправлять его разработчику.

То есть: со своей работой программа справляется на “отлично” по всем пунктам.

Есть ли минусы?

Я не обнаружил явных недостатков. При том что уже давно использую в реальной практике – сначала демку, а с недавних пор и полную версию программы. Конечно, всегда можно придраться к тому, что нет каких-нибудь “хотелок” (а что это прога кофе в постель не носит?), но с реально важными проблемами не сталкивался.

Попробовал найти минусы исключительно для полноты отзыва – не нашел. Нашел только еще один плюс: что поддерживается множество способов сортировки и группировки результатов для облегчения анализа. Настройки отображения очень гибки.

Вероятно, начинающим SEO-специалистам было бы полезно иметь больше готовых фильтров типа “проблемы и ошибки”. Теоретически туда можно запихнуть слишком короткие/длинные title, малый объем текста, дату сохраненной копии больше 60 дней (30 это вполне нормально для больших проектов, которые грамотно управляют crawl budget) и так далее. Но мне кажется, что загромождать интерфейс смысла нет, все можно настроить и найти и так. А то вдруг оптимизация сайта с помощью ComparseR станет настолько простой, что у меня заказы на аудиты пропадут – все сами будут делать.

Коротко о главном

ComparseR – действительно стоящий инструмент для оценки внутренней оптимизации сайта. Хорошая скорость и стабильность работы. Богатый функционал – отдельные элементы есть в других сервисах, но здесь очень много можно сделать в одном окне, сэкономив кучу времени, не выполняя лишний раз парсинг. Особенно это актуально для средних и крупных проектов, включающих более 3 – 5 тысяч страниц. Много полезных дополнений, продуманный интерфейс и логика работы. В общем, искренне рекомендую всем, кто хочет тщательно работать над внутренней оптимизацией сайта.

Напоминаю сайт программы: http://parser.alaev.info/

Успехов!

Спасибо, Алексей!

Важно было услышать со стороны о простоте и интуитивности интерфейса. А то когда делаешь все с самого начала, то сколько бы не было кнопочек и свистелок, ты всегда знаешь, где и что лежит. От КейКоллектора при каждом запуске голова кругом даже спустя несколько лет использования 🙂

>>От КейКоллектора при каждом запуске голова кругом даже спустя несколько лет использования

Точно 🙂 Тоже в общем все удобно, но никогда не забываешь, что это такой вот мощный монстр

Он флудит!!! Полный обвал айпишника с которого делаешь проверку!!! Этот софт заваливает сервер одновременными запросами на порт 80 с флагами FIN,SYN,RST,ACK SYN , при этом либо сам сайт либо провайдер применяет меры защиты и посылает айпишник в бан!!!

Так попробуй парить в один поток, можно еще задержку поставить между запросамм.

Крутая программа, у нее самый удобный интерфейс, лягушки и другие курят в сторонке.