В последние пару недель в очередной раз произошла серьезная тряска выдачи Google. SEO-форумы, что в Рунете, что в англоязычном сегменте, наполнились сообщениями вебмастеров о резко снизившемся трафике.

Шторм зафиксировали и анализаторы выдачи:

Попробуем разобраться в ситуации и понять, как жить дальше.

Тряска в сентябре – новые проделки Google Fred?

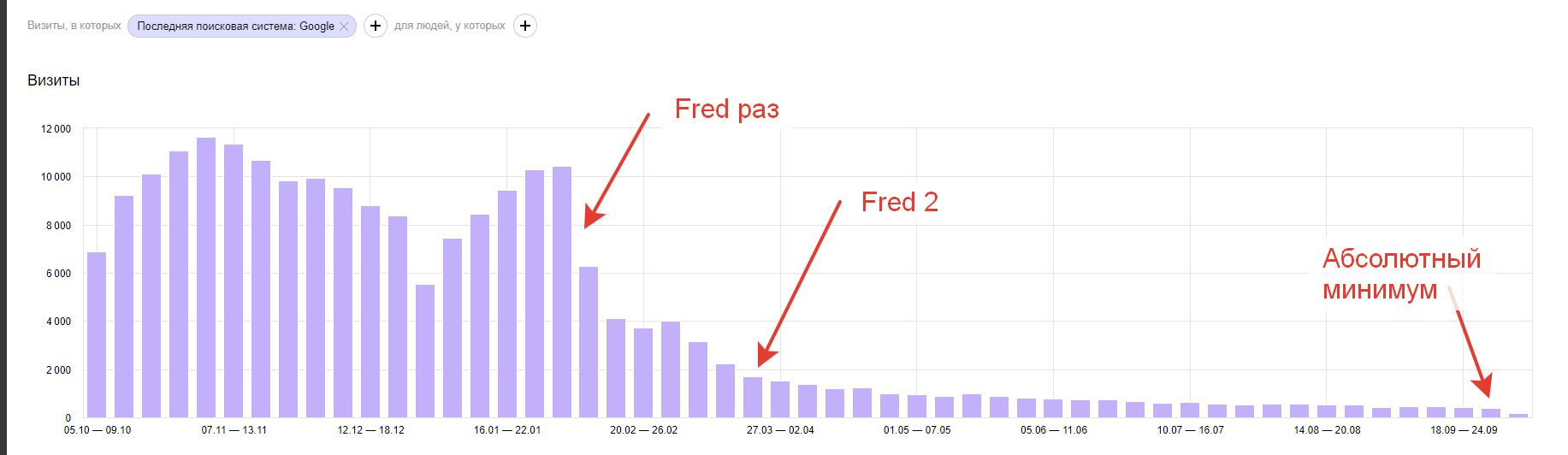

В обсуждениях часто всплывает мнение, что свежие изменения – это продолжение линии Google Fred, то есть апдейтов в марте и феврале этого года. Вообще-то проводить параллели преждевременно. С другой стороны, понять, не поменялись ли подходы Fred-а к ранжированию – весьма полезно.

Главные выводы моего весеннего исследования этого апдейта Google изложены в презентации для SEMPRO (см. также статью с некоторыми дополнительными замечаниями и обсуждением). Обязательно посмотрите слайды – они понадобятся для понимания.

John Mueller, одна из главных говорящих голов в Google, заявил 11 сентября:

From our point of view, our quality algorithms do look at the website overall, so they do look at everything that’s indexed. And if we see that the bulk of the indexed content is actually lower quality content then we might say ‘well, maybe this site overall is kind of lower quality.

Вольный перевод:

Наши алгоритмы действительно изучают весь сайт, все проиндексированные страницы. Если мы видим много проиндексированного контента плохого качества, мы считаем, что весь сайт тоже так себе.

В общем-то здесь все очевидно, но есть один нюанс. Что такое “страница низкого качества”? Во время выступления я немного потроллил аудиторию. На 25-м слайде спросил зал – “правильно?” и получил в ответ кивки и неуверенное “дааа”. А потом показал следующий слайд (и правильный ответ на 32-м).

Возвращаемся из марта в октябрь. Можно ли считать что выводы по-прежнему актуальны? Это не так сложно проверить. Достаточно поднять старую выборку (благо, она довольно велика – и не лень же мне тогда было ее составлять!..). Ситуация на тех проектах, что мало изменились, покажет нам, поменялся ли Fred. Но сначала хочу рассказать об одном показательном кейсе.

Кейс: несоответствие трафика, количества точек входа и страниц в поиске

Еще до того, как я взялся за изучение новых тенденций, мне попалась интересная ситуация на сайте клиента.

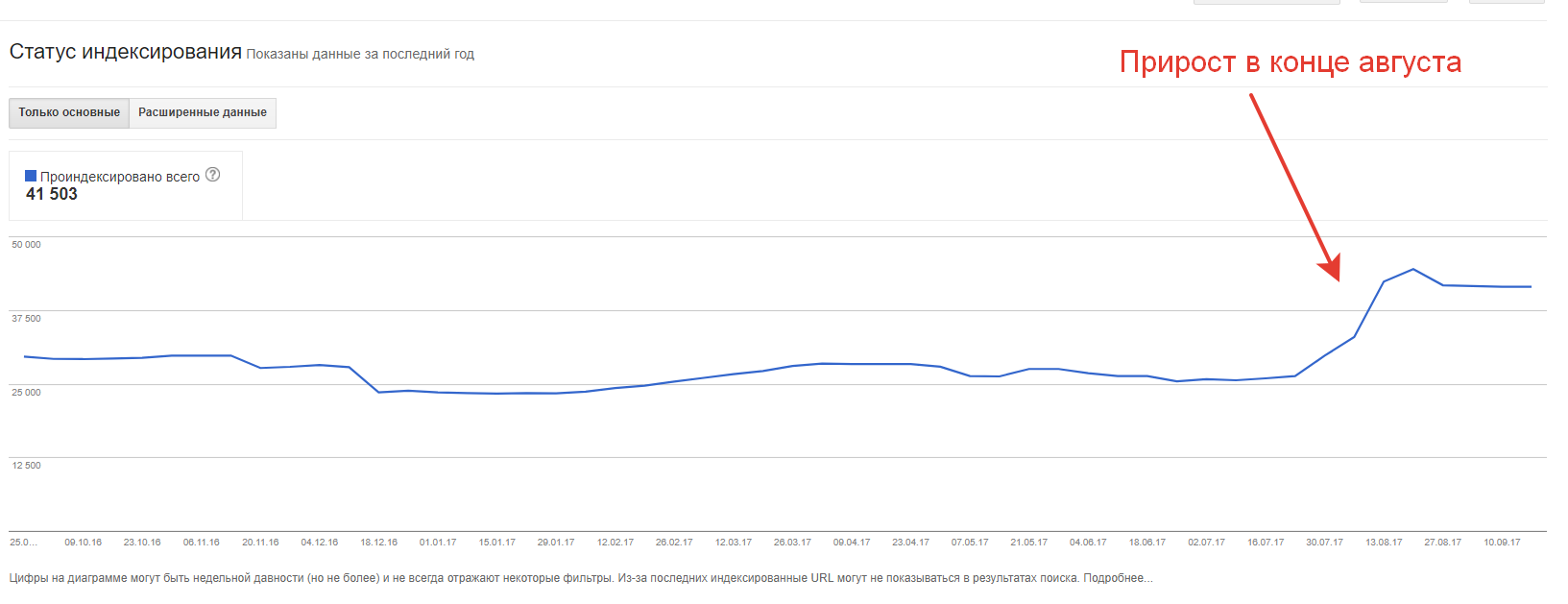

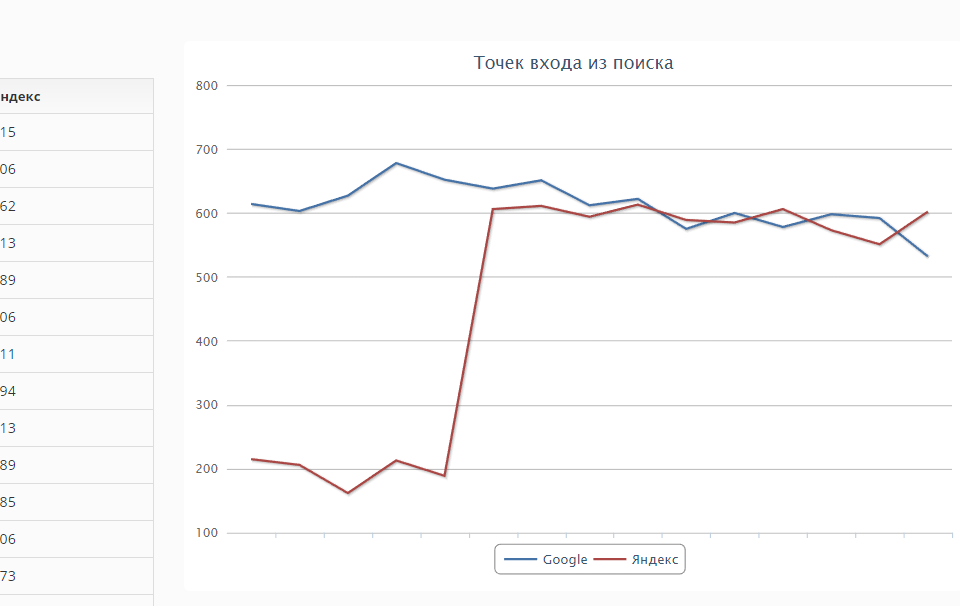

Вот скриншот из Search Console:

А вот из Метрики:

А вот наконец из моего сервиса https://bez-bubna.com/

Несоответствие!

Число страниц в индексе сильно выросло. А число страниц, приносящих трафик и общий объем визитов с Google – явно снизились. Чаще эти показатели сильно коррелируют. Больше страниц – больше точек входа – больше визитов (просто, понятно, логично). То есть этот пример – живой аргумент в пользу версии, которую я изложил выше.

Почему остановился на этом кейсе так подробно? Потому что по этому сайту я имею максимум возможной информации (в отличие от большей части из 116 проектов в изначальной выборке) и могу исключить другие факторы. Такой вот свежий наглядный пример.

Ну а теперь к главному.

Как сейчас ранжируются сайты, затронутые Fred-ом в марте и феврале?

Для тех проектов, что не смогли улучшить контент или не стали менять настройки индексации, практически ничего не поменялось. Просевшие не восстановили трафик до сих пор. Удивительные примеры отличного ранжирования не самых качественных проектов также остались. Исключения есть, но довольно редки. Вот интересный случай – интернет-магазин большим количеством “пустых” страниц (30 слайд в презентации):

Другой пример – сайт-каталог с огромным количеством страниц, с прямо-таки классической картиной падения трафика из-за Фреда. И, кстати, хорошей посещаемостью из Mail.ru. Проект немного похож на кейс номер 5 из этой статьи, хотя сделан более качественно.

В сентябре Google, несмотря на сезонное повышение спроса окончательно положил проект на обе лопатки.

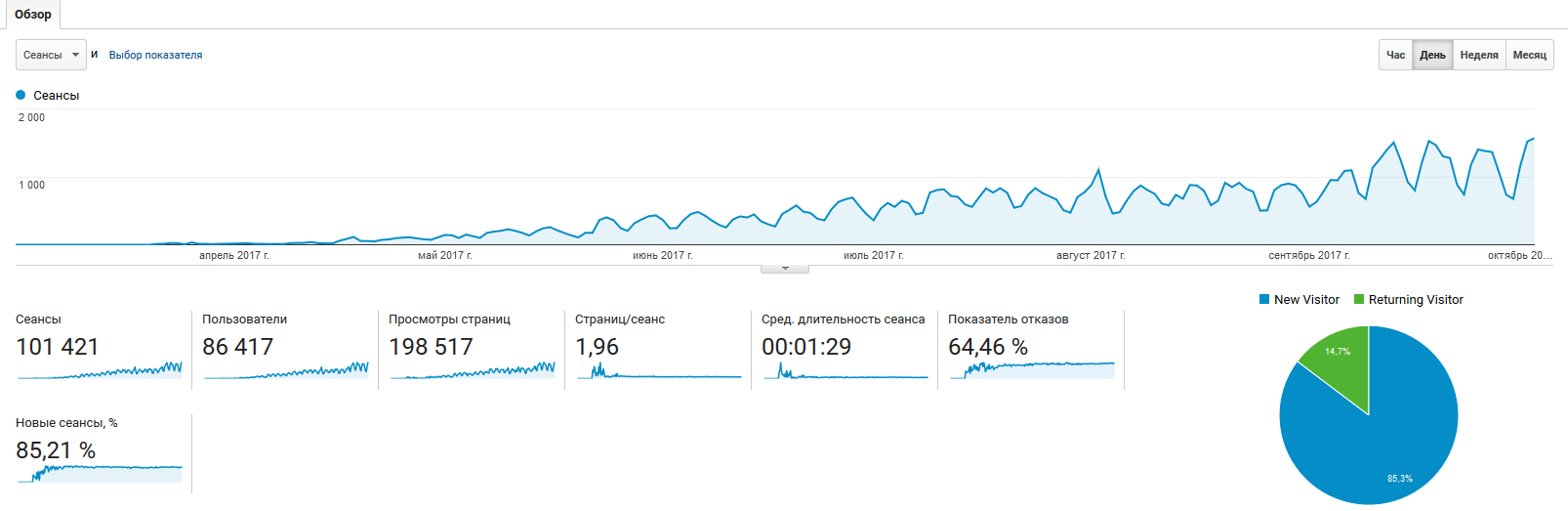

Как поживает экспериментальный сайт?

Посмотрим на еще один элемент исследования – сайт, сделанный специально так, чтобы считаться некачественным по формальным критериям, которые так любят западные SEO-блоги, но качественным, если учесть поисковый спрос (подробности в конце презентации).

Проект поживает хорошо:

Во вторник как раз был рекорд по посещаемости – 1569 визитов.

Промежуточный вывод

По-прежнему крайне важно соотношение “хорошие”/”плохие” страницы; по-прежнему “хорошими” считаются те, что могут ответить хоть на какой-то запрос пользователя. Если на сайте будет достаточно много таких страниц, они помогут всему проекту успешно ранжироваться, невзирая на балласт в виде проблемных документов. На ряде изучаемых сайтов обнаружена дополнительная отрицательная динамика в сентябре. Вероятно, принцип “в сайте все страницы должны быть прекрасны” стал еще более значимым, чем раньше.

Более того, принципу есть официальное подтверждение от Джона Мюллера (хотя и без нюансов, конечно).

Кстати: здесь наблюдается параллель с Яндексом, который попросту удаляет из индекса документы, которые не имеют шансов показаться на выдаче (статус “недостаточно качественная”). Если у вас много таких url на русскоязычном проекте – стоит задуматься об отношении к ним Google. Возможно, хорошим решением будет доработка контента или запрет индексации – конечно, только в случае, если они не дают существенного трафика.

В то же время, Google постоянно совершенствует алгоритмы определения “недостойных” страниц; к делу подключаются новые факторы. Неудивительно, что сайт с пустыми страницами потерял завоеванную посещаемость: нужно не только обозначить ответ на вопрос, но и дать его.

Что дальше

Можно ли на этом остановиться и махнуть рукой на дальнейший анализ, дескать, ничего нового не произошло? Нет, нельзя.

Выводы выше сделаны на старой выборке, с которой уже поработал предшественник сентябрьского обновления. Для полноты картины необходимо проверить и ранее не задетые сайты. Особенно важно найти среди них такие, где соотношение “хорошие”/”плохие” будет высоким. Изучив их, можно будет понять, чем принципиально последний апдейт отличается от предыдущих (и отличается ли вообще).

Исследование уже готово, удалось прийти к нескольким новым выводам. Сначала хотел описать их здесь же, но статья получалась воистину огромная и сложная для восприятия. Скоро опубликую отдельный пост про суть сентябрьских обновлений Google. Оставайтесь на связи!

UPD: написал подробную инструкцию по борьбе с Fred-ом.

Зажимают нашего брата((

Не то слово, оборзели совсем. У меня Фред злорадствует вовсю. В три раза посещаемость завалил.

Это ответ тем, кто начинает думать, что SEO умерло. Ага, делайте массу неграмотно слепленных страниц и окажетесь на обочине.

Значит не совпадение. Обновил структуру сайта, добавил много новых категорий и ссылки на них в меню. Трафик резко пошёл вниз. Запретил индексацию страниц категорий – траф вернулся. Я думаю не совпадение.

Вполне возможно.

Про какой поисковик речь?

Вон оно что, у меня есть сайт на котором как раз в феврале разместил каталог с генережкой, и по сумме таких страниц больше основным полезных. И трафик как раз в то время упал. Но я правда грешил на другие факторы. Сейчас попробую закрыть каталог от индексации и проверить изменение посещаемости через время. Если что Алексей я у вас есть в скайпе, если интересны будут результаты спросите там я расскажу.

Да, любопытно, спасибо.

Лучше закрывать не весь каталог сразу, а сначала выборочно документы где нет трафика (через мета-тег robots). Я всегда против того, чтобы махать шашкой, лучше постепенно 🙂

Как раз пару часов назад решился закрыть страницы-разделы товаров, которые в Яндексе были по ключам на 1-х местах, а сейчас полгода как на 45-х ))) вовремя прочитал – пойду закрывать индексацию Яндексу. Гугл по прежнему по тем же запросам их показывает в ТОП-3

Если были на первых местах, то лучше не рубить с плеча, а постараться вернуть позиции.

Есть англоязычные доры с десятками тысяч страниц. Тексты не генерёнка, написаны носителями языка. На стыке февраля и марта трафик пошел вниз.

Надеялся, что через некоторое время само отпустит. Не фига. Щас задумался, что делать. “Улучшать” содержание, естественно, нет возможности. Удалять часть страниц? Но как определить хорошие и плохие? Имеется статистика по переходам из поиска до пессимизации. Если я оставлю на сайте только те страницы, на которые ранее были переходы из Гугла — это поможет?

Похоже, надо писать отдельный материал на эту тему 🙂

В двух словах не рассказать.

Ставьте в план, будем ждать. Полагаю, что вопросы как быть, когда улучшить содержание принципиально невозможно и как отделить страниц-агнцев от козлищ без детального анализа каждой (затруднительного для крупных многостраничников) интересна не мне одному.

Да, аналогичных вопросов получил уже немало.

Как бы закрыть “неправильные” … Гугл набивает в общую копилку слова со ВСЕГО сайта — вспоминайте в Консоле “Ключевые слова” — закрывая часть страниц — поменяется эта копилка

Спасибо за статью!

1. Есть сайт, где >1500 страниц новостей. Новости уже не актуальны, трафика не дают.

Статей при этом штук 400.

После прочтения статьи удалил новости, интересен результат.

2. На другом сайте есть >1000 страниц пагинации. Это страницы категорий и тегов на вордпресс.

Подскажите, что с ними лучше сделать?

1. По новостям я бы не советовал так сразу делать. Бывают возможности их оживить. См. статью про работу с потерявшими трафик страницами, там в середине есть пример с новостью (взят из практики).

2. Для пагинации у Google есть штатное решение – теги next prev. Если не ошибаюсь, плагин SEO by Yoast умеет их ставить. Под Яндекс в общем случае я делаю noindex, follow в мета (хотя яндексоиды и говорят, что надо ставить каноникал).

как это, под яндекс noindex, а под гугл next, prev, вы занимаетесь клоакингом?

Это не клоакинг, а официально поддерживаемые возможности. В в мета роботс можно прописать только для Яндекса правило.

Удаляю по-тихоньку хлам. Много валяется мусора. Фреду, потом, скажу чтобы проверил.

Это да, но когда вы пропишете noindex для Яндекса, то гугл тоже увидит noindex и уже не будет смотреть на next, prev, разве не так?

протупил, оказывается meta можно только для яндекса указать)

Можно 🙂

но если мы проставим теги, разве мы этим уменьшим количество бесполезных страниц? по-моему в этом плане выигрыша не будет

Гугл поймет, что они технические. Попробовать стоит – как начальное, “мягкое” средство.

У меня на видео сайте картина по трафику (http://prntscr.com/h7znax) в точности как у сайта с 30-го слайда.

Но, у меня не было и нет пустых страниц. Есть страницы (порядка 10%-20%) с совсем небольшим либо не совсем уникальным текстовым содержанием. Это как правило очень старые страницы. Под новые страницы пишется только уникальное в районе 500-1000 знаков ну и часть старых я со временем тоже переписал.

В остальном, в период с февраля по сегодня, на сайте много менялось по внутренней составляющей:

– переход на https с правильным постраничным редиректом

– уменьшение вложенности для категорий

– смена ЧПУ названий как самих категорий так и контентных страниц, с 301-м редиректом со старых названий

– пересмотрены вопросы внутренней перелинковки, лишнее оформлено через джаваскрипт в

– отдельно игрался с пагинацией

– кардинально пересмотрена семантика в title страниц, внутренних ссылок и alt с ссылок-картинок

– пересмотрена структура контентных страниц, в связи с чем ощутимо выросли поведенческие по сайту

Это все изменения в сумме, пока, никак глобально не повлияло на изменении в трафике, разве что улучшились поведенческие по сайту и с гугла они даже выше чем с Яндекса, вот за вчера http://prntscr.com/h7zxhz.

Т.е. для роста, либо не хватает внешнего ссылочного, которое искусственно никак не наращивается, а естественное… ну тоже не особо возникает, либо сказывается отсутствие мобильной версии сайта (её пока нет вообще и адаптива тоже), либо мешает та небольшая часть не совсем качественного контента, хотя эти страницы в индексе?

На 30 слайде же нет скриншотов с трафиком.

Вполне возможно, хотя других вероятных причин масса. Не следует во всем обвинять один алгоритм.

Да, и для Google индекс не показатель.

Ну и что кто нибудь провел эксперимент с сайтами-каталогами, закрытие карточек в noindex, дало прирост трафика? Написали многие, что отпишутся о результатах, а воз и ныне там

Алексей, а если удалить страницы не приносящие трафик, скажется ли это положительно в виде роста позиций по другим страницам или это лишняя потеря времени?

Максим, однозначного ответа нет, хотя бы потому, что не дающие трафик страницы – далеко не всегда “плохие”. См. в руководстве.

Алексей, спасибо за статью. Подскажите, если у меня на поддомене к основному контентному сайту висит сайт с промокодами, там много пустых страниц и совсем нет уникального контента. Такой сайт на поддомене может отрицательно сказаться на ранжировании основного контентного проекта?

Ольга, хороший вопрос. Похожих кейсов было мало, сложно что-то сказать с уверенностью. Я бы не рисковал.

А что порекомендуете сделать, закрыть от индексации сайт с промокодами? Там около 4 тыс страниц

Ольга, нужно смотреть конкретный проект, но стандартная практика – мета-теги noindex