Внешнее продвижение в текущих условиях требует взвешенного и осторожного подхода (см. подробнее). Нельзя просто закупаться огромным количеством ссылок, надеясь что “какая-то да выстрелит”. Новая версия сервиса bez-bubna.com помогает частично упростить работу.

Общий принцип. Что анализируем?

Как и всегда, идеи, которые лежат в основе нового функционала, очень просты:

Структура сайта и внешнее ссылочное далеко не всегда хорошо соответствуют друг другу, если это исправить, то отдача от ссылок увеличится.

Что значит “соответствие структуры и ссылочной массы”? Не надо пугаться громоздкого выражения. Его конкретные проявления понять несложно. Например:

- Некоторые страницы имеют много естественных внешних ссылок, но на них нет оптимизированного под частотные запросы контента.

- Ряд url c большим PageRank после смены адресов стал отдавать 404 ошибку.

- Набрали популярность закрытые от индексации страницы.

Во всех этих ситуациях вес ссылок частично растрачивается впустую. Возможна и обратная ситуация – когда страница содержит актуальный, хорошо оптимизированный и качественный текст, но имеет малую ссылочную популярность. В этом случае мы получаем меньший эффект от внутренней оптимизации. Если точечно подтолкнуть документ ссылками – получится прирост трафика.

По старым временам такой подход кажется крохоборством. Сегодня аналитика соответствия структуры и внешних факторов – необходимость. По крайней мере, если смотреть в будущее. То есть работать с прицелом на минимизацию риска фильтров и экономить бюджет ссылки.

Кроме того, новый функционал помогает справляться и с другими задачами (об этом ниже).

Новые отчеты

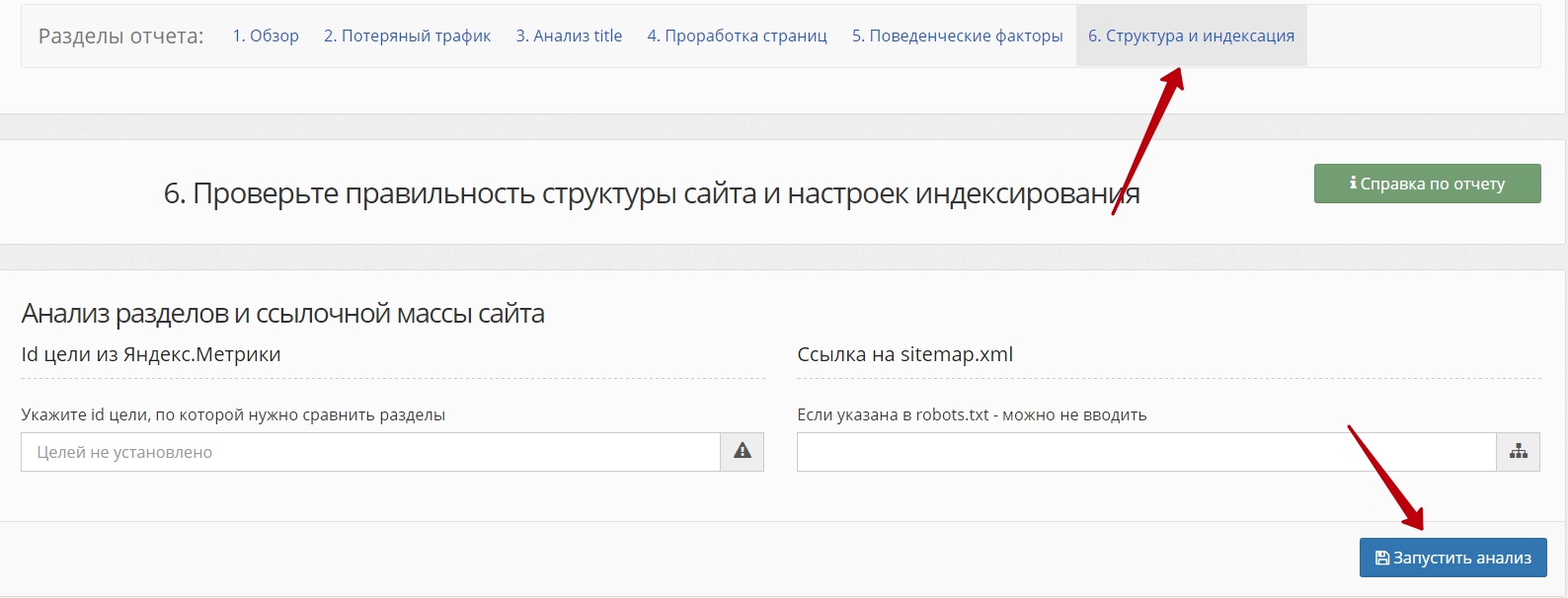

Всего добавлено 6 отчетов. Они генерируются совместно с анализом по разделам, для выполнения нужно перейти в готовом аудите во вкладку “Структура и индексация” и запустить процесс:

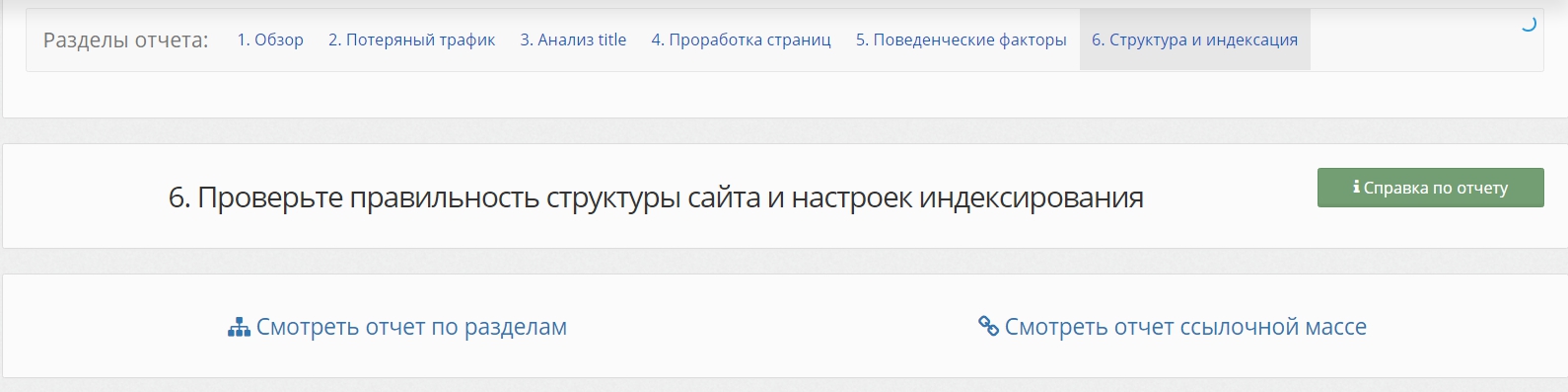

После выполнения вы увидите 2 ссылки:

Вот демо-версия того, что вы откроется по клику на “Смотреть отчет по ссылочной массе” (как обычно, на примере моего блога).

Поиск мусорных/удаленных по ошибке страниц

Первая таблица содержит страницы, которых нет в карте сайта, но на которые найдены внешние ссылки. Что это могут быть за страницы? Вариантов очень много:

- Удаленные url (надо ли их было удалять, если есть ссылки?)

- Url, не включенные в карту сайта (а может, не включены и другие? может, из-за этого страдает индексация?)

- Страницы технических дублей, самовольно генерируемые движком сайта.

Последний случай может оказаться крайне важным. Ссылочный прогон для “заталкивания” в индекс мусорных страниц – это один из способов здорово навредить конкуренту в выдаче. Подробнее об этом, например, в отличном докладе Дмитрия Шахова на SEOConference – “Как конкуренты могут обрушить ваше SEO” (см. слайд 10):

Для борьбы нужно понимать, где конкретно проблема, то есть отыскать “плохие” страницы с кодом 200. Отчет как раз и автоматизирует их нахождение.

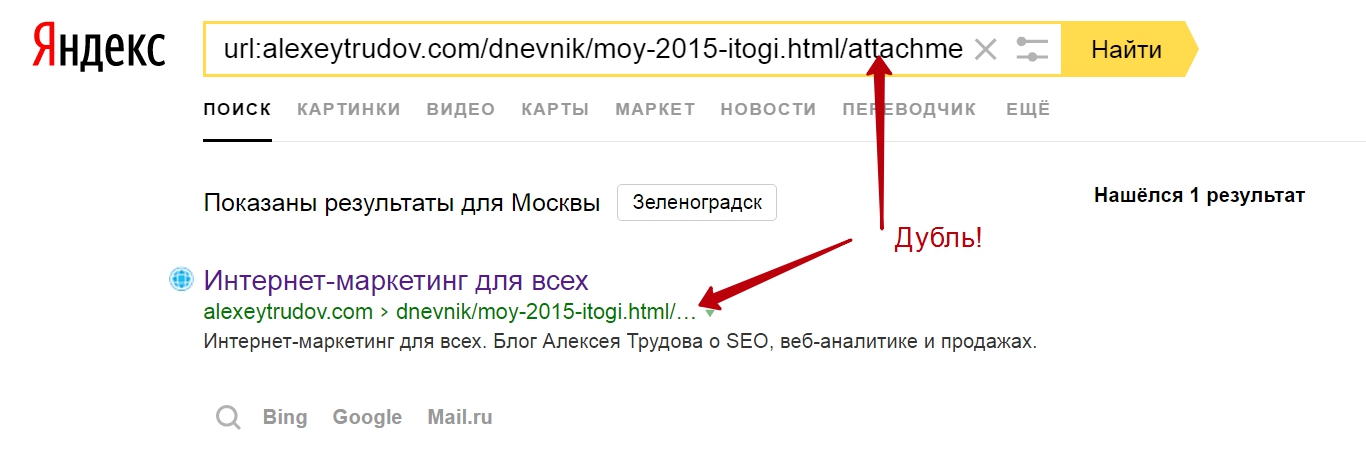

Например, для этого блога оказались найдены страницы типа

http://alexeytrudov.com/dnevnik/moy-2015-itogi.html/attachment/8cmyscm6qoq-1/

Они генерируются из некоторых изображений в постах. Кстати, программы для техаудита не находили эту страницу, так как внутренних ссылок на нее нет. Зато Яндекс нашел:

То есть даже маленький бложик с не самым кривым движком (WordPress) и то может создавать url с дублированным некачественным контентом. Что уж говорить про магазины с сотнями товарных категорий, тысячами товаров и разнообразным функционалом?

То есть даже маленький бложик с не самым кривым движком (WordPress) и то может создавать url с дублированным некачественным контентом. Что уж говорить про магазины с сотнями товарных категорий, тысячами товаров и разнообразным функционалом?

Второй отчет по роли аналогичен, только со списком акцепторов сравнивается не sitemap, а список страниц, которые дают поисковый трафик.

Много ссылок/мало трафика и наоборот

Здесь выявляются как раз те ситуации, что описаны в начале статьи.

Если видим, что на страницу ведет довольно много ссылок – смотрим, нельзя ли дополнительно оптимизировать контент так, чтобы он мог собрать больше трафика за счет ссылочных факторов (разумеется, нужно сначала посмотреть откуда ведут ссылки и с какими анкорами). Кстати, такая процедура может быть полезна не только в плане SEO. Когда ссылки дают переходы, полезно добиться, чтобы пользователи получали то, зачем переходят на сайт.

Если наоборот страница собирает много посетителей с поиска без особой ссылочной массы – стоит проверить, не удастся ли увеличить этот поток еще несколькими аккуратно поставленными линками.

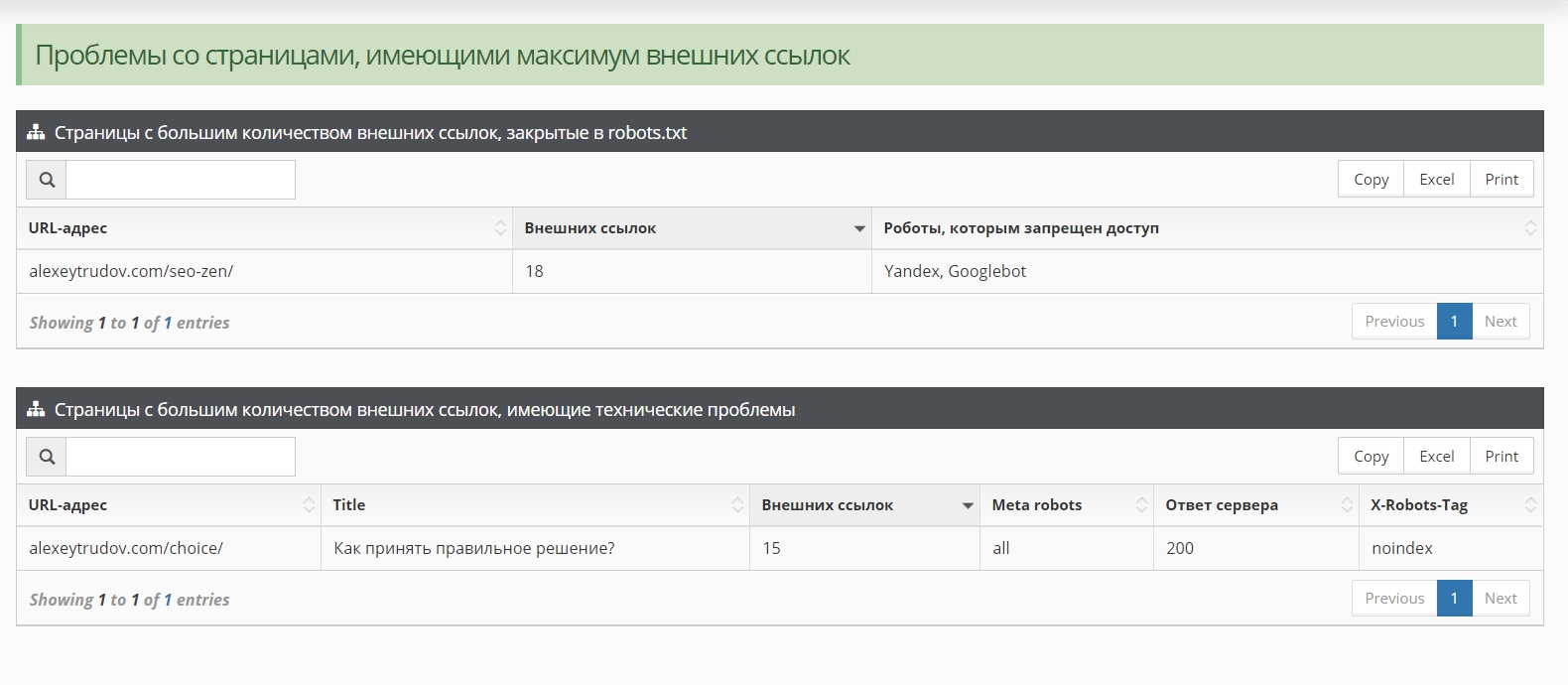

Проблемы со страницами, имеющими максимум внешних ссылок

Здесь все просто. Когда самые популярные с позиции PageRank документы на сайте либо не существуют, либо закрыты от индексации тем или иным способом – это не особо хорошо.

У меня на блоге таких не нашлось, поэтому я имитировал проблему для наглядности:

Страница SEO-цитатника на время анализа была закрыта в robots.txt, а для инструмента принятия рациональных решений я воспользовался менее распространенным способом – указал заголовок X-Robots-Tag. Кроме того, сервис выведет в этот отчет обильные внешними ссылками страницы, отдающие код, отличный от 200 (например, 404 – страница не найдена) или закрытые через meta robots.

Итоги

Итак, новый функционал поможет вам:

- Определить несоответствия между внешними ссылками и контентом, чтобы увеличить отдачу от того и другого.

- Найти мусорные страницы и технические дубли, которые сложно обнаружить другими методами.

- Проверить, нет ли технических проблем с самыми “жирными” документами на сайте (случается не так часто, но если найти и устранить – это дает хороший эффект).

(Разумеется, пытливый SEO-аналитик вытащит из отчетов гораздо больше; перечислен минимум, доступный всем пользователям независимо от уровня знаний).

Важно! Для выполнения анализа необходимо предоставить доступ к Яндекс.Вебмастеру.

Как обычно, в честь выхода новой версии пару дней будет скидка 30% — специально для отважных пользователей, которые не боятся возможных багов. Заходим, проверяем сайты, растим трафик с помощью ссылочного и не только!

Предыдущие анонсы: версия 0.1, версия 0.2, версия 0.3, версия 0.4, версия 0.45, версия 0.5, версия 0.6, версия 0.65.

SEO-прорыв ждет вас!

Что в планах дальше? Чего стоит ждать?

Планов много 🙂

Не все получается сделать так, чтобы было и просто и эффективно и более-менее универсально. Многие вещи в стол складываю.

Вообще на очереди кардинальное улучшение отчета по контенту (этого).

нормально так дела идут-)))

😉

Алексей, а что делать старому сайту с большим количеством ссылок? Например, портал в несколько десятков тысяч страниц, который за 10 лет существования накопил 1500 естественных ссылок с разных доменов.

Допустим список ссылок можно получить с помощью вашего сервиса или какого-нибудь ahrefs? Но бывает, что страница выпадет из индекса, и ссылка перестаёт учитываться поисковиком, например страница с ссылкой ушла глубоко по уровню вложенности или просто качество неочень, а может ещё по какой-то причине. Как заставить поисковики держать такую большую массу страниц на других сайтах в индексе постоянно, и как всё это отслеживать?

Не думаю, что задача особо приоритетная. Если качество не очень, то толку с такой ссылки в любом случае будет мало, даже если загнать донора в индекс. Но если такая задача стоит – то можно выгружать Вебмастер и ahrefs, искать отсутствующие в Вебмастере и стимулировать их индексацию (твиттами, например).

“Если качество не очень, то толку с такой ссылки в любом случае будет мало, даже если загнать донора в индекс” – поэтому аргументу не соглашусь, бывает что ссылка стоит как на первоисточник с федерального качественного ресурса с 10000 тиц, а страница не в индексе, потому что новость короткая, символов 200. Но толк от такой ссылки определённо будет не нулевым и имеет смысл как-то её загнать в индекс.

Вопрос как стимулировать индексацию? Хотя бы для малых масштабов. Просто тот же твиттер я пробовал и не особо остался доволен результатом. Тестил индексируемый акк с несколькими тысячами подписчиков пару месяцев назад, эффекта это не дало. Говорят тема умерла. Можете посоветовать ещё какие-нибудь методы для принудительного загона в идекс?

Тогда можно попробовать ставить ссылки с морд на какое-то время, потом снимать.

Если не поможет – то ставить постоянные ссылки на доноров – Михаил Шакин много писал про эту методику.

“Михаил Шакин много писал про эту методику.” – Алексей, а не поделитесь ссылкой где он писал? На блоге его что-то не могу найти. Или подскажите хотя бы когда и где это было.

Это схема “Удар шершня” 🙂