В конце сентября произошла серьезная тряска выдаче Google. Ее нередко называют обновлением алгоритма Fred. Некоторые изменения в нем действительно произошли, но списывать все на старого доброго Фреда без дополнительного анализа неправильно. Сначала нужно как следует покопаться в выборках пострадавших и выигравших сайтов.

Как обычно, прежде чем садиться за рычаги экскаватора и проводить собственные исследования, я внимательно изучаю, что уже известно (а вдруг и делать ничего не придется?..)

Какими наблюдениями и гипотезами делятся аналитики и владельцы пострадавших сайтов?

Вдумчивое гугление в течение половины рабочего дня принесло не особо богатый улов. Тезисы:

- Ряд пострадавших сайтов относится к медицинской тематике; на основании этого делается вывод, что новый алгоритм нацелен на более строгую фильтрацию YMYL-страниц (расшифровывается как Your Money, Your Life), то есть контента в серьезных тематиках, например, связанных со здоровьем или финансами. К таким документам предъявляются повышенные требования по качеству и достоверности.

- Зачастую отслеживаемые поисковые запросы не теряют позиций, но трафик существенно проседает. Это пытаются объяснить предположением о ротации выдачи (то есть в момент съема просто попадается удачный старый ТОП-10, но многие пользователи видят новый, где позиции стали хуже).

- Отсутствуют внятные комментарии от представителей Google. Общих признаков у просевших сайтов выявить не удается (этим, в общем-то, никто толком не занимался). Вывод – работает просто сумма алгоритмов, комбинация фильтров, реагирующих на контент, ссылки, поведенческие факторы.

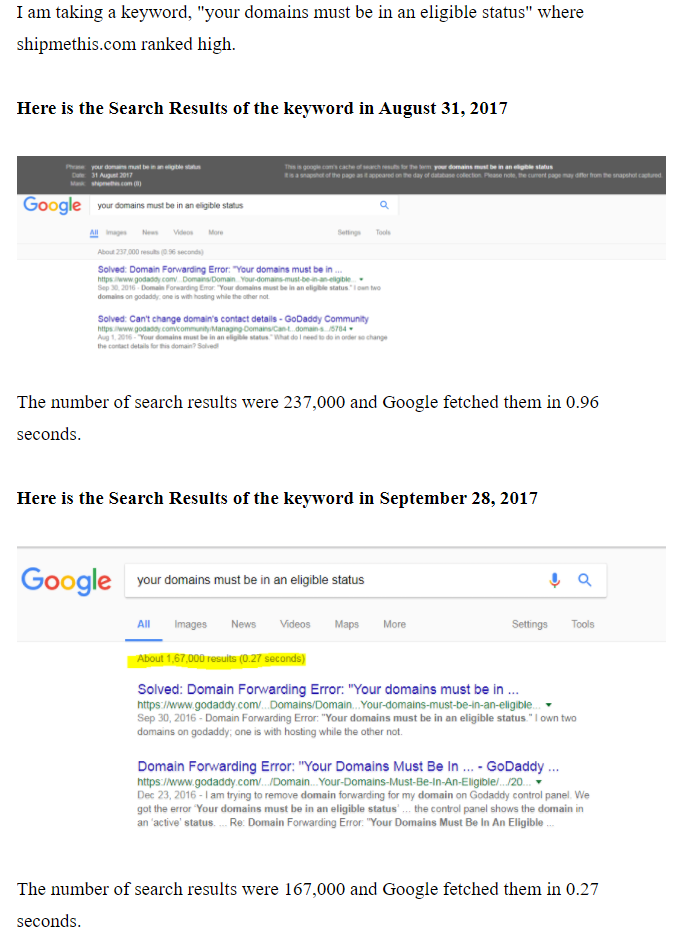

Как пример великолепно обоснованной аналитики не могу не привести такое наблюдение (длинный скриншот статьи, кликабельно, как и остальные картинки здесь):

Автор сравнил количество результатов поиска по одной и той же фразе 31 августа и 28 сентября, увидел, что во втором случае их на 70000 меньше, но выше скорость поиска и уверенно делает вывод: Гугл удаляет “плохие” страницы из выдачи, чтобы давать ответ быстрее; это значит, что сайты без ссылок с высококачественных страниц (которые удалены не будут) ждет серьезный ущерб.

Автор сравнил количество результатов поиска по одной и той же фразе 31 августа и 28 сентября, увидел, что во втором случае их на 70000 меньше, но выше скорость поиска и уверенно делает вывод: Гугл удаляет “плохие” страницы из выдачи, чтобы давать ответ быстрее; это значит, что сайты без ссылок с высококачественных страниц (которые удалены не будут) ждет серьезный ущерб.

Всерьез это принимать конечно же нельзя. Достаточно вспомнить, что количество найденных страниц сугубо ориентировочно и может меняться при листании выдачи а также о том, что Google очень тщательно хранит у себя на серверах даже давно неактуальные результаты. На последнем его свойстве основан простой способ поиска зеркал сайтов.

Для тех кто не любит читать внимательно – подчеркиваю, что выше изложены не мои мысли, а выжимка прочитанного по теме. А вот теперь перейдем к наблюдениям и фактам.

Анализ сайтов с просадкой или ростом трафика из Google в сентябре

Пока удалось найти 17 сайтов, где посещаемость аномально снизилась и 12 – где выросла. Не так много, чтобы быть абсолютно уверенным в выводах, но я всегда придерживаюсь правила “лучше меньшая, зато чистая выборка”. К проектам, взятым на анализ, довольно много требований:

- изменения не связаны с сезонностью или событийным трафиком;

- есть доступ к системе веб-аналитики и/или детальное описание проблемы от владельца (а желательно еще и доступ к Search Console);

- трафика и до, и после, достаточно много (если вместо 10 человек стало ходить 5, это еще ни о чем не говорит);

- динамика трафика в Яндексе противоположна или же трафик оттуда стабилен (для англоязычных проектов – дополнительные проверки на отсутствие банальных технических проблем).

Можете представить, сколько сайтов было убрано из рассмотрения на этапе подготовки данных.

Для начала проверим описанные в самом начале статьи гипотезы разных людей.

Тематика пострадавших сайтов

В выборке есть проекты, совершенно точно не относящиеся к YMYL. Встречается и медицина, и финансы, однако есть несколько сайтов, для которых “серьезность” не очевидна (автотюнинг) и вообще отсутствует (анекдоты).

Первый вывод – потерять трафик из Google из-за новых алгоритмов может любой сайт, независимо от темы.

Характер падения посещаемости

Сайт может терять посетителей разным образом. Могут “отваливаться” важные ключи. Могут попадать под фильтр самые прокачанные документы. Могут вылетать из индекса тысячи менее важных страниц, что ведет к потере низкочастотников. Понять тип просадки – значит сделать первый шаг к выбору оптимальной стратегии по возврату нажитого непосильным трудом трафика.

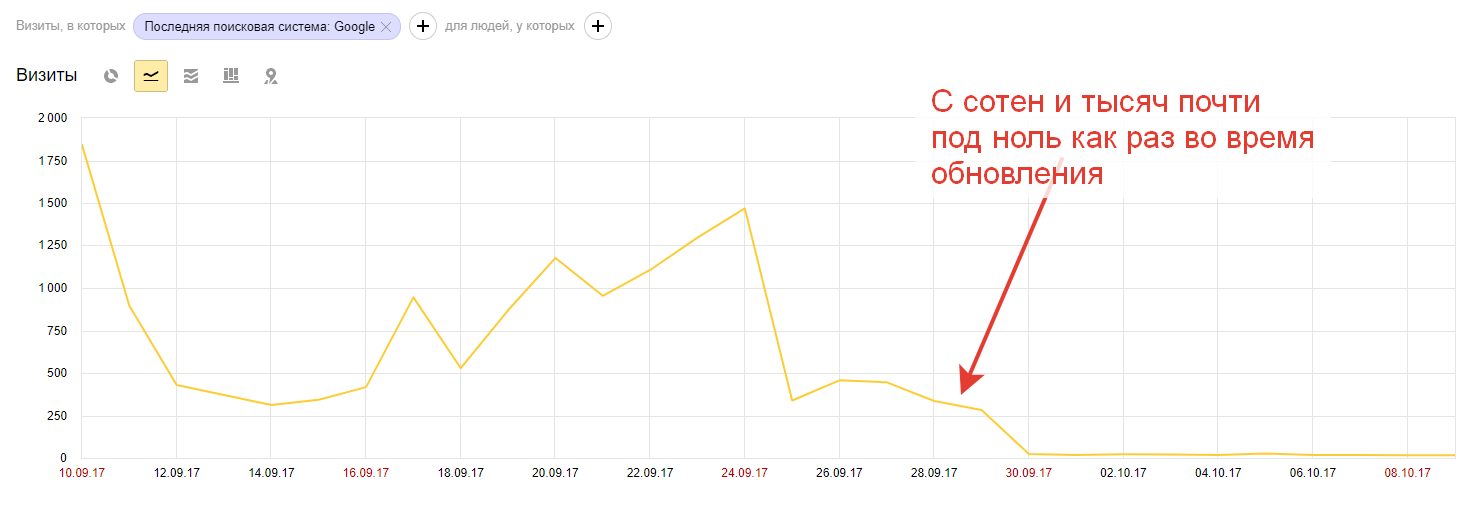

В нашем случае картина достаточно ясная. Практически на всех сайтах выборки потери были в первую очередь связаны со снижением посещаемости наиболее важных страниц (10-20 самых трафиковых документов). Вот типичный пример:

Что насчет динамики точек входа?

Вот данные по сайтам, которые потеряли трафик:

Видим, что поголовье рабочих пчелок – страниц, которые приносят визиты из Google в целом не поменялось. Где-то подросло, где-то упало. Просто некоторые пчелки стали носить гораздо меньше меда.

Примечательно, что для успешных сайтов картина гораздо более смазанная. Выделить десяток документов, которые вдруг сильно прибавили не получается, трафик распределяется более равномерно.

Все указывает на то, что характер санкций нового алгоритма – страничный или запросный, а не хостовый в отличие от того, что мы видели в феврале и марте (собственно Fred-а). Разберемся, за какие грехи они могут покарать.

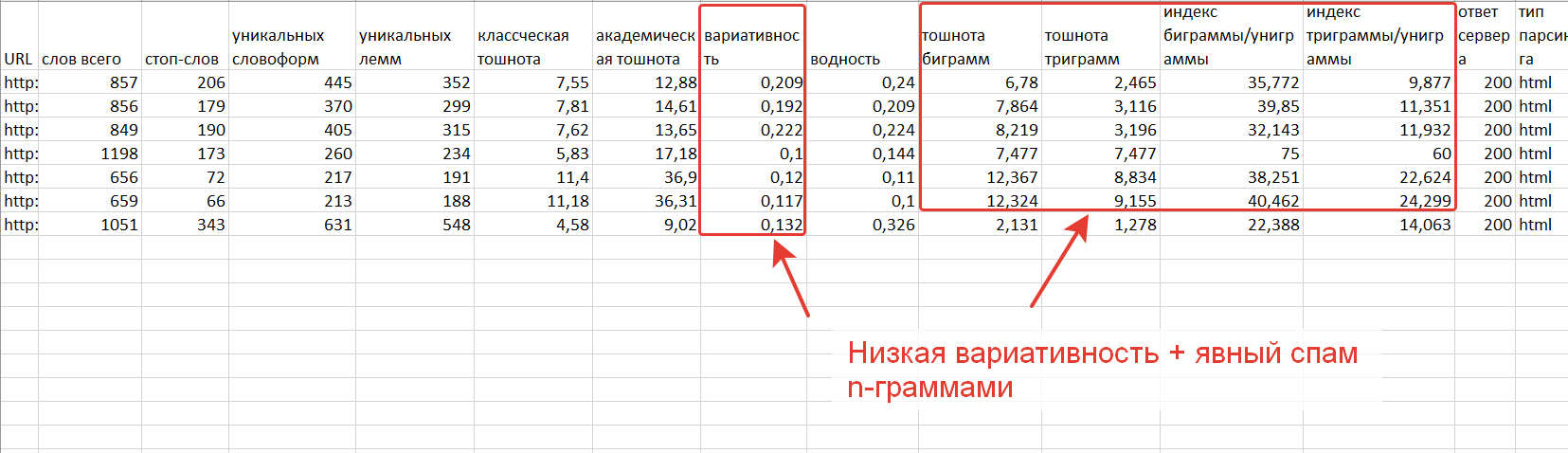

Анализ контента на страницах с наиболее сильной просадкой

На самом деле особая аналитика здесь оказалась лишней. С первого взгляда понятно, что тексты откровенно и нагло переоптимизированы. Для наглядности посмотрим на текстовые метрики, которые оказались актуальны при анализе Баден-Бадена. Скриншот анализа текста нескольких страниц с наиболее выдающейся просадкой (выполнен с помощью этого инструмента).

Не буду останавливаться на подробном разборе показателей. Если вы читали мои статьи, посвященные Баден-Бадену и текстовой релевантности, то от этой таблички ваши волосы должны встать дыбом (как! как такое еще совсем недавно собирало сотни человек в сутки!?).

Характеристики конкурентов просевших страниц

Только на основании изучения контента просевших страниц, конечно же, нельзя делать окончательный вывод. Google вообще-то любит (любил?) слегка подспамленные тексты. Как минимум, надо посмотреть, какие документы заняли место просевших.

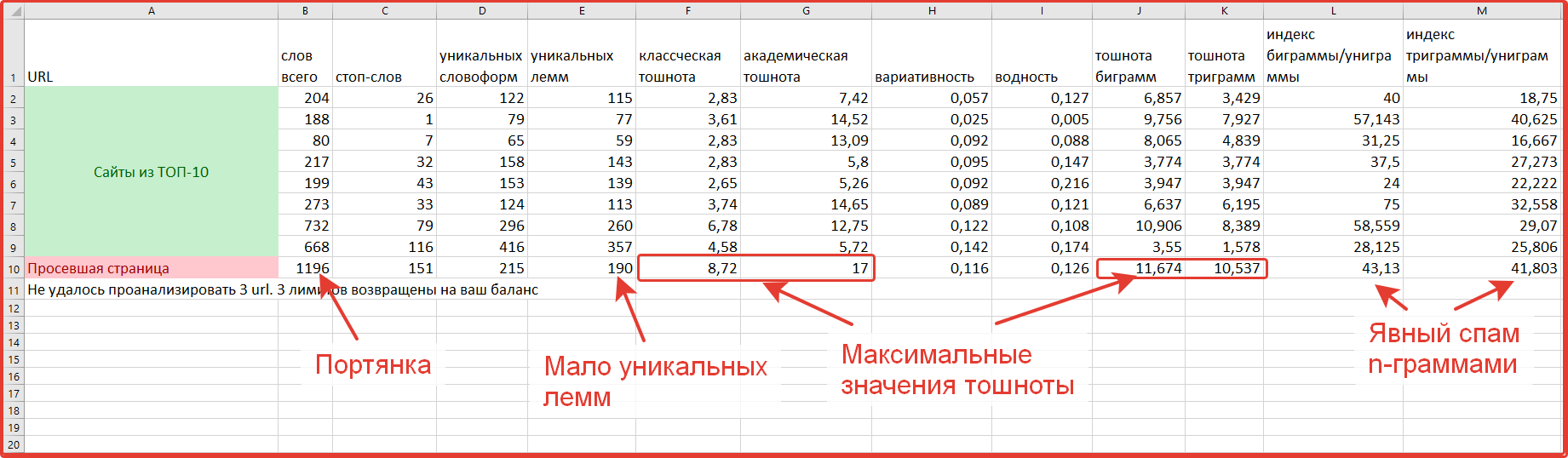

Различия достаточно явные. Пример:

Аналогичная картина наблюдается для большинства других страниц. Но не для всех. И это замечательно, так как открывает новые возможности для анализа, помогает глубже понять суть алгоритма.

Чем отличаются страницы, которые восстановили трафик в начале октября

Исследованиями я занимался в прошлый четверг, но отложил публикацию до сегодняшнего дня, разделив статью на две части. Пока пост пылился в черновиках, несколько документов вернули часть посещаемости. Пример:

Здесь, как видите, вернулась даже не часть, а весь трафик (скриншот сделан 9 числа, то есть последний день – неполный). Сравним страницу с другими обитателями ТОПа по основному запросу:

Красным я выделил метрики других страниц, которые сильнее, чем у изучаемой, отклоняются в сторону спама. Достаточно посмотреть на индексы и тошноту n-грамм, чтобы понять, что наш документ – далеко не самая паршивая овца в стаде. Аналогичные результаты вплоть до ТОП-50 (дальше не смотрел). Ниша весьма конкурентная и в ней принято основательно пичкать тексты ключами. По большому счету, Гуглу там особо не из чего выбирать.

Обсуждение результатов

Разумеется, мы не можем только на основании этих данных считать переоптимизацию единственной причиной проблем с трафиком из Google в последние недели. Уверенность может дать только эксперимент. То есть надо взять штук 100 пострадавших страниц, убрать на них лишние вхождения и подождать месяц-другой, не трогая другие подозрительные элементы (а придраться всегда есть к чему). Но это если подходить с точки зрения академически правильного исследования. Которое, разумеется, проводить никто не будет (лучше как можно быстрее вложиться комплексно и переработать упавшие страницы, чтобы перестать упускать выгоду).

Тем не менее, я считаю, что отстрел переоптимизированных страниц – главная, если и не единственная причина, вызвавшая шторм в выдаче. Об этом говорит и тот факт, что сайты в выборке сильно отличаются друг от друга по тематике, направленности (коммерция/статейники/каталоги), типу контента, способам монетизации. Зато злоупотребление вхождениями свойственно для всех без исключения.

Обновление в виде текстового спам-фильтра хорошо объяснят и наблюдения некоторых вебмастеров (“позиции вроде на месте, а трафика нет”). Вспомните то же исследование Баден-Бадена. Оказалось, что сильнее всего трафик просел по сопутствующим запросам, то есть тем, которые не полностью содержались в тексте. Так и здесь – основной запрос, под который затачивали зафильтрованную страницу, может устоять (раз уж по нему документ имеет максимальную текстовую релевантность), а вот “длинный хвост” отваливается.

Нужно понимать, что в изучаемой выборке отловлены в первую очередь сайты с огромной просадкой посещаемости, самые яркие примеры. Наверняка изменения затронули довольно много документов, просто это маскируется ростом на других страницах (или ростом позиций по другим запросам). Урезанная статистика по ключам в Google оставляет много места для гипотез, которые еще предстоит проверить.

Резюме

Общие выводы

- Самое свежее обновление алгоритма, в отличие от предшественника, работает на уровне отдельных страниц, а не всего ресурса. В группе риска – страницы с высоким содержанием ключевых слов и n-грамм, высокой “водностью” и низкой вариативностью.

- Далеко не все спамные документы теряют позиции. Если текстовые метрики мало отличаются от типичных в нише, то даже высокие оценки спама по разным показателям не означают немедленную кару (хотя это может повредить в ближайшем будущем).

- Причиной снижения видимости в последние недели может быть в том числе комбинация нового подхода к определению качества страницы (апдейт Fred-а) и новые санкции для переоптимизрованного контента. Возможно, работают и другие (хотя скорее всего более слабые) факторы.

На заметку для практики

- В случае просадки трафика в сентябре в первую очередь стоит определить характер потерь. Если общее число точек входа из Google не упало и, особенно, если просадка связана с небольшим количеством важных страниц, то правим контент, удаляем элементы переоптимзации.

- Новые тексты под Google стоит писать с учетом более жестких порогов по вхождениям. Особо полагаться на ТОП для текстовой оптимизации в ближайшее время нет смысла. Судя по всему, процесс еще идет и зафильтрован далеко не весь спам, которому предназначено утонуть в выдаче. Кроме того, даже по конкурентным запросам наблюдается большой разброс в текстовых характеристиках топовых документов.

- Стоит проверить сайт на просадку трафика по всем страницам во вторую половину сентября. Даже если посещаемость вернулась к исходному уровню, нужно понимать, что вернувшиеся к жизни документы “на карандаше” у Google. Маленькие сайты можно пересмотреть просто вручную, для больших можно воспользоваться инструментом по оценке изменения трафика.

В целом, ничего особо страшного не произошло. Хороший шанс для новых проектов обойти старичков, оптимизированных по канонам семилетней давности. Для старичков ситуация тоже не самая критичная. Так как новые алгоритмы работают на уровне страниц, то бороться с ними должно быть достаточно просто. Берем самые важные url и доводим до ума. Это вам не Минусинск (а удали-ка 50000 ссылок на чужих площадках!). Кто с Яндексом бодался, тот Гугла не боится, не так ли? Удачи!

p.s. Репосты мотивируют и дальше подробно описывать свои исследования 🙂

А я думаю, что Гугл дно. Как источник трафика. Когда я создаю новый сайт, я целый год получаю трафик с Яндекса, лишь на второй какой-то мизер от гугла.

Ссылки я не покупаю.

Возраст в Гуле сильнее влияет, да. Ну и без ссылок сложно.

у меня для нового сайта трафик с гугла идет аналогично яндексу. даже немного опережать стал последнее время.

Алексей, Спасибо за исследование!

Пожалуйста, рад что оценили!

Просто СПАСИБО с Большой буквы!

😉

Есть и обратная ситуация. Текст уменьшали, позиции – РАСТУТ, а трафик – упал и равномерно по всему (регионы, посадочные). Есть мысль, что потеряли по длинному хвосту запросов за счет того, что урезали текст, но не факт. Как это проверить наверняка?

Сравнивать данные из Search Console за периоды в первую очередь.

Спасибо!

Это проделано в первую очередь.

В Search Console есть данные по дням и только 5000 запросов. Или можно вытянуть больше как-то?

Там никаких аномалий….

Есть еще мысли?)

Должно было бы отразиться и на 5000 запросов, если у вас не суперогромный проект)

Ну а так – можно глянуть Serpstat еще что он там по видимости показывает.

> Должно было бы отразиться и на 5000 запросов, если у вас не

> суперогромный проект)

Меньше трафика стало суммарно. Размазано по всей семантики, что выгружается из SC. Где-то меньше переходов, где-то больше по запросы (в периодах до и после падения), но в целом – меньше. Позиции же даже лучше стали в Мск. И в регионах нормальные. И по всем регионам небольшое снижение.

Могло кстати просто дополнительным контекстом вниз сдвинуть.

> Могло кстати просто дополнительным контекстом вниз сдвинуть.

Ну запросов много, может быть.

А не подскажешь, когда Google 4е ввел?)

В тематике могло просто больше контекста стать. Не для всех же сразу 4 стало. А вообще все это игры в телепатов, надо сайт толком изучать.

Отличное исследование!

Вопрос – а когда в гугле после старта странице можно рассчитывать на трафик?

и можно ли сделать инструмент текстового анализа попроще в плане того, что вводишь текст или урл и он выдает к примеру: “Страница возможно под баденом т.к. превышены показатели 1, 2, 3.” и в пакетном анализе также чтобы была колонка дополнительная.

Спасибо!

Да хоть с первого дня, если не особо сильная конкуренция. См. в прошлом посте мой собственный кейс.

Можно.

Но он будет врать 🙂

С точки зрения продаж сервиса сделать такую штуку было бы очень круто. Но всегда слишком много нюансов (и это хорошо, иначе и оптимизаторы были бы не нужны вообще). Совесть не позволяет давать заведомо неправильные в 40% случаев рекомендации. Потихоньку конечно работаю в этом направлении, но выйдет ли толк – непонятно.

>> Совесть не позволяет давать заведомо неправильные в 40% случаев рекомендации. Потихоньку конечно работаю в этом направлении, но выйдет ли толк — непонятно.

Да, было бы круто, потому что много разговоров, но чтобы на массовый рынок это вывести, нужна точность, а если пока 40% ошибок, тогда понимаю.

Ну вот что трафик с первого дня согласен, но вот к примеру страницу не дает в топ10 завести по ключам. только медленно подходят запросы: http://prntscr.com/gvx8y9

И даже с частотностью типа 50, 100 – нет топа.

Нет доверия к странице пока? (dxmadracer.com/gaming-chairs-dxracer/)

Думаю да, все стандартно – в Google рулят возраст+ссылки.

А есть подобный разбор для Freda в феврале-марте? До сих пор очухаться не могу. Статей 6, они ещё и под баден попали, исправлял, убирал переспам. Но в обоих поисковиках за пару недель траф на них только ещё упал.

В прошлом посте http://alexeytrudov.com/web-marketing/seo/chto-nuzhno-znat-ob-algoritme-google-fred-osen-2017.html есть презентация с SEMPRO в мае, там как раз подробно рассказывал.

Интересное исследование – благодарю! А мне повезло – с сентября Гугл вдруг “увидел” мой сайт по мед.тематике (ссылок не покупаю) и пошел трафик. Я даже удивилась слегка (тьфу-тьфу!).

Возможно как раз из-за отсутствия переоптимизации. В медицине видел не один и не два сайта, где хороший контент просто испорчен избытком вхождений. Вот они вам место в ТОПе и освободили.

Спасибо!

У меня на категорию вылетели все запросы 5 дней назад. Возможно и меня догнало. Попробуем переписать, может попустит.

Эх, на протяжении августа – сентября плавно вылетело 40% нч. А трафик почти не просел.

Довольно любопытно было почитать статью, читаю тему на сёрче так-же (где на вашу статью дали ссылку). Тоже заметил просадку трафика и поддерживаю мнение что слишком большая плотность ключей могла стать причиной.