Что ж, этот день настал.

Больше трех лет я специализируюсь на SEO-аудитах. Давно хотел обобщить и систематизировать опыт сотен проанализированных проектов. Материалов по теме очень много, есть даже огромные чек-листы на сотни проверок. Однако подавляющее большинство руководств рассказывает об аудите как о механической проверке бесконечного числа технических параметров. Порой эти проверки имеют довольно косвенное отношение к привлечению поискового трафика.

Для меня аудит больше похож на увлекательное детективное расследование. От технических мелочей никуда не деться – но это всего лишь сбор улик. Настоящая же цель – найти и обезвредить недостатки сайта, которые крадут его потенциальный трафик по важным для бизнеса ключевым словам.

Нет смысла строить идеальный сайт – это дорого и долго (тем временем и критерии идеальности могут измениться). Нужно делать сайт, отвечающий целям проекта. Задача аудитора – дать рекомендации с хорошим соотношением эффект/затраты, нащупать волшебные 20% усилий, приносящие 80% результата.

Пост в первую очередь адресован специалистам и вебмастерам, которые хотят делать достойные аудиты (ой, кажется я ращу себе конкурентов… ну ладно, за статью уже взялся, не пропадать же добру). Потенциальным заказчикам тоже не вредно лучше понимать “кухню”, на которой готовятся отчеты.

Итак, добро пожаловать в школу SEO-детективов!

Прежде чем взяться за дело: основы

Что такое SEO-аудит

Уже с определением аудита есть небольшая путаница.

- С одной стороны, аудит – процесс анализа сайта.

- А еще это результат анализа – отчет для заказчика.

Легко понять, что план аудита (то, что увидит заказчик) и план работ (что будет делать специалист) – совершенно разные вещи. Специалист должен сначала тщательно изучить сайт, познакомиться с его спецификой и только потом формулировать рекомендации.

Поэтому составление единого универсального чек-листа или шаблона невозможно. Точнее, никто не мешает придумать тысячу проверок и запихнуть их в план. Но тогда для конкретного сайта половина окажется абсолютно неактуальной (зачем заказчику все это читать?). Что еще важнее – остается риск упустить тысяча первую проблему или способ улучшения сайта. Пока специалист пройдется по всей этой туче пунктов он полностью лишится сил и фантазии.

Единственное, чем хороши аудиты в формате списка проверок – простота генерации. Подключаем API десятка сервисов или сажаем стажера копировать из них информацию руками – и вперед, обрабатывать в день десятки сайтов.

Не буду останавливаться на ущербности этого подхода, уже писал о ней здесь и здесь.

Виды SEO-аудитов

Еще одна причина, по которой обычный перечень пунктов для анализа плохо подходит для работы – огромное разнообразие аудитов.

Прежде всего, они различаются по цели написания. Зачем может потребоваться анализ сайта? Да зачем угодно:

- Как отправная точка для продвижения (классический случай).

- Для контроля подрядчика (такие аудиты – обычно низкого качества – часто приходят клиентам непрошенными).

- Чтобы наскоро залатать дыры перед продажей проекта.

- Наоборот, чтобы оценить потенциал сайта и принять решение о его покупке.

- Чтобы впечатлить потенциального клиента мощью интеллекта и заключить договор на продвижение с абонентской платой.

Сайты тоже бывают разные:

- Находящиеся в разработке/проиндексированные.

- Под санкциями/без явных проблем.

- Интернет-магазины/контентные проекты/сайты услуг/агрегаторы.

Весь процесс анализа и конечное содержимое должны соответствовать задачам и специфике проекта. Загнать многообразие комбинаций “особенности сайта + цели” в один чек-лист невозможно. Но это не значит, что найти общие подходы вообще нельзя и аудиты надо делать повинуясь вдохновению.

Замечание: мы будем рассматривать классический аудит, который выполняется с целью честно заложить фундамент продвижения для уже существующего сайта с трафиком и позициями. Именно ему соответствует наиболее полный и глубокий анализ, так что рассказ будет по-настоящему показателен. Остальные типы выводятся из него расстановкой акцентов в отчете либо пропуском отдельных этапов.

Как сделать полезный аудит: этапы работы

Я придерживаюсь следующей схемы:

- Сбор информации о проекте от владельца.

- Анализ аудитории, поискового спроса и конкурентов.

- Проверка соответствия сайта аудитории и спросу.

- Общий технический аудит.

- Анализ трафика.

- Анализ разделов.

- On-page оптимизация.

- Отображение в выдаче.

- Анализ ссылочной массы.

- Проверка на санкции поисковых систем, оценка рисков.

- Дополнительные проверки, связанные со спецификой проекта.

- Поиск эффективных путей развития проекта.

- Минимизация рисков, связанных с доработками.

- Оформление отчета.

Рассмотрим каждый этап.

I Сбор информации о проекте

Первым делом стараемся максимально облегчить себе работу, собрав максимум данных. Для аудита практически необходимы:

- Доступ к системе статистики (обычно Яндекс.Метрика или Google Analytics). В Рунете Метрика предпочтительнее, так как содержит данные о ключевых словах, дававших трафик из Яндекса.

- Доступ к панелям вебмастеров (в первую очередь Яндекс.Вебмастер и Search Console; более экзотические варианты – панели Mail и Bing тоже не будут лишними).

Также желательно получить:

- Логи сервера минимум за неделю (лучше за месяц).

- Доступ к сервису мониторинга позиций.

- Доступ в биржи ссылок, если есть.

- Семантическое ядро.

- Описание работ, проведенных на сайте за последние 3-6 месяцев, отчеты по продвижению, если есть подрядчик, сделанные раньше аудиты.

- Переписку с техподдержкой Яндекса.

- Вопросы от клиента, описание возможностей по доработкам, созданию контента, общем бюджете (нет смысла давать рекомендации, воплотить которые в жизнь не получится из-за нехватки ресурсов).

Подробно об этом этапе я уже писал, см. статью Как получить от SEO-аудита максимум пользы. Там же – инструкции по предоставлению доступов к панелям и счетчикам.

II Анализ аудитории и поискового спроса.

Портрет пользователя

Погружаемся в бизнес заказчика, чтобы понять, каких именно людей требуется привести на сайт из поисковых систем. Кто его потенциальные клиенты (или, в случае проектов с простой рекламной моделью монетизации – кто охотнее будет кликать на рекламу).

Сначала – самые простые параметры:

- Местоположение пользователя.

- Предпочитаемые устройства (ПК или мобильные).

- Пол и возраст.

- “Боли” и потребности.

Непосредственно для SEO важны первый и второй пункты, однако понимать, кому мы продаем и кто будет пользоваться сайтом тоже весьма полезно.

Отчасти эту информацию также можно получить от клиента, однако для уже действующих проектов наиболее надежным поставщиком данных служат системы аналитики.

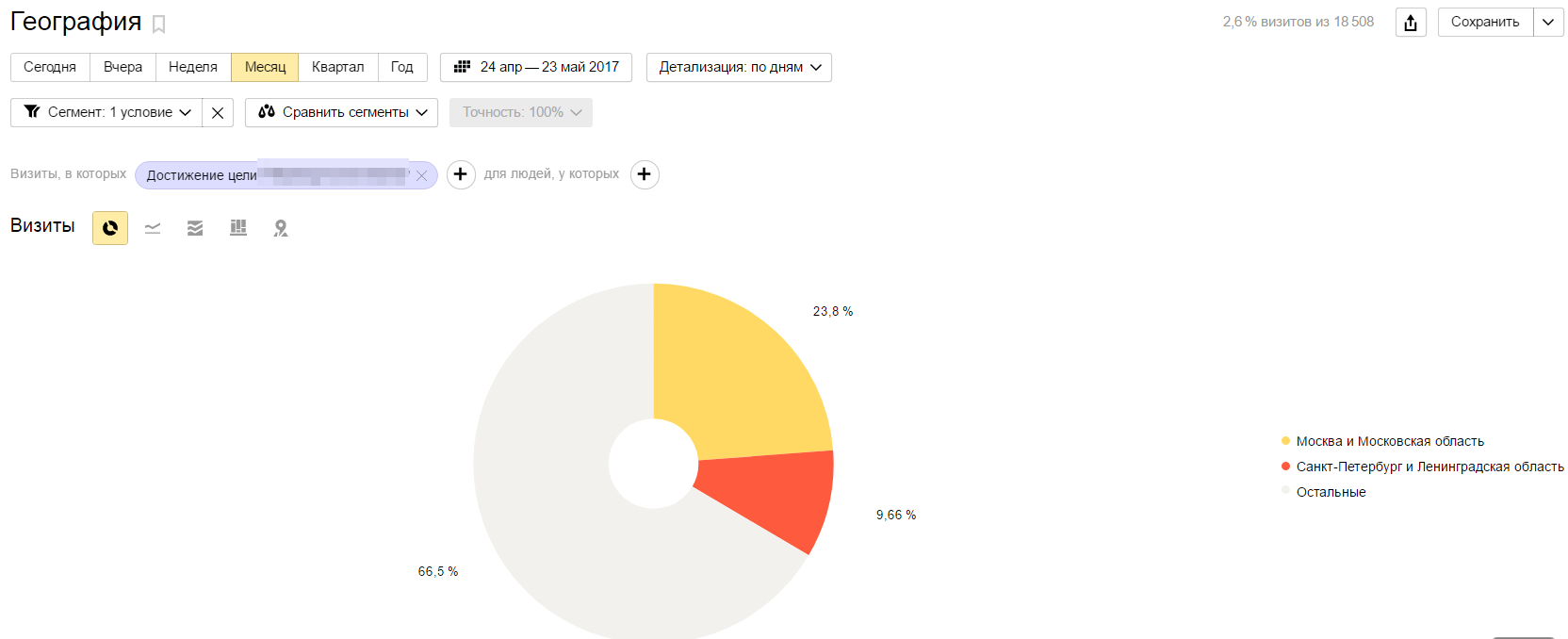

Все что требуется – вычленить аудиторию, которая совершила полезное действие на сайте (стандартный функционал “Цели”) и изучить ключевые слова, по которым приходят эти люди, популярные страницы входа, демографические характеристики.

Например, сегментируем по признаку достижения цели отчет “География” в Метрике:

Из отчета видно, что конверсии дает трафик из разных городов, доля Москвы и Санкт-Петербурга в целом соответствует доле их интернет-пользователей.

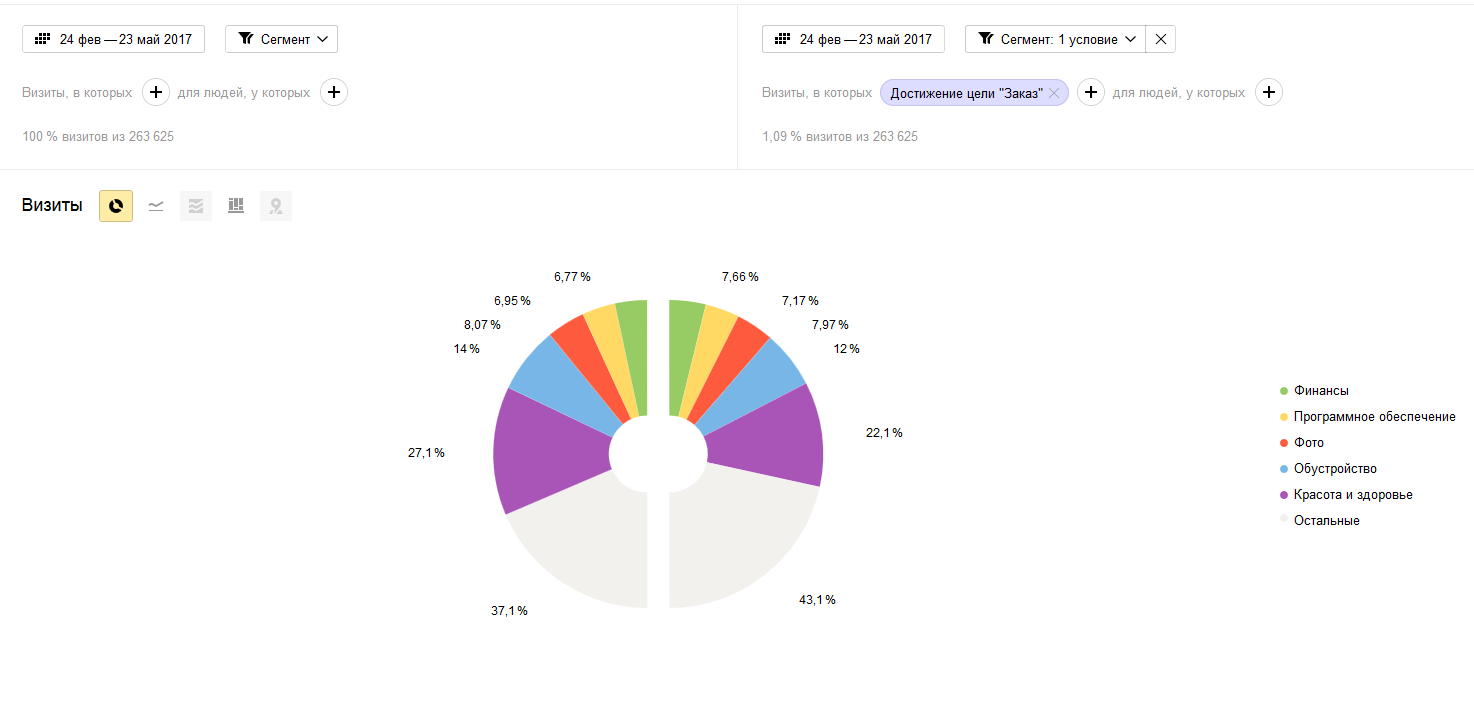

Подобная работа нужна не только в плане подготовки к настоящему анализу. Кое-какие выводы появляются уже сейчас. Например, сравнив интересы аудитории, которая что-то заказывает с интересами всего объема трафика, можно оценить правильность подбора запросов и соответствие контента ожиданиям наиболее ценной ЦА:

В данном случае профили интересов практически идентичны, что говорит об адекватном подборе запросов для продвижения, отсутствии неуместного контента.

Семантическое ядро

Поняв, чего в целом хочет аудитория, где она обитает и по каким ключевым словам уже приходит, мы можем перейти к анализу поискового спроса в нише. Иначе говоря, определяем, по каким ключевым словам потенциальные клиенты вообще могут попадать на сайт.

Составление семантического ядра – отдельная сложная услуга, не входящая в аудит. Однако специалисту абсолютно необходимо определить основные черты поискового спроса в нише.

Три варианта:

- Выполнить первоначальные этапы составления ядра: собрать ключевые слова из wordstat, подсказок, готовых баз (не заботясь об обязательной полноте списка) и кластеризовать в автоматическом режиме, например, с помощью Rush Analytics.

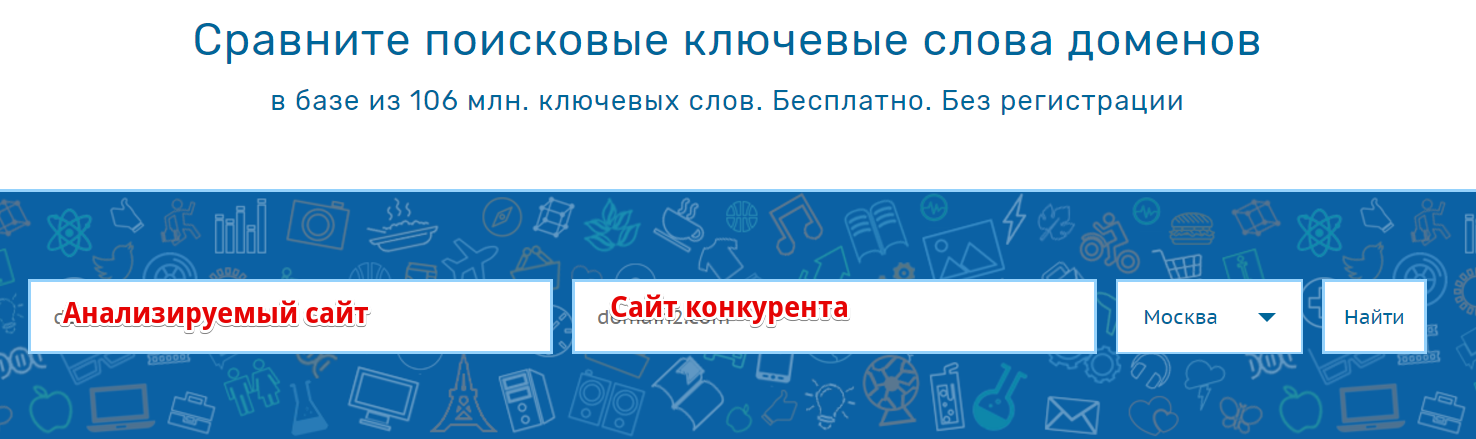

- Провести анализ видимости конкурентов, сравнить между собой их ключевые слова, определить главные запросы в тематике. Для этого пригодятся выгрузки из сервисов видимости, таких как Serpstat или Keys.so (по ссылкам – обзоры с описанием приемов работы). Подробно об этом методе и бесплатном сервисе-помощнике я писал здесь.

- Спрогнозировать спрос по аналогии. В некоторых случаях сайт готовится заранее, когда запросов еще нет, как нет и конкурентов (например, сайты, посвященные еще не вышедшим сериалам, играм, моделям техники). Тогда берем близкий пример и собираем ключевики для него, фиксируя шаблоны запросов. Например, для компьютерной игры очевидные варианты – “название + отзывы”, “название + обзор”, “название + дата выхода”.

Предпочтительным является анализ конкурентов, так как работать с ним приходится едва ли не на всех этапах. Однако в сложных нишах для больших проектов необходимо комбинировать все способы.

В итоге у нас должен получиться черновой вариант ядра. Оно требуется, чтобы:

- Определить наиболее важные запросы тематики (дающие максимум конверсионного трафика).

- Выделить паттерны запросов, типичные конструкции. Например, для интернет-магазинов: “товар + бренд” или “товар + бренд + потребительская характеристика” (“смартфоны ассус с двумя симками”).

- Выявить запросы, которые не входят в предыдущие две группы (часто это те ключи, которые не удалось кластеризовать).

Анализ конкурентов

Типичная проблема многих низкокачественных аудитов – анализ сайта в вакууме, без оценки ниши и конкурентов. Есть и другая крайность: “а давайте все скопируем у топового сайта!”. Почему это плохая идея, читайте здесь.

1. Отбор топовых конкурентов

Основных способов два.

Наиболее надежный – это спарсить ТОП по созданному на предыдущем этапе зачатку семантического ядра и определить домены, которые чаще всего попадают в выдачу. Для парсинга используем, например, KeyCollector, благо он есть практически у всех. Для нахождения доменов с наибольшей видимостью в выгрузке из выдачи используем этот бесплатный сервис.

Более простой и быстрый – используем сервисы видимости. Просто находим сайт с максимальным охватом семантики в нише (лидеры на виду и очевидны), а затем смотрим, какие хосты имеют с ним максимальное число общих ключей в ТОП:

Пример для тематики “продажа автозапчастей” (скриншот из Serpstat):

В этом способе есть риск подхватить в выборку не полностью тематичных конкурентов. Обязательно учитываем его в дальнейшем анализе.

В среднеконкурентных нишах обычно набирается 15-20 сайтов, в высококонкуретных имеет смысл рассматривать больше.

2. Сбор основных показателей

Составляем сводную табличку с основными параметрами – возрастом, ссылочной массой, количеством страниц в индексе.

Таблица в Google Docs с пояснениями и инструментами для проверки. Формат таблицы условный, в зависимости от специфики ниши могут использоваться и дополнительные параметры.

Важно: не забываем, что многие показатели могут также усиливаться зеркалами сайтов. Поэтому каждый домен не забываем проверить на наличие зеркал. Метод проверки я описывал в недавнем докладе (кратко) а также в отдельной статье (более подробно).

Все эти данные потребуются нам на следующих двух шагах.

3. Оценка уровня конкуренции

Обобщаем показатели из таблицы. Здесь важно не просто посчитать некие средние цифры, а определить, насколько велик разрыв между характеристиками анализируемого сайта и типичным конкурентом. Если наш проект имеет не меньшее количество страниц и достаточно сильный ссылочный профиль – то уже на первых этапах не проблема побороться за “вкусные” ключевые слова. Если же сайт клиента выглядит пигмеем – то на первых порах нет других вариантов кроме как уходить от конкуренции “в лоб”.

4. Подбор проектов-аналогов

Данную на предыдущем шаге оценку не следует считать окончательной. Даже если показатели нашего сайта очень скромные, все еще остается шанс отыскать среди конкурентов ресурс с высокой видимостью и трафиком, но не запредельными хостовыми характеристиками. Разумеется, они должны соответствовать нашему по типу. Если анализируем интернет-магазин, то на агрегаторы смотрим вполглаза.

Именно у близких по направленности и SEO-параметрам есть шанс подсмотреть лучшие идеи, которые позволят добиться существенного роста.

Пример: однажды я делал аудит интернет-магазина, торгующего довольно традиционными товарами. Самые мощные конкуренты появились едва ли не одновременно с зарождением Рунета.

Тем не менее, нашлось 3 молодых сайта со слабым ссылочным и отличной видимостью. Их анализ дал возможность выделить успешную схему структуры, которая естественным образом охватывала большую часть семантики и была удобна для пользователя. Появился реальный шанс догнать “монстров” по трафику, так как у них в плане организации контента и распределения семантики все оказалось довольно печально. Клиент остался очень доволен.

Так что если видите в выдаче только “жирные морды” – это не повод опускать руки.

III Проверка соответствия сайта аудитории и спросу

Итак, к этому моменту у нас уже есть представление, каким должен быть сайт, чтобы соответствовать целям бизнеса по привлечению поискового трафика. Сравним это представление с реальностью.

Конкретный список проверок диктуется спецификой аудитории; рассматриваем типичный случай.

Оценка региональной привязки

Если ЦА сконцентрирована в конкретных городах или регионах, нужно позаботиться, чтобы поисковые системы понимали эту привязку.

- Геопривязка в Яндексе делается с помощью указания региона в Яндекс.Вебмастере, Справочнике или Каталоге. Проблемы обычно возникают когда есть желание собирать трафик не с одного региона, а с пары десятков. Наиболее надежным способом в этом случае является создание региональных поддоменов – каждый из них рассматривается как самостоятельный сайт, которому можно задать регион в панели вебмастера.

- В консоли Google функционал по геопривязке ограничен указанием страны. Поэтому подаем поисковику сигнал о региональной принадлежности другими способами. В первую очередь это указание на сайте конкретной контактной информации и регистрация в Google Мой Бизнес.

Для мультиязычных сайтов в Google также требуется настройка атрибута hreflang. Подробно в справке Google: https://support.google.com/webmasters/answer/182192?hl=ru

Анализ оформления и технической составляющей

Юзабилити-анализ не входит в компетенцию SEO-специалиста. Однако сайт должен хотя бы минимально соответствовать потребностям аудитории, чтобы не демонстрировать ужасающе плохие поведенческие факторы.

В первую очередь требуется проверить удобство просмотра на мобильных устройствах (используем инструмент Яндекс.Вебмастера и https://search.google.com/search-console/mobile-friendly?hl=ru).

Для большинства проектов корректное отображение на мобильных строго обязательно и это одна из наиболее приоритетных доработок. О стремительном росте доли пользователей, которые выходят в Интернет только с мобильных, не знает только проживший в глухой тайге последние пять лет.

Тем не менее, мы делаем настоящий ручной аудит, а не заменяем робота, который штампует одинаковые отчеты. Легко представить себе ситуацию, когда внедрение адаптивного дизайна потребует серьезных затрат, при том что доля запросов с мобильных невелика, а у владельца и так есть куда применить ресурсы в ходе подготовки к сезону. Кстати, далеко не всегда оптимизация под мобильные так уж сильно улучшает активность и лояльность пользователей. Вот показательный кейс.

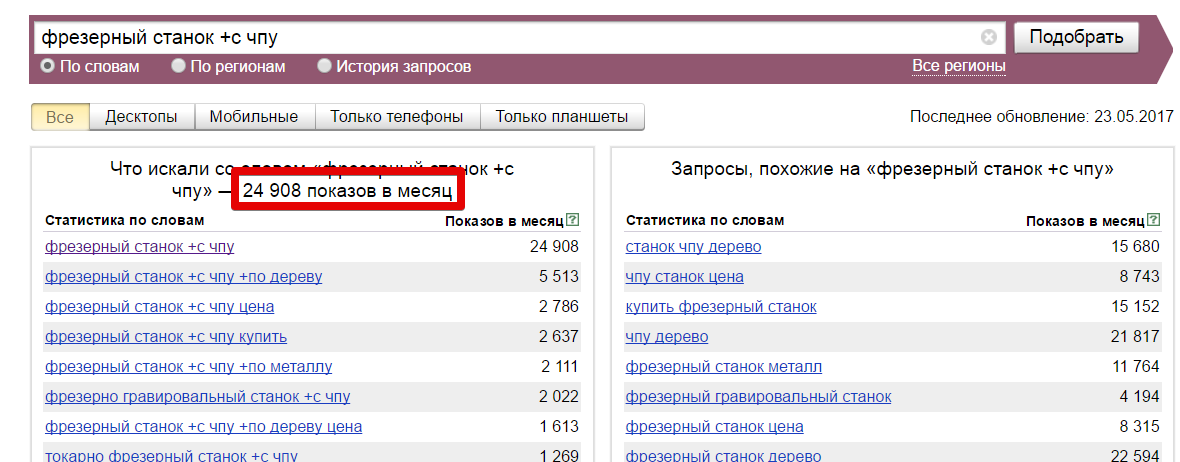

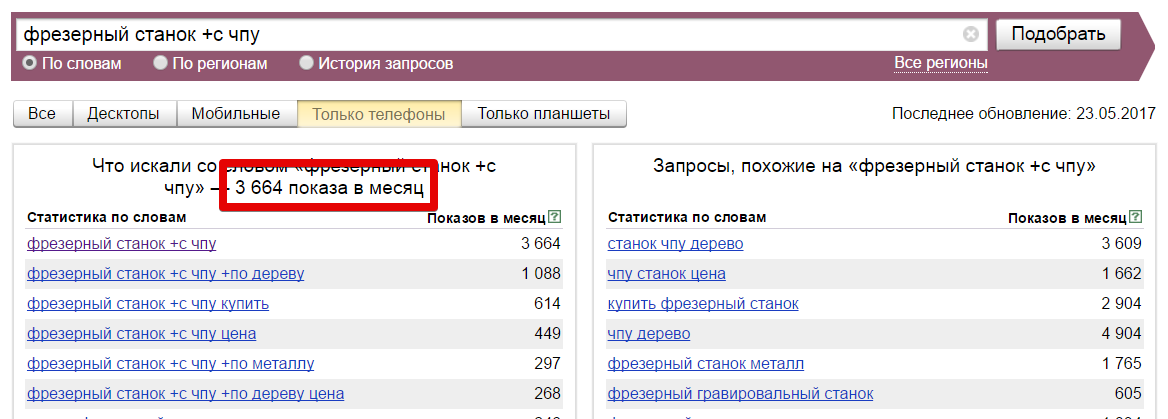

Поэтому прежде чем формировать рекомендацию по этому вопросу, требуется оценить объем мобильного трафика в тематике. Смотрим общее число показов по ключевому запросу со всех устройств:

А затем и с тех, под которые проект плохо оптимизирован:

(для Google аналогичные данные есть в планировщике ключевых слов Adwords).

Аудитор обычно просматривает огромное количество страниц сайта, поэтому к концу работы накапливается множество замечаний по проблемам в работе. Добавить их в отчет не помешает, однако нужно следить за тем, чтобы замечания совпадали с видением ЦА, а не предпочтениями аудитора.

Типичные проверки:

- Адекватная аудитории цветовая гамма.

- Отсутствие раздражающих и нерабочих элементов.

- Проблемы верстки на разных расширениях, в разных браузерах и операционных системах.

Сопоставление структуры сайта с тенденциями в семантическом ядре

После составления семантического ядра мы не зря выделяли три группы ключевых слов. Теперь проверяем, есть ли место в структуре для всех типов запросов.

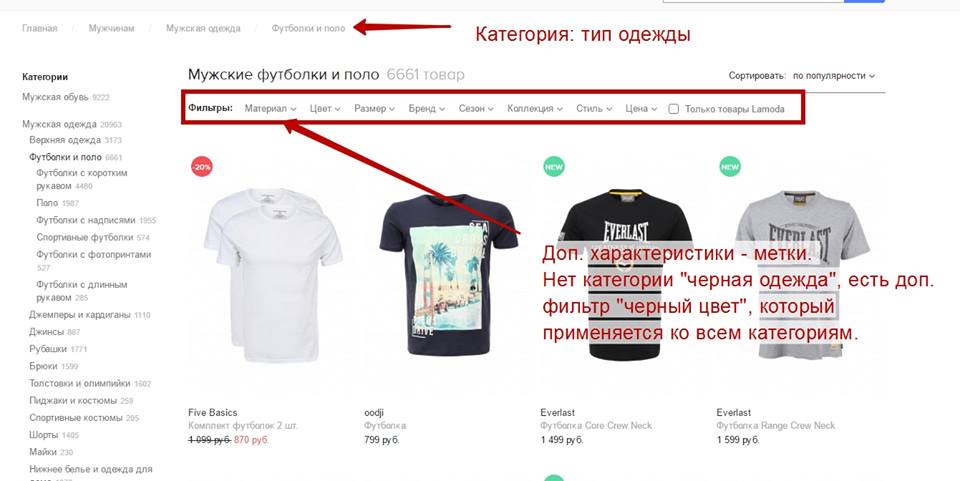

Как правило, самые частотные ключи выносятся на главную и страницы разделов, запросы-расширения охватываются теговыми страницами.

Важно отличать рубрики, что могут стать именно разделами, и те, что следует делать метками (дополнениями для рубрик). В рубрики идут те группы страниц, которые выделены в единой логике, по одному принципу, который является наиболее универсальным, важным и понятным пользователю. Этот принцип должен подразумевать создание сравнительно небольшого числа разделов, тем не менее, охватывающих все страницы. Метки идут на “добивку”. Принцип может выглядеть громоздким, но его легко усвоить, обдумав пример:

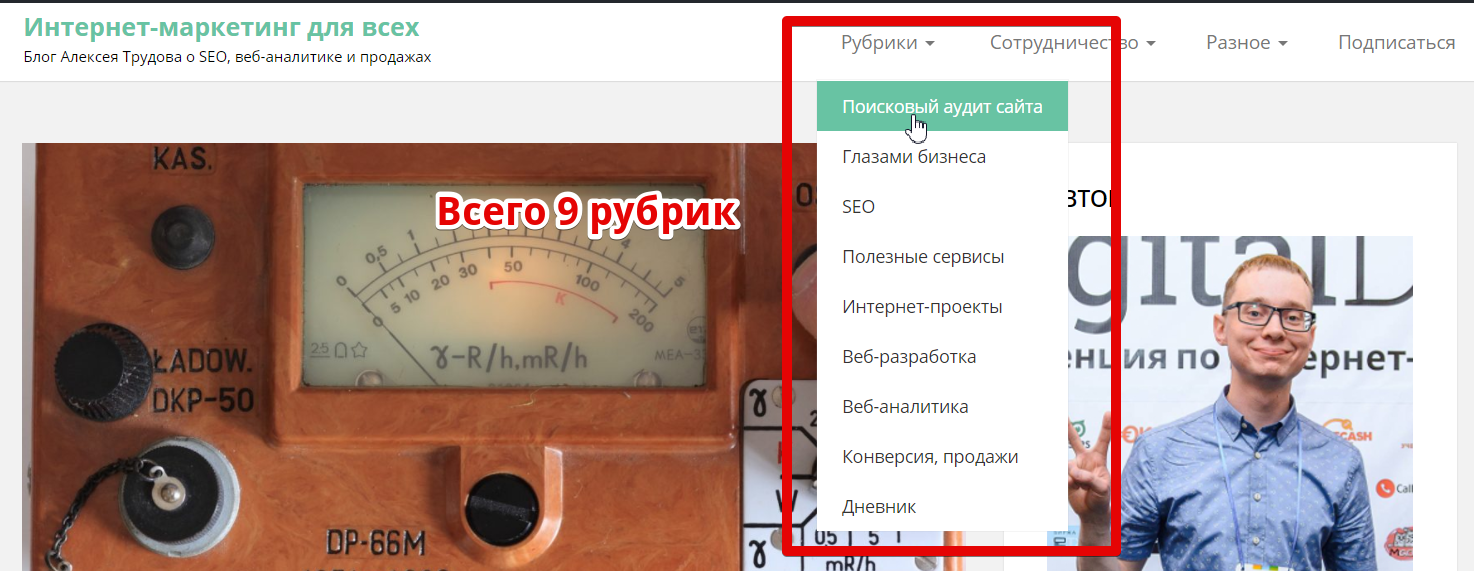

Так проектируется логичная структура, которую при этом можно будет без проблем расширять. Принцип применяется не только к интернет-магазинам. Даже в таком свободном формате сайта как блог структура не повредит. Обратите внимание как организован контент на этом блоге – есть ограниченное число рубрик по основным темам:

Прелесть в том, что к ним можно добавлять метки без особой системы (см. внушительный список в боковой колонке). Когда-нибудь у меня дойдут руки до того, чтобы их проработать, создав эффективные посадочные страницы.

То есть на этом шаге мы проектируем “идеальную” структуру исходя из охвата поискового спроса, стараясь при этом оставить ее максимально гибкой. Разумеется, не помешает посмотреть, как организован контент на реальных сайтах конкурентов. Не обязательно вы найдете полную копию, однако по крайней мере ряд элементов должен встречаться. Если вообще не удалось найти ничего похожего – стоит еще раз обдумать ситуацию. Вероятно, не учтены важные подводные камни тематики.

Затем этот теоретический вариант сравниваем с текущим положением дел.

Поиск релевантных страниц

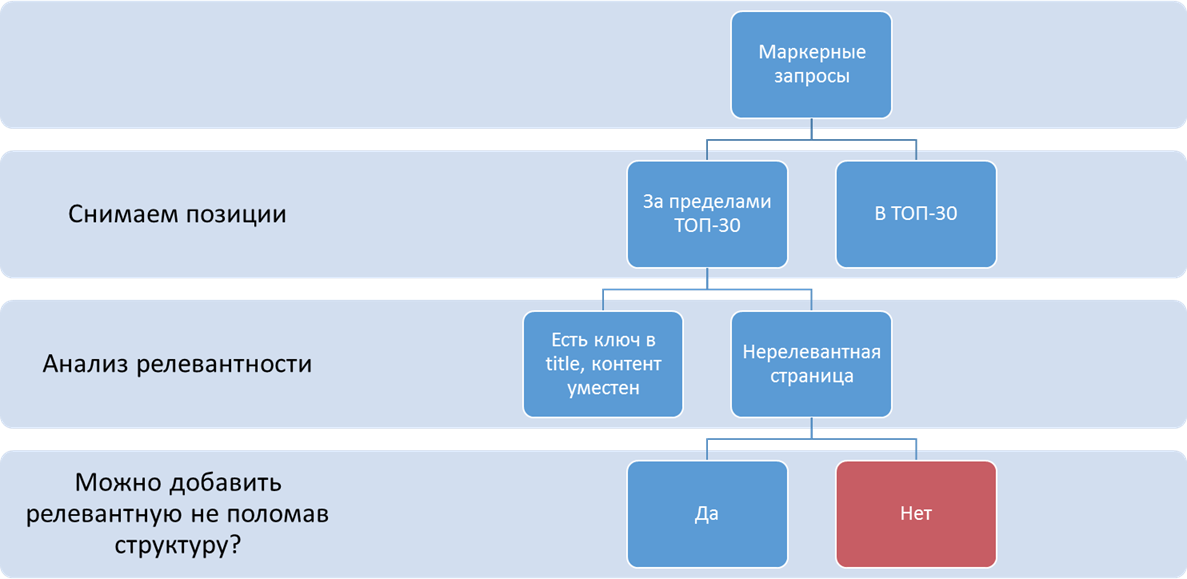

Берем из нашего ядра маркерные запросы (главные запросы кластера) и снимаем по ним позиции. Для запросов, которые не нашлись в ТОП-100 повторяем процедуру, но запрашиваем уже с оператором site:.

В итоге получаем список пар запрос-страница. Просматриваем его, в первую очередь обращая внимание на запросы из первой группы, где сайт оказался ниже ТОП-30 и вторую группу полностью.

Возможны две ситуации:

- под запрос есть релевантная страница (ключ в title, контент адекватен пользовательскому интересу), но она проигрывает в конкуренции.

- под запрос не находится полностью релевантной страницы.

Нас интересует и то, и другое. Низкими позициями достаточно соответствующих запросу страниц (1 случай) мы займемся позже. А вот случаи, когда подходящей страницы на сайте просто нет, рассматриваем уже сейчас. Это пробелы в структуре сайта. Их нужно изучить, чтобы понять – можем ли мы расширить ее так, чтобы нашлось место всем упущенным запросам и не была нарушена логика. Зачастую, если структура изначально была плохо спроектирована, это невозможно. Тогда встает вопрос о полной перестройке сайта.

Предыдущие несколько абзацев кажутся довольно громоздкими. На самом деле ничего сложного здесь нет, все рассуждения элементарны. Чтобы было понятно, набросал схему:

Те запросы, что на последнем шаге попали в красный прямоугольник мы собираем вместе и анализируем. Напоминаю, что мы работаем не с конкретной семантикой – мы ищем ее тенденции, чтобы улучшить структуру сайта. Как правило, в отобранных запросах легко выделить общие признаки и соотнести их с типом страниц в спроектированной ранее “идеальной” структуре.

За счет такого анализа зачастую удается избежать глобальной перестройки сайта (что затратно, долго по времени и грозит временной, но все равно неприятной просадкой трафика).

Сравнение с видимостью конкурентов

Получившийся вариант структуры нельзя считать окончательным. Мы начали с самого простого и важного – запросов, которые обязательно должны быть охвачены. Теперь будет полезно понять, по каким еще ключевикам стоит продвигаться. Не исключено что для достижения максимального эффекта структуру потребуется расширять дополнительно. Будет мудро предусмотреть эту возможность.

Для оценки упущенных запросов пользуемся функционалом “сравнение доменов” в сервисах видимости. Скажем, платные Keys.so или Serpstat. В данном случае подойдет и бесплатный Bukvarix (так как мы оцениваем общие тенденции, а не работаем с окончательной семантикой, то нам не так важна актуальность запросов, которая выше в платных сервисах):

Примечание: это типичный порядок работы, если мы решили конкурировать “в лоб”. Если на основе анализа конкурентов выбрана стратегия ухода от прямого соперничества за ТОП, то структуру строим иначе. Сначала требуется оценить запросы, по которым продвинуться будет реально. Именно на их основе формируем систему страниц. При этом нужно постараться сделать структуру достаточно гибкой, чтобы в будущем ее можно было расширить и/или перенацелить на конкурентные запросы.

IV Общий технический аудит

Предыдущие пункты были всего лишь подготовкой к основной работе. Теперь, когда есть определенное понимание аудитории, конкурентов и общей структуры проекта, самое время перейти к предметному анализу.

Начинаем с базовых вещей, относящихся ко всему сайту.

Проверка robots.txt

Robots.txt – это файл, содержащий инструкции для поисковых роботов. В работе с ним нет ничего сложного, однако требуется особое внимание, так как одна неверная строка в robots.txt может обрушить весь трафик сайта.

Что требуется сделать:

- Проверить соответствие файла стандартам с помощью инструментов в Яндекс.Вебмастере и Google Search Console.

- Проверить наличие директивы Host: для Яндекса.

- Проверить, не закрыты ли от индексации страницы, которые потенциально могут приносить трафик (рассматриваем директивы “Disallow:”, проверяем, не совпадают ли они с шаблонами url важных разделов; для простоты используем те же онлайн-сервисы от Google и Яндекса).

- Проверить, не используется ли закрытие в robots.txt вместо других способов управления индексацией (типичная ошибка – закрывать в robots.txt пагинацию).

Настройки в панелях вебмастеров

- Указано ли главное зеркало.

- Проработан ли раздел “Диагностика” в Яндекс.Вебмастере (там дается много ценных советов по сайту, не все обязательны к исполнению, например, задание региональности неактуально для сайтов с геонезависимыми запросами, но просмотреть этот раздел стоит) и уведомления в Search Console.

- Видит ли робот карту сайта.

Анализ sitemap.xml и составление полного списка страниц сайта

Вообще-то sitemap необязателен, это просто дополнительная точка входа роботов. Однако для крупных сложных проектов его наличие облегчает индексацию в случае проблем со структурой и перелинковкой. Если sitemap корректен, его удобно использовать для самых разных приемов SEO-аналитики. См. подробную статью про sitemap.

Даже если не использовать sitemap.xml по прямому назначению, для дальнейшего анализа нам в любом случае нужен полный список страниц сайта, которые мы хотим видеть в индексе.

Добываем эти данные из нескольких источников:

- Сам sitemap.

- Парсинг сайта специальными программами для техаудита (есть платные варианты, такие как Screaming Frog, есть бесплатные альтернативы).

- Информация от клиента, из админ-панели (бывают разделы, на которые не ведут внутренние ссылки и краулер их найти не способен).

Проверка индексации

Для более-менее крупных сайтов (уже от сотни страниц) всегда есть риск неполной индексации страниц. Меньше url в индексе – меньше трафика, чем могло бы быть.

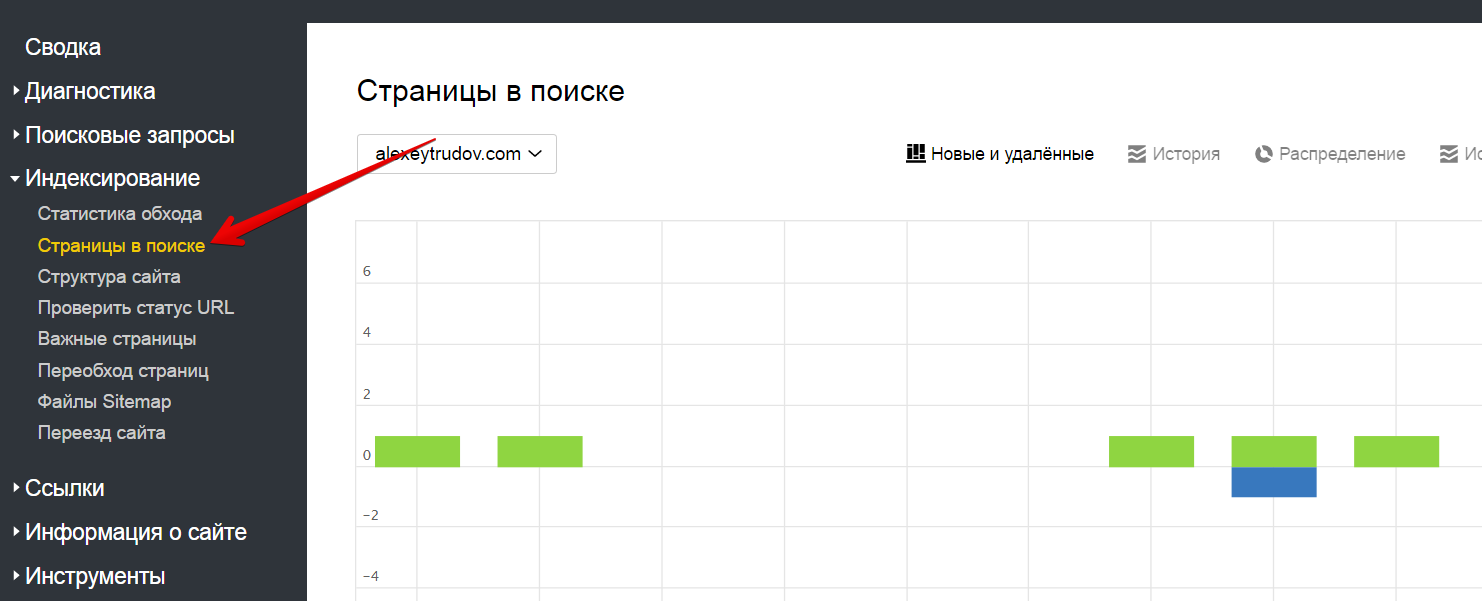

Для проверки индексации в Яндексе удобно использовать Яндекс.Вебмастер:

Выгружаем все страницы, фильтруем в Excel по статусу индексации и сравниваем со списком, который был составлен на предыдущем шаге.

Google не предоставляет столь подробной информации, поэтому приходится искать обходные пути. Подробно писал об этом в недавней статье Как найти непроиндексированные Google страницы без лишней возни и расходов.

По результатам этого шага у нас могут получиться три группы url:

Наибольший интерес представляют страницы:

- по ошибке попавшие в индекс (“мусорные” документы);

- с качественным контентом, которые отсутствуют в базе поисковых систем.

С “мусором” обычно все довольно просто, требуется лишь подобрать адекватный ситуации способ исключить их из индекса. Вариантов много:

- Мета-тег noindex (для технических страниц).

- Использование rel=canonical (для дублей – см. в справке Google).

- Отдача кода 404 – или, надежнее, 410 (для страниц, которых на сайте вообще быть не должно).

А вот с причинами отсутствия в индексе нужно поработать, рассмотрев все возможные гипотезы:

- Слишком молодой документ; робот просто не успел его обработать.

- Недостаточно качественная страница.

- Техническая ошибка на сайте (например, отдается 404 код).

- Документ старый, однако роботы его не посещали.

Проанализировать причины нам отчасти поможет тот же раздел Яндекс.Вебмастера – у исключенных из индекса страниц показываются короткие комментарии. Для определения страниц, не посещенных роботом Яндекса используется раздел “Статистика обхода”. Google не предоставляет такой информации, поэтому используем анализ логов сервера (см. следующий раздел).

Проверку кода ответа сервера делает большинство упомянутых выше программ для технического аудита.

Наиболее трудоемкая аналитика нужна для выявления различий между “качественными” и “некачественными” с точки зрения допущения в индекс страницами (проблема актуальна в основном для Яндекса; в Google некачественные url могут болтаться в индексе, просто не приносят трафика).

Общая схема достаточно проста – сравниваем страницы, которые устойчиво находятся в поиске, с теми, что никак не могут в него зайти или постоянно выпадают. Сложности в следующем:

- Могут влиять не только факторы самой страницы. Нельзя все сводить к уникальности контента (первое, что обычно приходит в голову).

- Необходимо сравнивать страницы с похожим потенциалом трафика и уровнем конкуренции в выдаче (вы поймете, почему это так, если ознакомитесь с постом Как устроен поиск Яндекса: два важных доклада из первых рук (заметки на полях) и моей недавней презентацией с SEMPRO.

- Важно выделить факторы, которые легко подтянуть до приемлемого уровня. Рекомендация “напишите на каждую из 10000 карточек товаров уникальный текст” вряд ли будет воспринята заказчиком с восторгом.

Анализ логов сервера

Access.log содержит ценную информацию о взаимодействии поисковых роботов с сайтом. Даже просто список url, на которые были заходы Googlebot и YandexBot – это возможность:

- Найти мусорные страницы низкого качества, которые не видит парсер, но о которых известно роботу. В том числе, кстати, это могут быть специально нагенерированные конкурентами url, подробнее см. в презентации из этого поста.

- Определить, какие разделы сайта получают мало визитов робота (если такой раздел содержит много страниц – это может привести к плохой индексации).

- Рассмотреть одну из причин отсутствия в индексе группы url из предыдущего шага.

V Анализ трафика

Изучение реальной статистики сайта может дать очень много ценной информации. Это прежде всего возможность посмотреть на проект с разных сторон, нащупать одни и те же проблемы в разных проявлениях.

Динамика количества страниц, приносящих трафик

Отличная метрика “здоровья” сайта, его видимости по низкочастотным запросам. В норме количество посадочных страниц растет или стабильно. Изменение этого показателя может служить для прогнозирования трафика. Тренд к снижению – повод озаботиться актуальностью контента, полнотой индексации и техническими ошибками. См. подробнее.

Разумеется, при анализе динамики нужно учитывать сезонность.

Выявление и анализ особых типов страниц

Страницы, потерявшие трафик

Эта проверка редко фигурирует в планах аудитов, однако я считаю ее абсолютно необходимой. Подробная статья о том, как находить и анализировать подобные страницы.

Страницы, на которых снизился трафик

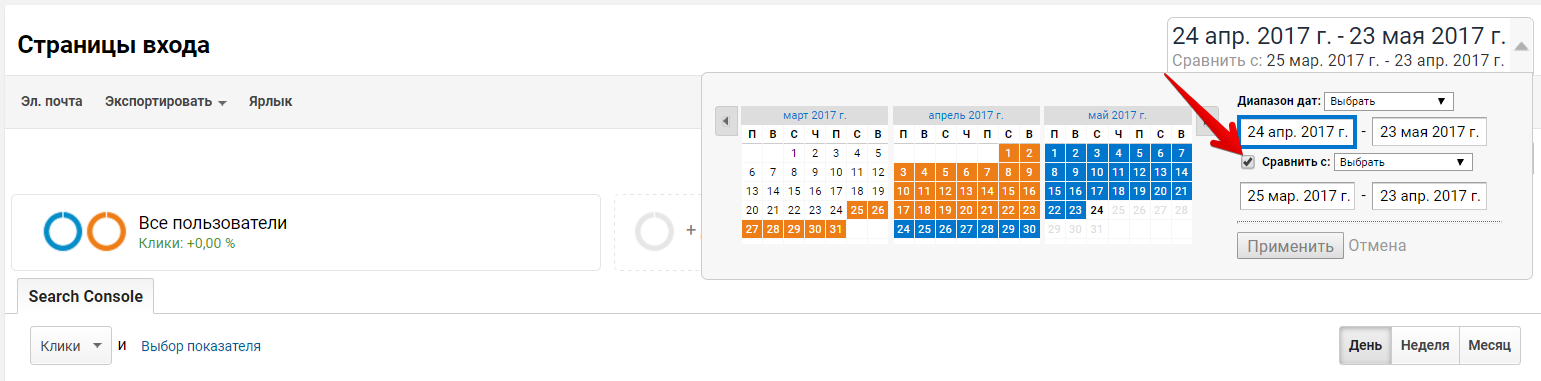

Чтобы найти такие url, сравниваем данные по страницам входа с предыдущим периодом. Например, в Google Analytics это делается так:

Если предыдущий пункт нацелен на выявление в первую очередь технических проблем благодаря массовому анализу, то на этом шаге мы собираем документы для тщательного ручного анализа по отдельности. Рассматриваем страницы с наибольшим объемом трафика и максимальной просадкой, ищем ее причины.

Страницы с потенциалом роста в одной из поисковых систем

Рунет находится в уникальной ситуации – у нас есть две поисковые системы, которые дают сопоставимый трафик. В разных тематиках соотношение Google/Яндекс неодинаково, однако в большинстве случаев сайту должны давать трафик и тот и другой поисковик.

Хороший способ нахождения перспективных для доработки и продвижения документов – это оценка соотношения трафика из разных поисковых систем в целом для сайта и для каждой конкретной страницы. Очевидно, что если доля Google во всем поисковом трафике 50%, а для определенной группы url всего 10%, то стоит заняться ими плотнее. Скорее всего, там уже есть контент, который соответствует запросам с ненулевой частотностью – и в Яндексе эти ключи исправно приносят много посетителей. Зачастую нужны лишь небольшие усилия, чтобы сделать страницу более релевантной для второго поисковика.

Страницы с плохими/ухудшившимися поведенческим факторами

Отбираем страницы с достаточно значительным поисковым трафиком (чтобы обеспечить статистическую достоверность) и находим те, у которых самый большой показатель откзазов/низкая глубина просмотра/малая продолжительность сессии. Эти страницы следует вручную проанализировать на предмет качества контента и его соответствия нуждам аудитории.

Анализ ключевых слов

Потерянные ключевые слова

Идея аналогична проверке страниц, потерявших трафик. Если ключевое слово все еще актуально и отличается ненулевым поисковым спросом, необходимо выяснить причины, по которым оно перестало работать.

Ключевые слова с понизившейся позицией

Определяются на основе данных Вебмастера, Search Console или стороннего сервиса съема позиций. Связки “сильно просевший запрос – страница” необходимо тщательно изучить. Часто здесь обнаруживаются либо техническая ошибка, либо замена контента или мета-тегов на менее релевантные, либо санкции поисковых систем.

Ключевые слова, дающие трафик на разные url

Часто это сигнал некорректного распределения контента по страницам и внутренней конкуренции. Наиболее явные случаи (когда объем трафика по разным страницам сопоставим) нужно изучить вручную для определения релевантной страницы, которая лучше всего отвечает целям бизнеса. Разумеется, выбрать страницу мало, это лишь первый шаг. Главное – разработать список мер для того, чтобы правильный выбор сделали поисковики.

Типичные способы:

- Правка и уточнение title, h1.

- Минимизация вхождений на нецелевой странице.

- Изменение перелинковки для максимизации количества ссылок с нужным анкором на целевой документ.

Ключевые слова за пределами ТОП-5, но с большим числом показов

Определяются на основе данных о позиции и показах в Вебмастере и Search Console. Часто это ключи, под которые не проводилась прицельная оптимизация. При этом у них хороший потенциал по трафику. Обычно не составляет особого труда подтянуть позиции и собрать достаточно трафика.

VI Анализ разделов

Сколько-нибудь крупный сайт неоднороден, он состоит из нескольких разделов, каждый из которых (при правильном структурировании контента) соответствует под-нише с собственным поисковым спросом, конкуренцией, паттернами поведения пользователей.

Поэтому адекватный аудит обязательно должен содержать сравнительный анализ разделов. Более того, без внимательной проработки сайта по частям нельзя быть уверенным, что на нем нет технических проблем. Показатели, которые мы проверяли для “отлова” проблем, легко могут искажаться различной динамикой по разделам.

Вот простой пример. Посмотрите внимательно на скриншот отчета по разделам для сайта, у которого бодро растет общий трафик:

Сам по себе анализ достаточно прост. Нужно лишь собрать данные по количеству страниц, индексации, трафику, конверсиям, ссылочной массе и так далее в сводную таблицу. Тогда проблемы и несоответствия проявляются как на ладони.

Без автоматизации строить толковое сравнение крайне утомительно. Поэтому я создал специальный отчет в своем сервисе https://bez-bubna.com/. Подробнее – в анонсе инструмента, там же примеры использования. Разумеется, никто не запрещает создавать аналогичные таблицы вручную, логика использования от этого не поменяется.

VII On-page оптимизация

Только на седьмом этапе мы приступаем к полноценному техническому аудиту – тому, что обычно и подразумевают под SEO-аудитом вообще. Это банальные, но важные проверки. Почему выполняем их именно сейчас, а не раньше? Вообще-то особой разницы нет. Однако к настоящему моменту мы “видим лес”, понимаем основные тенденции и проблемы. Можно не бояться утонуть в мелочах: наоборот, мелочи только углубят виденье и помогут сделать более достоверные выводы.

Большую часть анализа выполняют программы-краулеры, также много полезных данных содержат панели вебмастеров (см. “Оптимизация HTML” в Search Console и “Диагностика” в Яндекс.Вебмастере.

Анализ title

Важнейший элемент оптимизации – тег title. Требования к нему знает каждый сеошник; ключевыми являются уникальность, адекватное описание контента на странице и вхождения ключевых слов.

Очень многие сервисы и программы помечают как ошибку длину title более 60-65 символов. Я подробно писал об этом заблуждении, а потом провел отдельное исследование на большой выборке (см. в докладе c Allintop). Вывод однозначен – длина сугубо вторична; title формируем исходя из задач по продвижению.

Впрочем, слишком длинный тайтл (более 12 слов или 140 символов) может свидетельствовать о технической ошибке либо попытке впихнуть в заголовок запредельное количество ключевых слов.

Кстати, проверять уникальность title стоит с учетом морфологии. На больших проектах title (и страницы!) зачастую дублируются смыслу. Они не полностью совпадают, но содержат одни и те же леммы (базовые формы слов). Инструмента для автоматизации проверки на совпадение по леммам в публичном доступе нет, я пользуюсь собственной разработкой, которая скоро будет выложена в https://bez-bubna.com/.

Заголовки 1 уровня (h1)

Анализ схож с анализом title. Отличие здесь в том, что уникальность не строгое требование а рекомендация; в ряде случаев одинаковые h1 на разных страницах некритичны. H1 также должен присутствовать на странице в 1 экземпляре (современные HTML-стандарты позволяют использовать несколько, но лучше не ставить такие эксперименты на своем сайте, обойтись более традиционными схемами верстки).

Правильное использование других заголовков

Желательно, чтобы заголовки h1-h6 использовались только в пределах основного контента. Ленивые верстальщики часто озаглавливают с помощью h2 виджеты в сайтбаре, лучше избегать таких ситуаций. Поисковикам будет проще разобраться с контентом, если все заголовки будут относиться к нему.

Это не особо строгая рекомендация; велика вероятность, что поисковые системы разберутся в любой верстке, однако некорректное использование подзаголовков может, например, осложнить анализ с использованием автоматических сервисов оценки контента.

Description

Не влияет на ранжирование как таковой, однако может улучшать отображение в выдаче. По дублям и отсутствующим meta description можно найти проблемные страницы (сгенерированные по ошибке либо со слабой проработкой контента).

Битые ссылки

В идеале внутренние ссылки на сайте должны отдавать код 200. Допустимы также редиректы 302/301 (если они используются осознанно). А вот 404 ошибку после перехода по внутренней ссылке пользователь или робот получать не должны – необходимо следить за актуальностью контента.

Структура контента на страницах разных типов

Это не столько технический аудит, сколько комплексный – на уровне страницы. Требуется рассмотреть состав контента на типичных для сайта страницах и определить, насколько они отвечают интересам пользователей и задаче охвата ключевых слов.

Управление индексацией на уровне страниц

Настройки индексации в целом уже рассматривались выше; на этом этапе необходимо, отталкиваясь от проведенного анализа контента, определить, какие страницы имеет смысл допустить в индекс, а какие нет. Типичный вопрос – как поступить со страницами пагинации.

Более-менее универсальное решение – использовать на подстраницах мета-тег noindex,follow (разрешаем роботу переходить по ссылкам, чтобы не затруднять индексацию) – вполне рабочий вариант, однако он неидеален. Яндекс рекомендует использовать rel canonical, указывающий на первую страницу (что противоречит сути canonical). Оптимальным, но и самым сложным в реализации является оставление в индексе подстраниц с обязательным приданием им дополнительной ценности с помощью уникальных мета-тегов и соответствующего контента.

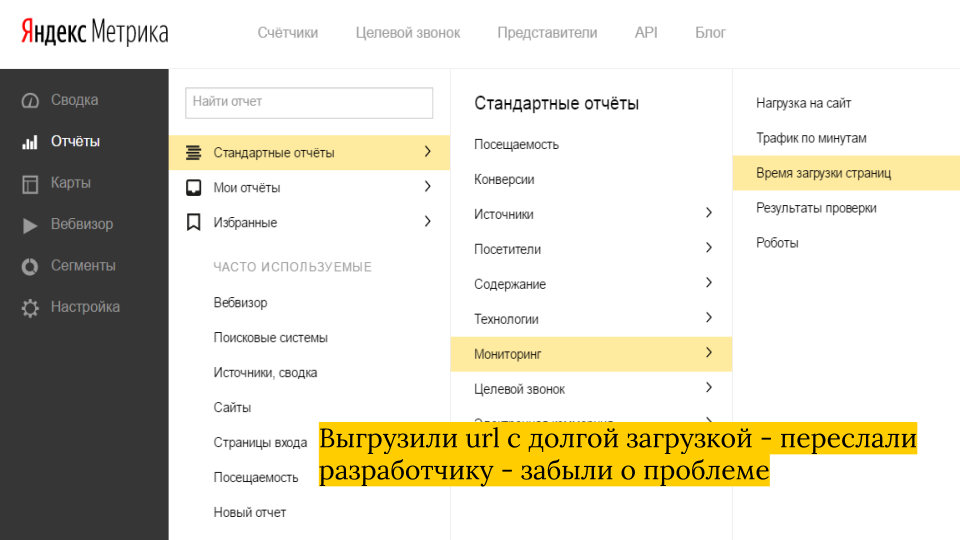

Скорость загрузки

Благодаря усилиям Google по пропаганде быстрых сайтов только ленивый не знает, что скорость загрузки – это фактор ранжирования. Еще более сильное влияние скорость оказывает на индексацию (краулинговый бюджет) и конверсию (никто не хочет ждать, пока загрузится медленный сайт).

Поэтому очень популярно вставлять в аудиты результат анализа в сервисе Page Speed Insights: https://developers.google.com/speed/pagespeed/insights/. Так делать – неправильно по целому ряду причин. Неоднократно касался этой темы (здесь и здесь). Самое главное – сервис измеряет НЕ скорость, а только показывает точки приложения усилий для ее улучшения.

Как же поступить, если самый популярный инструмент не подходит?

Во-первых, следует проверить все типы страниц (а не только главную!) в сервисах, которые меряют именно скорость. Например, тут: https://www.webpagetest.org/.

Во-вторых, массу реальных данных о скорости содержат системы аналитики. Слайд из упомянутого выше доклада:

VIII Отображение в выдаче

Все усилия по выталкиванию сайта в ТОПы пойдут прахом, если ссылка в выдаче не будет привлекать внимание и побуждать желаний по ней перейти.

На самом деле способов манипулировать отображением не слишком много и добиться пристойного отображения не так сложно.

Title с рекламным усилением

О ключевых словах мы уже позаботились, теперь не повредит усилить title, раскрыв преимущества страницы. Например, заголовок для этой статьи составлен по принципу “ключ (чек-лист по аудиту сайта) + рекламное усиление (самое подробное руководство)”.

Название взято из списка конкурсных тем. Я сам скорее стал бы хвастаться не подробностями (их может наворотить кто угодно), а системностью изложения и авторским подходом, который свободен от мифов а-ля “втискивайте тайтл в 60 символов, а то придет бабайка”.

Meta description

Также может показываться на выдаче как описание ссылки (далеко не всегда). Поэтому тоже пишем (составляем шаблоны) так, чтобы текст привлекал внимание и побуждал перейти на сайт.

Favicon

Иконка сайта отображается в выдаче Яндекса. Создаем привлекательный и яркий значок, загружаем на сайт и указываем на всех страницах с помощью ссылки на файл в секции head: <link rel=“shortcut icon” href=“/images/favicon.ico” type=“image/x-icon”>

Микроразметка

Микроразметка помогает структурировать сниппет (описание ссылки в выдаче) и добавить в него дополнительные данные. Рекомендации для разных типов сайтов можно найти в справке Яндекса а также в Search Console, в разделе “Вид в поиске”.

Оба поисковика имеют сервисы валидации микроразметки:

- https://webmaster.yandex.ru/tools/microtest/

- https://search.google.com/structured-data/testing-tool

Для интернет-магазинов альтернативой разметке отчасти может быть загрузка данных на Яндекс.Маркет.

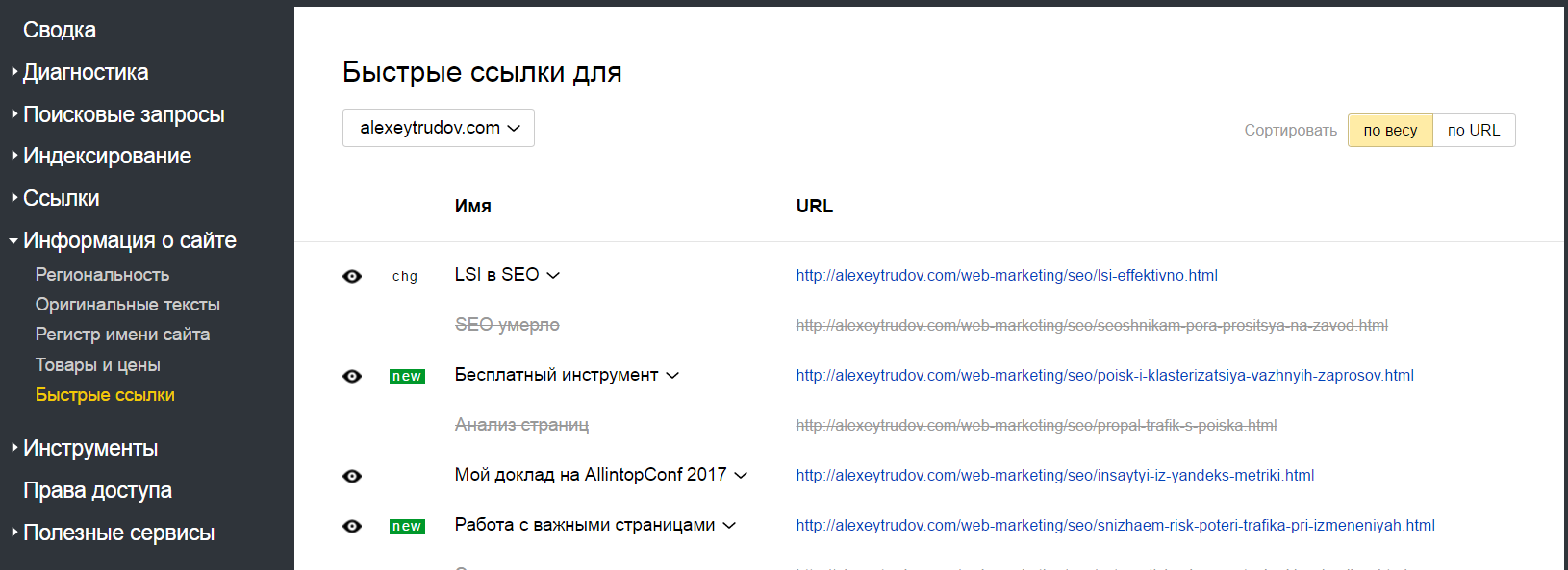

Быстрые ссылки

Формируются автоматически, для корректного создания нужна качественная структура сайта. Вебмастер позволяет модерировать их отображение на выдаче:

Спецсимволы

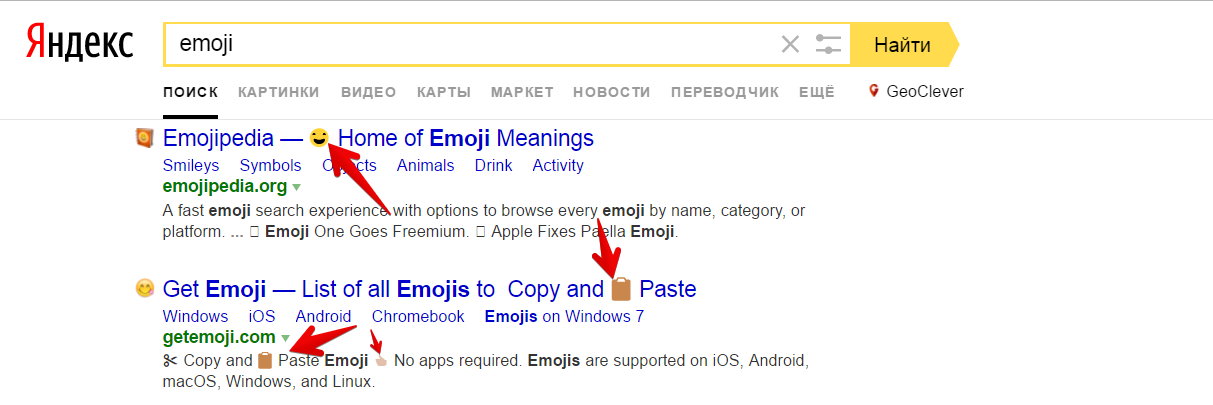

Иногда получается хорошо выделить сайт в выдаче благодаря включению в title или description символов-emoji:

Регистр сайта

В большинстве случаев отображение домена в выдаче мало влияет на кликабельность, однако не помешает “поиграть” с регистром на выдаче для лучшей читаемости. Инструмент доступен в Яндекс.Вебмастере.

Отдельные запросы с плохим CTR

Описанные настройки применяются ко всему сайту (либо учитываются на этапе создания контента). Однако в ходе анализа поисковых запросов можно выделить ключи, по которым сайт находится в ТОП, собирает много показов, но мало кликов. Их прорабатываем отдельно, определив интересы пользователя и то, насколько им соответствует ссылка на сайт в результатах поиска.

IX Анализ ссылочной массы

Как правило, для выявления основных тенденций достаточно данных из Яндекс.Вебмастера. Если в ходе анализа выяснится, например, что в последнее время наблюдается интенсивный прирост ссылок, то стоит проверить с помощью сторонних сервисов, таких как Ahrefs, Megaindex, Serpstat. Зачастую они реагируют быстрее.

Что требуется оценить в плане ссылок:

- Скорость прироста ссылочной массы, наличие/отсутствие “ссылочных взрывов”.

- Доля “плохих” ссылок – с явно коммерческими анкорами, на плохих донорах, легко определяемые как платные SEO-ссылки.

- Соответствие структуры сайта структуре ссылочной массы. Проще говоря, нацелены ли входящие ссылки на действительно важные страницы, нет ли среди продвигаемых документов тех, что вообще лишены бэклинков, не ссылается ли много сайтов на отсутствующие страницы и так далее. Подробнее см. здесь.

X Проверка на санкции поисковых систем, оценка рисков

Требования поисковых систем к качеству сайтов и “аккуратности” оптимизации постоянно растут. Количество контента в Интернете увеличивается, конкуренция становится жестче – поисковики могут без проблем устраивать “показательные порки”.

Не все санкции легко обнаружить по уведомлениям в Вебмастере или серьезной посадке трафика. Тот же Баден-Баден (свежий подарок от Яндекса) может накладываться на страницы. Поэтому даже если на сайте нет явных проблем с ранжированием, нужно проверить сайт на потенциально опасные элементы (переоптимизация, “раздувание” индекса большим количеством малоценных страниц, сомнительная реклама, кликджекинг и так далее).

Как правило, большинство сомнительных элементов к этому времени уже будут замечены в процессе других проверок. Однако не помешает и дополнительный анализ, например:

- Оценка страниц, которые находятся в индексе, но не приносят трафика, просевших фраз и т.д. (используем созданные ранее списки).

- Проверка отдельных важных страниц на запросные текстовые санкции в Яндексе (можно использовать, например, бесплатный сервис Евгения Кулакова: http://coolakov.ru/tools/new_filter/)

- Сопоставление трафика с Google и дат основных изменений алгоритма (с помощью бесплатного инструмента https://barracuda.digital/panguin-seo-tool/)

- Проверка статейного раздела на водность, “тошноту” по биграммам и триграммам (факторы, которыми отличаются попавшие под Баден-Баден страницы).

XI Дополнительные проверки, связанные со спецификой проекта

Предыдущие проверки были более-менее универсальными. Однако нужно учитывать тип проекта и проводить дополнительный анализ по важным именно для него направлениям. Три примера.

Интернет-магазины

- Анализ коммерческих факторов (ассортимент, данные о доставке, проработка карточек товара…) – на основе сравнительного анализа с успешными конкурентами. Сайт по коммерческим метрикам должен быть не хуже чем проекты в ТОП.

- Эффективность сочетания коммерческих и информационных запросов (не смешиваются ли они на одной странице, создавая проблемы для пользователя?).

Сайты услуг

- Тоже начинаем с коммерческих факторов (детализация контактной информации, раздел “о компании”, разнообразие систем поддержки пользователя) – аналогично, первым делом анализируем конкурентов, не пытаемся запихнуть сайт в шаблон.

- Адекватность контента задачам пользователя (частая проблема коропоративных ресурсов – они пишут инфостатьи в духе “как сделать своими руками” вместо того, чтобы рассказывать о своих услугах).

Контентные проекты

- Оценка эффективности разных типов контента (статьи, новости, посты в блог).

- Рекомендации для копирайтеров.

- Поиск путей повысить добавочную ценность сайта и увеличить количество посадочных страниц за счет дополнительных сервисов, каталогов и т.д.

XII Поиск эффективных путей развития проекта

Наконец мы добрались до главного. Улики собраны, есть понимание комплекса проблем сайта. Осталось на их основе найти те действия, что помогут именно в этом случае. Дать чек-лист здесь нельзя по понятным причинам, поэтому просто несколько примеров из практики.

Большой агрегатор

Проблема: малый процент проиндексированных страниц.

Предложено: изменить логику перелинковки так, чтобы она лучше подходила к механизму работы краулера и создать дополнительные хабы.

Результат: стремительный рост числа проиндексированных страниц и заходов по НЧ.

Сайт с UGC

Проблема: много контента хорошего качества, слабый поисковый трафик.

Предложено: автоматическое тегирование для охвата “вкусных” ключей, повышение стабильности индекса за счет постраничной аналитики, формирование перелинковки и дооптимизация на основе анализа поисковых фраз из API Метрики (как в эксперименте по автоматической вставке ключей, но более “человекообразно”).

Результат: кратный рост поискового трафика.

Молодой сайт объявлений

Проблема: исключительно неуникальный контент, мощные конкуренты.

Предложено: шаблоны title и инфоблоков для страниц формировать так, чтобы охватить семантику, с которой недостаточно плотно работают большие игроки.

Результат: уверенная динамика трафика с первых дней открытия проекта для индексации. См. кейс.

XIII Минимизация рисков, связанных с доработками

Любые изменения на сайте – серьезный риск. Даже если вы внедряете идеальный аудит силами команды с руками из плеч, то не застрахованы от просадок поискового трафика. Иногда (особенно при смене структуры url) от временного снижения посещаемости вообще никуда не деться. Поэтому наряду с обычным анализом как фундаментом для стратегии продвижения необходимо позаботиться о “страховке” на случай если что-то пойдет не так.

Вот распространенные способы снизить риски:

- Выявление важных страниц (приносящих много трафика и дающих много конверсий) и сохранение в текущем виде по крайней мере до тех пор, пока не появится эффект других рекомендаций. См. кейс, где было нарушено это правило + рекомендации.

- Правильный выбор момента для масштабных доработок. Лучше не трогать сайт в разгар сезона, когда поисковый спрос на пике. Готовимся к сезону заранее.

- Дополнительные сигналы о качестве сайта. Например, одновременно с изменениями начинаем регулярно публиковать качественные материалы в блог, проводим акцию в социальных сетях, стимулируем брендовый трафик оффлайн-рекламой.

XIV Оформление отчета

Повторю еще раз для тех, кто сразу пролистал в самый низ. Результаты аудита оформляются уже после того, как сделан сам анализ. Разумеется, делать черновые записи, готовить приложения никто не запрещает (да без них и не обойтись). Но отчет не должен содержать весь ваш путь проб и ошибок (это интересно только вам). Задача окончательного текста – помочь неспециалисту быстро и с комфортом разобраться в сути проблем и рекомендаций.

Очевидно, что для разных сайтов структура отчета будет отличаться – в зависимости от выявленных проблем и специфики. Однако практически всегда есть несколько универсальных блоков:

- SWOT-анализ: сильные и слабые стороны проекта, возможности и угрозы внешней среды.

- Анализ конкурентов.

- Стратегия на основе двух предыдущих пунктов.

- Основная часть (все, о чем шла речь в статье входит сюда).

- План доработок. Продуманная последовательность действий крайне важна. Выполнять рекомендации как попало – плохая идея. Пример: внедрили советы по ссылкам – добились роста позиций на недостаточно подготовленном сайте (не соответствует интересам пользователя, долго грузится). В итоге у поисковика накопилось достаточно негативной статистики по поведенческим и все снова провалилось за ТОП-20.

- Резюме – короткие выводы.

В заключение

Надеюсь, вы не утонули в деталях и мне удалось донести свой подход к анализу сайтов. Если нет, то сделаю последнюю попытку:

- В SEO нет незыблемых жестких правил.

- Любая рекомендация должна даваться не по “сайту вообще”, а по конкретному проекту, с пониманием его задач и ограничений.

- В первую очередь – приоритетные доработки, с высоким соотношением результат/затраты.

- Не стоит переоценивать “фишки” и “хаки” – в конечном счете решает системная работа.

- Не навреди!

Успехов вашим сайтам, увидимся в ТОПе!

Благодарю за материал! Однозначно в закладки!

Спасибо! Я старался 🙂

Зачем писать очевидные вещи, у меня в закладках даже отдельная папка есть “Трудов”, где скоро листинг материалов появится, не успеваю изучать и внедрять…….

Я работал в одной из сео контор (топовых) и скажу 100% – таких аудитов никто не делает, пусть даже если платят за аудит 1k$, никто абсолютно не хочет погружаться в бизнес, так как 300$ уйдет агенству, 150 продажнику, который аудит продал, 100-150 аккаунт менеджеру, еще 100-250 тому, кто этот аудит проведет, а так как все на потоке, то нужно в месяц аудитов 20-50 делать. Поэтому однозначно в закладки).

Лучший коммент 🙂

Спасибо за цифры!

Сергей, да вообще-то 1000$ – это низкая цена для аудита. Только для какого-то небольшого сайта.

Но там и сам аудит не предполагает такого количества проверок.

а в целом – хорошая статья. Даже указана ссылка на barracuda.digital. Рад, что Алексей даже такой сервис знает.

Спасибо!

Сервисов я еще много знаю 🙂 В принципе статью можно было раздуть еще раза в два (подробнее пройтись по поведенческим, по той же диагностике санкций, по техничке много мелких нюансов…). Но принципы и общая канва важнее, все остальное можно нагуглить по ходу.

Материал суперский! Желаю выиграть!

Благодарю 🙂

Это победа, пакуй чемоданы на отдых деньги считай есть:)

😀

ну просто АХУИТЕЛЬНАЯ статья!!!!!!!!! я круче не видел разбора аудита, все везде какое-то общее, вода, мало конкретики, я прям читал замерев дыхание!!!

Спасибо!

Я обычно мат удаляю из комментариев, но в этом случае рука не поднялась 🙂

Алексей, это твое лучшее произведение!!! шедевр просто)

Привет. Класс! Сколько ночей писал? Весь траф теперь будет на нее, покажешь динамику? Спасибо.

Писал часов 20-25 – по полдня с понедельника.

Для трафа над ней нужно поработать будет еще, тот же заголовок прямо из конкурса, не самый оптимальный. Покажу, если интересно, напомни попозже, когда стата накопится.

Приятно вас читать, Алексей. Умно, грамотно, логично изложено.

Я только вступаю на путь SEO, но уже понимаю её важность для сайта. Только вот как показать это клиенту и руководителю (студия по разработке веб-ресурсов)? А то затраты времени получаются неадекватными оплате. Но и планку снижать не хочется.

П.С. Можно использовать текст статьи в своём чек-листе?

Рад, что понравилось!

Описанный порядок действий подходит в первую очередь для сложных проектов, где SEO – важный канал. Соответственно, владелец это понимает и с оплатой вопросов возникать не должно. Вообще, баланс расходы/эффект нужно искать всегда в каждом конкретном случае (статья как раз про это).

Да, пожалуйста. Если будете где-то публиковать – то буду благодарен за ссылку на мой пост.

Опечатка “большой агегатор”

Спасибо! Поправил.

Статья действительно супер. Правда, ну очень большая и насыщенная инфой. Читал дня 3 наверное.

У меня вопрос: а сколько по твоему должен стоить такой аудит? Или за сколько обычно ты такие аудиты продаешь? (в этом описании столько ручной работы, что я даже представить не могу сколько такой аудит в реальности должен стоить).

Дмитрий, спасибо!

Да, работы очень много (+ на конкретных сайтах могут потребоваться доп. проверки + по техничке той же бездна нюансов).

Сейчас полный аудит стоит 100 тысяч рублей; в пересчете на часы выходит не так уж дорого. Продаю и менее комплексные варианты (см. http://optimumprofit.ru/#pricing-table), но подумываю от них отказаться. Все-таки соль именно в последних шагах, которые невозможно выполнить качественно без всестороннего анализа.

Самая емкая статья, которую я когда-либо встречал по аудита сайта. многим псевдо сео-студиям нужно брать на заметку. О Serpstat слышал и раньше, ваш материал убедил его изучить – очень интересная платформа. Спасибо за ваш труд, однозначно подписка!

Благодарю!

Алексей, добрый день! Очень подробный чек лист получился. Спасибо

Возможно не заметил, но про поиск дублей в Title не нашел информации (как находить, нужно ли убирать, если это страницы на сервисе отображаются после авторизации (например с помощью соц. сетей) ) ?

Рад, что понравилось!

Про дубли title есть, коротко: https://monosnap.com/file/7VSGn23gmGWckWI3y8TWBFn4jf6dH0

Все-таки большую часть работы тут выполняют программы-парсеры, так что особо останавливаться нет смысла. Не совсем понял насчет страниц после авторизации. Если страницы недоступны поисковому роботу, то особой проблемы в дублях нет. Другое дело что и пользователям может быть удобнее на сайте с тщательно прописанными тайтлами для ориентации по вкладкам.

Да, этот фрагмент я также прочитал. После авторизации контент страниц доступен поисковым системам.

Спасибо вам! У вас очень интересные и глубокие статьи!

Не уловил все-таки как это происходит. Роботы же не выполняют авторизацию. Может приведете пример?

Пожалуйста 🙂

Мда, устал читать, но мыслей умных много 🙂

И по чем ты делаешь такие аудиты, Алексей? если не секрет.

Посмотрел цены! Ну норм че, за такие деньги можно заморочиться 🙂

Ага 🙂

Статья действительно полезная и насыщенная информацией. Вот что значит, человек фанатеет по тому, что делает. Правда, тенденция на такие аудиты, наверное, не большая. Много клиентов не готовы платить много. Студии не готовы “за спасибо” тратить неделю или больше времени на такую аналитику. Поэтому, такой пул работ, скорее всего, редкость. Статья, наверное, даст глоток воздуха таким как я, любознательным, тем, кто просто, как слесарь, любить покопаться в “железе”, в нашем случае массивы данных:) Леше спасибо за 20-25 часов, проведенных в написании контента!

Пожалуйста, рад, что понравилось!

Все верно. Но лично мне много заказов и не осилить, так что хватает с избытком.

Алексей, спасибо тебе огромное!

Статья ну очень полезная.

Пожалуйста! Здорово, что пригодилась!

Статья мега крутая. Тсавлю в закладки!

Спасибо! 🙂

спасибо за материал. очень интересно было почитать))

Алексей, а сколько по времени вы делаете такой аудит?

Александр, рад, что понравилось.

Обычно 60-80 рабочих часов.

Алексей, большое спасибо за материал. Подробнее ничего не видел. Респект!

Вы как-то писали, что делали аудиты чуть ли не конвейерным способом. А где искали клиентов? Фриланс?

Андрей, здорово, рад, что понравилось!

На самом деле я даже когда все время посвящал консалтингу, делал довольно глубокие аудиты (хотя и не такие как описано в статье) с соответствующими затратами времени. Так что в месяц обрабатывал в районе 10 заявок, редко когда больше. В основном клиенты приходили по сарафану, из оффлайна (посещал много бизнес-мероприятий) и из блога (с органики). Чуть-чуть контекстом тоже баловавался.

Алексей, нужно ли в Titlte добавлять разделитель и название сайта?

Непосредственно для текстовой оптимизации – нет. Другой вопрос, что это может пригодиться по другим причинам. Например, если с сайтом уже связан сильный бренд, то упоминание его в title может повысить CTR.

Лучшая статья на эту тему. Схоронил!)

Спасибо!

спасибо за отличный материал!

еще бы пример отчета бы для клиента… было бы вообще огонь))

Рад что понравилось!

Примеры по понятным причинам не выкладываю 🙂

Хорошая статья, хороший подход, надеюсь такой же и траф:)

Только так никто не делает… и все (кроме заказчиков) понимают почему…

Спасибо!

Я так делаю. Правда теперь не чаще нескольких раз в год 🙂

Вооот. Главное. Получить доступ к Метрике и гугл.аналитик. С этого и надо начинать. Примерно 99% запросов от владельцев сайта звучат примерно так: “мы дали вам ссылку на сайт, зайдите в него, посмотрите в свободное время, проанализируйте”. Ни о каком доступе к статистики речи быть не может, зачастую эти сервисы отсутствуют вовсе. Движок сайта тоже часто приходится угадывать по коду. Так что большая часть проблемы SEO – аудита – тотальная паранойя у заказчиков и полное непонимание принципов работы SEO. Вполне понимаю ваше нежелание двигать сайты самостоятельно, после первой проверки часто выясняется, что сайты для SEO годятся только после капитальной переработки.

Все верно!

И описанные вами ситуации – одна из причин, почему я завел блог: просто чтобы не объяснять одно и то же по сотому разу, а кидать ссылочки 🙂

Алексей, здравствуйте!

Спустя годы, текст все равно “мега актуальный” и полезный!

Маленькое примечание: как на счет добавить кнопку к форме подписки для большего удобства?) http://prntscr.com/txyxzz

Спасибо!

Дельное замечание, очень. Но это стандартный фукнционал стороннего сервиса, нужно переезжать на новый или пилить что-то свое. Вряд ли этим смогу заняться в обозримом будущем.